NVIDIA GeForce GTX 680 kommer att bli en direkt konkurrent till AMD:s flaggskepp, och nu har specifikationerna och vad som ser ut att vara prestandasiffror dykt upp på nätet. Det ser ut som att GTX 680 kommer ge AMD någonting att tänka på.

NVIDIA:s Kepler har varit en av de mest omryktade lanseringarna på länge, detta då NVIDIA ska ha introducerat en ny arkitektur men även sagt till NordicHardware att de förväntat sig mer av AMD:s nya arkitektur. Nu dyker de första prestandasiffrorna upp, och det ser i alla fall bra ut på pappret.

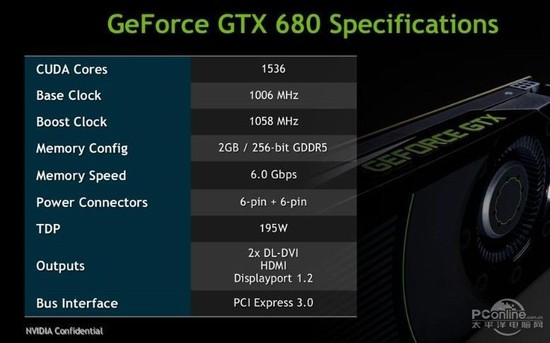

GPU:n som tros vara GK104, kommer med 1 536 CUDA-kärnor klockade till 1 006 MHz och 1 058 MHz i någonting som kallas för Boost Clock. Vi ser att kortet har en minnesbuss på endast 256-bit, men med en klockfrekvens på 1 500 MHz (6 000 MHz effektivt) på GDDR5-minnet resulterar det i att GTX 680 får ungefär samma bandbredd som ett GTX 580 – 192 GB/s. Kortet ska har ett TDP-värde på 195W, och får därför enbart två 6-pin-kontakter för extra strömförsörjning. NVIDIA ser även ut att stödja PCI Express 3.0 precis som konkurrenten, och får två DVI, en HDMI och en DisplayPort för bildskärmar.

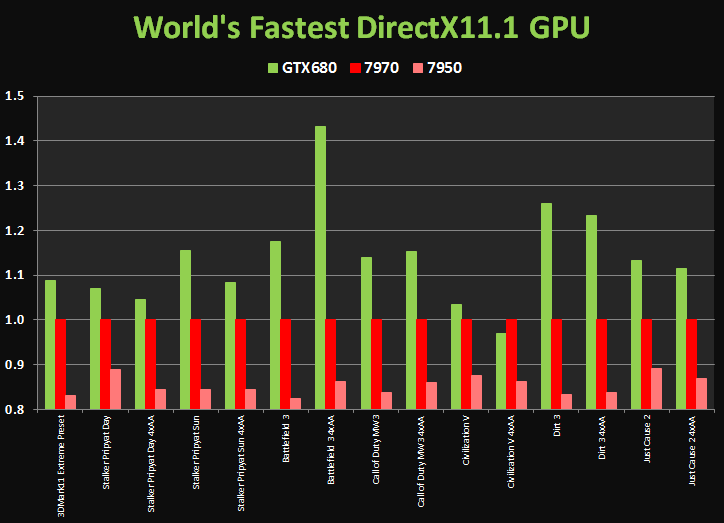

Över till prestandan så ser kortet ut att som sämst ligga marginellt lägre än HD 7970, och vara upp till strax över 40 procent bättre. I genomsnitt ser det dock ut att lägga sig runt 18 procent högre än HD 7970, och värt att notera med detta i åtanke är att AMD:s grafikkort är specificerat på 250W.

Exakt hur mycket dessa specifikationer och prestandasiffror stämmer låter vi vara osagt. Men förutsatt att det här är korrekt information, ser det ut som att NVIDIA har en riktig vinnare i sin hand och lyckats leverera en strömsnål arkitektur.

[img [/img]

[/img]

Nvidia vs amd anger väl olika sätt att mäta TDP eller?

[quote name=”flopper”]Nvidia vs amd anger väl olika sätt att mäta TDP eller?[/quote]

[img [/img]

[/img]

[quote name=”flopper”]Nvidia vs amd anger väl olika sätt att mäta TDP eller?[/quote]

Det stämmer, men det handlar fortfarande än två stycker 6-pin-kontakter. Även om de mäter effektförbrukning annorlunda, så vill varken AMD eller NVIDIA gå utanför PCI-SIG:s ramar. Det är alltså inte fel att säga att NVIDIA:s kort med största sannolikhet kommer ha lägre strömförbrukning med det i åtanke.

Tack för dagens största lol Farrisen. 😀

Men ja, det ser ganska bra ut om man säger så..

Ser bra ut detta ja. 🙂 Frågan är om AMD har ett äss i rockärmen.

Är detta Nvidias flaggskepp?

[quote name=”Anton Karmehed”]Tack för dagens största lol Farrisen. 😀

Men ja, det ser ganska bra ut om man säger så..[/quote]

Så lite så 🙂

[quote name=”ultimatte”]Är detta Nvidias flaggskepp?[/quote]

Nej det kommer en GPU till med mer kräm, så det ser ju onekligen ganska bra. Å andra sidan så är det ju Nvidia själva som skrivit. Och som vanligts å är det ett ett ypperligt exempel på hur man INTE ska göra ett diagram.

Ser intressant ut och om dessa siffror stämmer så är det AMDs tur “hitta på” nåt.

Men jag blir så SUR på såna där grafer som börjar på 0,8 bara för det ska se ut det är JÄTTEstor skillnad mellan 1.0 och 1.2 🙁

Man borde göra om dem…

He, och jag spelar ju nästan bara Civilization (iofs IV hittills…) ska välja AMD ändå…

[img [/img]

[/img]

Gjorde om grafen till lite mer vettigare format =P

Hmmm…

Ok, det är lättare att räkna procenten men… Känns det inte lite konstigt att lägga konkurrentens kort som 1 (100%) norm…? Som om AMD skulle vara ett normaltillstånd (vilket det är i detta hushåll) 😛

Skickar lite lillebrorskomplexvibbar

När det handlar om en direkt jämförelse blir det mer naturligt att lägga konkurrentens kort som ett base-value, i det här fallet HD 7970 som får agera 100%. Det blir dessutom lättare att läsa av (iaf om ni frågar mig).

[quote name=”pippen1001″][img [/img]

[/img]

Gjorde om grafen till lite mer vettigare format =P[/quote]

*applåder!!!*

Trots att jag är nvidia fanboy så hade ja hoppats på mer än så från nVidias håll – iaf efter deras brutala uttalanden om amd.

Jag hoppas därför att dom släpper en riktig värsting snart så att dom får lite underlag för sitt rejäla skryt.

nVidia har ju även skrytit om TDP så ja hoppas dom nu även fått en bra idle.

Men GTX680’s överlägsenhet i Fragbite-motorn är aldrig fel iaf!

pippen1001: Tack för ett mer rättvisande diagram. 🙂

Farrisen: haha – flopper bjöd på en cockblocker eller 🙂

[quote name=”S0urcerr0R”]

Farrisen: haha – flopper bjöd på en cockblocker eller :)[/quote]

Haha, ja han kan ju inte komma här och använda logik>< Men som Herr Hugosson (smartidiot) säger , så luktar det ju som att Kepler kommer vara snålare med ström 😉

Vi får ju inte glömma att AMD haft sitt kort ute nästan tre månader längre en Nvidia

[quote name=”Yberhydro”]Vi får ju inte glömma att AMD haft sitt kort ute nästan tre månader längre en Nvidia[/quote]

Och poängen är vad?

Att prestandan för ett GeForce GTX 680 är mindre imponerade?

[quote name=”McKinley”][quote name=”Yberhydro”]Vi får ju inte glömma att AMD haft sitt kort ute nästan tre månader längre en Nvidia[/quote]

Och poängen är vad?

Att prestandan för ett GeForce GTX 680 är mindre imponerade?[/quote]

Nej den är helt klart imponerande. men 3 månader är lång tid i dessa sammanhang, dem har ju levt en fjärdedel av sitt “liv” tills nästa generation kommer

Men borde det inte vara mer intressant att lägga gtx580 som hundra procent så man ser hur mycket bättre det nya kortet presterar? Detta känns mest som sandlåda.

[quote name=”Yberhydro”][quote name=”McKinley”][quote name=”Yberhydro”]Vi får ju inte glömma att AMD haft sitt kort ute nästan tre månader längre en Nvidia[/quote]

Och poängen är vad?

Att prestandan för ett GeForce GTX 680 är mindre imponerade?[/quote]

Nej den är helt klart imponerande. men 3 månader är lång tid i dessa sammanhang, dem har ju levt en fjärdedel av sitt “liv” tills nästa generation kommer[/quote]

Kom ihåg att ny generation betyder inte alltid att man slår konkurrentens värstingkort från förra generationen.

AMD är tyvärr ett bevis på det både i när det gäller processorn och grafikkortet.