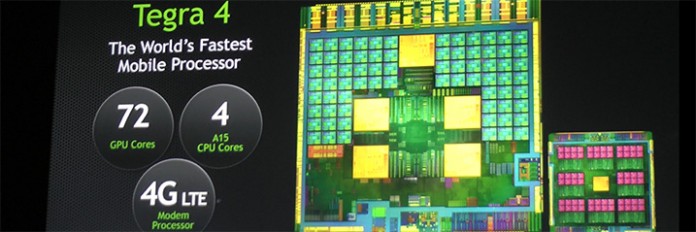

Precis som väntat var Tegra 4 en av höjdpunkterna när Nvidia höll hov under sin presskonferens på CES 2013. Den nya processorkretsen ska enligt tillverkaren bli den kraftfullaste på marknaden med fyra Cortex-A15 CPU-kärnor samt en grafikdel med hela 72 kärnor.

I samband med tillkännagivandet av Tegra 4 passade Nvidia även på att prata sig varma om deras första mjukvarumodem – Icera 500. Ett programmeringsbart 4G/LTE-modem som med sin nya arkitektur är 40 procent mindre än konkurrerande lösningar.

Nvidia visade bland annat hur deras nya Tegra 4 processor kan använda sin kraftfulla arkitektur för att rendera hemsidor nära nog dubbelt så snabbt som surfplattan Nexus 10. Tegra 4 ska också vara den första kretsen som gör det möjligt att alltid fota bilder med HDR-teknik för bättre ljussättning i bilder, något som idag kan ta flera sekunder per bild men som med Tegra 4 ska ta runt 0,2 sekunder.

När de första enheterna med Tegra 4 dyker upp på marknaden är oklart, men vad det verkar är Nvidias egna spelkonsol Project Shield en av de första produkterna med denna krets.

Med tanke på att Samsung kommer hinna ut med sin Enyxos 54-serie innan så tvivlar jag starkt på att Tegra 4 kommer att bli snabbast när det kommer.

Enligt Ars Technica: “Tegra 4’s sheer size and power requirements mean that it’s probably not destined for smartphones.”

Fota allt i HDR…… om du har med dig din tablet 🙂

[quote name=”Zelog”]Enligt Ars Technica: “Tegra 4’s sheer size and power requirements mean that it’s probably not destined for smartphones.” Fota allt i HDR…… om du har med dig din tablet :)[/quote] Är helt övertygad om att det kommer kolla olika versioner av Tegra 4 var av en del avsedda för telemarknaden. Stämmer dessutom tyckena angående deras 4G/LTE-modem som ska vara extremt energisnålt så har jag svårt att se att de kommer låta bli mobiltelefonerna. Edit: Enligt nVidia själva så kommer bättre design samt krympt tillverkningsprocess till 28nm leda till 45% lägre energi förbrukning än Tegra 3. Edit 2: Passar på… Läs hela »

[quote name=”Morkul”]Med tanke på att Samsung kommer hinna ut med sin Enyxos 54-serie innan så tvivlar jag starkt på att Tegra 4 kommer att bli snabbast när det kommer.[/quote]

DU vet att Exynos 5 serien redan sitter i Nexus 10? Skillnaden på denna och Samsungs egna lär väl bli en quadcore istället för dualcore som sitter i nu. GPUn blir väl inte 604 som nu utan en 658. Men sen så får man se. Är Samsung samma lögnaktiga slödder så kan dom bygga in en förbannad Tidsmaskin jag är ändå inte sugen.

[quote name=”Morkul”][quote name=”Zelog”]Enligt Ars Technica: “Tegra 4’s sheer size and power requirements mean that it’s probably not destined for smartphones.” Fota allt i HDR…… om du har med dig din tablet :)[/quote] Är helt övertygad om att det kommer kolla olika versioner av Tegra 4 var av en del avsedda för telemarknaden. Stämmer dessutom tyckena angående deras 4G/LTE-modem som ska vara extremt energisnålt så har jag svårt att se att de kommer låta bli mobiltelefonerna. Edit: Enligt nVidia själva så kommer bättre design samt krympt tillverkningsprocess till 28nm leda till 45% lägre energi förbrukning än Tegra 3. Edit 2: Passar… Läs hela »

[quote name=”GammalRäv”][quote name=”Morkul”]Med tanke på att Samsung kommer hinna ut med sin Enyxos 54-serie innan så tvivlar jag starkt på att Tegra 4 kommer att bli snabbast när det kommer.[/quote]DU vet att Exynos 5 serien redan sitter i Nexus 10? Skillnaden på denna och Samsungs egna lär väl bli en quadcore istället för dualcore som sitter i nu. GPUn blir väl inte 604 som nu utan en 658. Men sen så får man se. Är Samsung samma lögnaktiga slödder så kan dom bygga in en förbannad Tidsmaskin jag är ändå inte sugen.[/quote] Ja Enyxos 52-serien men nu pratade jag om… Läs hela »

[quote name=”Tempel”][quote name=”Morkul”][quote name=”Zelog”]Enligt Ars Technica: “Tegra 4’s sheer size and power requirements mean that it’s probably not destined for smartphones.” Fota allt i HDR…… om du har med dig din tablet :)[/quote] Är helt övertygad om att det kommer kolla olika versioner av Tegra 4 var av en del avsedda för telemarknaden. Stämmer dessutom tyckena angående deras 4G/LTE-modem som ska vara extremt energisnålt så har jag svårt att se att de kommer låta bli mobiltelefonerna. Edit: Enligt nVidia själva så kommer bättre design samt krympt tillverkningsprocess till 28nm leda till 45% lägre energi förbrukning än Tegra 3. Edit 2:… Läs hela »

[quote name=”Zelog”]Enligt Ars Technica: “Tegra 4’s sheer size and power requirements mean that it’s probably not destined for smartphones.”

Fota allt i HDR…… om du har med dig din tablet :)[/quote]

Tegra 4 är 81 mm2 precis som Tegra 3. Värme kan bli ett problem men det är ingen som säger att den måste vara 1,9 GHz i en telefon

[quote name=”Bobby1″][quote name=”Zelog”]Enligt Ars Technica: “Tegra 4’s sheer size and power requirements mean that it’s probably not destined for smartphones.” Fota allt i HDR…… om du har med dig din tablet :)[/quote] Tegra 4 är 81 mm2 precis som Tegra 3. Värme kan bli ett problem men det är ingen som säger att den måste vara 1,9 GHz i en telefon[/quote] Efter att ha läst igenom Ars Technicas hela artikel blir man desillusionerad. Man kan nämligen börja undra om de ens har läst/hört på vad nVidia har sagt för det är mer än “size and Power” som de har fakta… Läs hela »

Efter att läst detta djuplodande test av AnandTech

http://www.anandtech.com/show/6536/arm-vs-x86-the-real-showdown/8

så ställs ju en del tvivel på hur bra Cortex A15 verkligen är. ARMs stora fördel har ju varit väldigt låg absolut strömförbrukning och väldigt låg Joule/uppgift.

Cortex A15 är sämre än dagens Atom i båda dessa och även sämre än Cortex A9 och Krait. Att Joule/uppgift går bakåt är verkligen illa, skulle säga att det gör A15 till en sämre design än A9/Krait givet vad dessa SoC är tänkt att användas till.

[quote name=”Uridium”]Efter att läst detta djuplodande test av AnandTechhttp://www.anandtech.com/show/6536/arm-vs-x86-the-real-showdown/8 så ställs ju en del tvivel på hur bra Cortex A15 verkligen är. ARMs stora fördel har ju varit väldigt låg absolut strömförbrukning och väldigt låg Joule/uppgift. Cortex A15 är sämre än dagens Atom i båda dessa och även sämre än Cortex A9 och Krait. Att Joule/uppgift går bakåt är verkligen illa, skulle säga att det gör A15 till en sämre design än A9/Krait givet vad dessa SoC är tänkt att användas till.[/quote] Förutom att de gör en hel del felaktiga antaganden och felmätningar 😉 Att jämföra två olika system där… Läs hela »

Jag blir en smula skeptisk när testerna är gjorda av en ingenjör Intel skickade till Anandtech. Jag tycker Anand är lite småful redan när han sitter och kör javascript test och använder Chrome som inte har uppdaterats på länge för Android, han är smart nog att veta om att det påverkar resultaten men ändå visar han upp vilseledande tester

Cortex A15 är nog garanterat mer strömslukande än Cortex A9/Krait. Men ARMs tanke är snarare att man ska använda den sparsamt i en big.Little kombination tillsammans med Cortex A7 processor (samma prestanda som A9 fast 60% strömsnålare)

[quote name=”Morkul”]Förutom att de gör en hel del felaktiga antaganden och felmätningar 😉 Att jämföra två olika system där skärmarna, som står för den stora delen av energiförbrukningen, har så extremt olika upplösningar är ju bara löjligt. Acer W510 har en upplösning på 1366*768Nexus 10 har en upplösning på 2560*1600 De två maskinerna går helt enkelt inte att jämföra.[/quote] Läs artikeln igen… Man mäter strömförbrukningen direkt på benen för CPU resp. GPU. Det enda som skiljer, vilket också påpekas flera gånger, är att L2-cache har en egen strömförsörjning för Krait och därmed får just detta SoC något lägre strömförbrukningsvärden för… Läs hela »

[quote name=”Uridium”]Läs artikeln igen… Man mäter strömförbrukningen direkt på benen för CPU resp. GPU. Det enda som skiljer, vilket också påpekas flera gånger, är att L2-cache har en egen strömförsörjning för Krait och därmed får just detta SoC något lägre strömförbrukningsvärden för CPU-delen än Cortex A9, A15 och Atom.[/quote] Tycker även du ska läsa igenom den igen eftersom det förekommer en del faktafel. Bland annat är det helt omöjligt att mäta en Nexux 10 på “benen”. Kanske inte helt omöjligt på Microsoft Sorfice TR men i alla fall extremt svårt och siffrorna kommer vara långt ifrån pålitliga. De andra två… Läs hela »

“AnandTech har ju haft tillgång till alla prylarna i sitt labb och kunnat verifiera siffrorna” lol.. Det handlar inte om att det är falska siffror. Detta kallas för “cherry picking”. Man väljer situationer som är fördelaktiga för ens slutsats (Intel is awesome) och presenterar det som fakta. Jag menar kolla resonemanget på sista sidan. Eftersom Exynos 5250s max TDP är 8W (en siffra som den ALDRIG uppnår eftersom både CPU och GPU maxar inte samtidigt) så påstår Anand att Haswell nu kan konkurrera eftersom den också har en 8 W TDP, det Anand glömmer att nämna är ju att Intel… Läs hela »

[quote name=”Bobby1″]lol.. Det handlar inte om att det är falska siffror. Detta kallas för “cherry picking”. Man väljer situationer som är fördelaktiga för ens slutsats (Intel is awesome) och presenterar det som fakta. Jag menar kolla resonemanget på sista sidan. Eftersom Exynos 5250s max TDP är 8W (en siffra som den ALDRIG uppnår eftersom både CPU och GPU maxar inte samtidigt) så påstår Anand att Haswell nu kan konkurrera eftersom den också har en 8 W TDP, det Anand glömmer att nämna är ju att Intel räknar det helt annorlunda, 8 W är inte dess max TDP utan vad den… Läs hela »

[quote name=”Morkul”]Tycker även du ska läsa igenom den igen eftersom det förekommer en del faktafel. Bland annat är det helt omöjligt att mäta en Nexux 10 på “benen”. Kanske inte helt omöjligt på Microsoft Sorfice TR men i alla fall extremt svårt och siffrorna kommer vara långt ifrån pålitliga. De andra två enheterna har jag inte haft möjligheten att undersöka själv. Ett alternativ är att man fått developers exemplar av Nexus 10 och då säger testerna absolut ingenting. Men om man nu på något magiskt sätt skulle få till en mätpunkt på Nexus 10 så är testet fortfarande helt poänglöst.… Läs hela »

[quote name=”Uridium”]Du har verkligen absolut inget som helst förtroende för att Intel kan skapa en produkt som är bra i bemärkelsen “drar lite ström och presterar väl i förhållande till konkurrerande produkter” 😉 Titta på de mätningar på både prestanda och kanske framförallt batteritid för Z2760 baserade plattor, de ligger ju i topp i båda kategorierna. Så det kan inte vara en så djävla usel plattform…[/quote] Jo då nog har jag fullt förtroende på att Intel kommer kunna komma fram med en bra produkt när det kommer till förbrukning/prestanda. De är enligt mig inte där ännu dock. Tycker just testet… Läs hela »

[quote name=”Morkul”]Jo då not har jag fullt förtroende på att Intel kommer kunna komma fram med en bra produkt när det kommer till förbrukning/prestanda. De är enligt mig inte där ännu dock. Tycker just testet som länkades är bevis nog för det. Exakt hur de mäter är inte redovisat. Ska man tro på det som de skriver så kommer Intel per automatik få enorma fördelar och trots detta så är det inga enorma skillnader.[/quote] Det jag menade var: titta på de tester/mätningar gjorda på Z2760-baserade Win8 plattor. De står sig extremt väl i både prestanda och batteritid mot iPad, Android… Läs hela »

[quote name=”Uridium”][quote name=”Morkul”]Jo då not har jag fullt förtroende på att Intel kommer kunna komma fram med en bra produkt när det kommer till förbrukning/prestanda. De är enligt mig inte där ännu dock. Tycker just testet som länkades är bevis nog för det. Exakt hur de mäter är inte redovisat. Ska man tro på det som de skriver så kommer Intel per automatik få enorma fördelar och trots detta så är det inga enorma skillnader.[/quote] Det jag menade var: titta på de tester/mätningar gjorda på Z2760-baserade Win8 plattor. De står sig extremt väl i både prestanda och batteritid mot iPad,… Läs hela »