KRÖNIKA Inom en snar framtid kommer det vara närmast omöjligt att köpa en processor utan att få med en grafikkrets på köpet. Processorjätten Intel är redan på god väg och tillsammans med AMD satsar man på full integration med sina nya Sandy Bridge och Fusion-arkitekturer. Framtiden är redan utstakad, men vart lämnar det oss konsumenter?

Jag skrev så sent som igår en nyhet om Intels nya Sandy Bridge-arkitektur där det avslöjades att vi kan vänta oss hela 19 nya modeller i början på nästa år. Alla dessa processorer kommer med en integrerad grafikdel, direkt inbakad i samma kiselkrets som CPU. Det var något flera av er reagerade över och det av en ganska bra anledning. Även om Intel tidigare gjort det klart att man kommer satsa fullt ut på att integrera en GPU i varje CPU har man nu inte längre något val. Grafikkretsen sitter hand i hand med processorkärnorna sammanflätade på transistornivå och vad det verkar kommer alla Intels nya budget- eller mellanklassprocessorer skeppas med en integrerad GPU framöver (Entusiast-familjen Sandy Bridge E kommer utan integrerad GPU).

Intel Clarkdale använde en separat kiselkrets för grafikdelen

För Intel är detta en ganska logisk utveckling, man har inga egna diskreta grafikkort och vill helt enkelt hålla konsumenter till sin egen hårdvara istället för att leta lösningar hos konkurrenterna AMD och NVIDIA. Samtidigt som det onekligen är en lösning med mer potential än grafikkretsar integrerade i våra styrkretsar.

För en vanlig svensson som använder sin dator till att surfa, bläddra bland lite familjebilder eller spela musik räcker det oftast med en enklare grafikkrets för att göra jobbet. Att då få denna grafikkrets på köpet med processorn kan ses som en ren bonus.

Tyvärr finns det även tydliga problem med att smälta samman CPU och GPU, inte minst när grafikdelen ger allt annat än imponerande prestanda. Ett tydligt exempel är Intels senaste Atom-generation. Här tog man en från början undernärd CPU, utrustade den med en grafikdel som inte ens klarar att spela upp högupplöst video, samtidigt som man ströp möjligheten att på ett effektivt sätt koppla upp processorn mot en extern och kraftfullare GPU (Läs NVIDIA Ion). Resultatet blev att konsumenter fick betala extra för en grafikkrets som behövde paras med en diskret GPU (Ion 2) eller en separat videoprocessor (Broadcom Crystal HD) för att ge en fullgod användarupplevelse.

Men problemen blir nästan än större på den stationära PC-marknaden. Även om de integrerade lösningarna på desktop-processorer är kraftfulla nog för högupplöst video finns det inget som kan ersätta ett diskret grafikkort när det kommer till spel eller mer krävande uppgifter. Återigen blir de integrerade grafikkretsarna mer ett onödigt bihang som konsumenter betalar för men som i slutändan bara tar plats och riskerar att dra onödig ström.

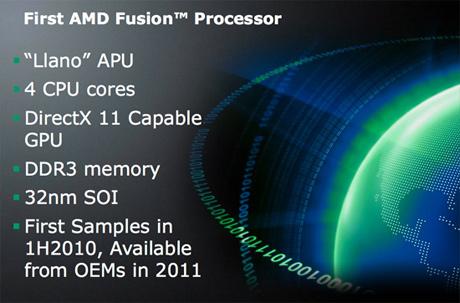

Jag har fokuserat mycket på Intel nu, men som vi alla vet kommer även AMD att satsa helhjärtat på integrerade grafikkretsar i sin Fusion-familj. AMD satsar direkt på att baka in CPU och GPU i samma kisel och grundförutsättningarna är på ytan demsamma som för Intel. Vi betalar extra för en grafikdel som riskerar att bara kommer bli ren dövikt om vi kräver mer prestanda.

Utan att ens testat eller sett några tester på AMD:s Fusion-processorer och dess integrerade GPU kan vi inte dra några större slutsatser men av vad AMD redan avslöjat ser det ut som att man förstått problematiken med att integrera grafikkretsar i alla sina processorer.

Först och främst hävdar AMD att deras integrerade GPU, som för övrigt är byggd kring samma DirectX 11 arkitektur som Radeon HD 5000-serien, kommer erbjuda prestanda långt över vad vi är vana vid från integrerade grafikkretsar.

Skulle detta stämma kan det eliminera de problem vi sett med exempelvis Intels Atom-plattform. Att processorn helt enkelt klarar av det mesta även rent grafiskt och att endast gamers kommer kräva en kraftfullare grafikkrets.

Den stationära marknaden och även kraftfullare bärbara datorer kommer fortfarande ha behov av diskreta grafikkretsar för att ge specifikt gamers den rätta upplevelsen. Men även här har AMD insinuerat att man tagit sin satsning på integrerade grafikkretsar ett steg längre, ordet man valt att trycka på är “synergy”. Rakt översatt till svenska, samverkan.

AMD relies on our ability to generate world-class discrete graphics cores and then leverages them in our APU product lines. You should also expect AMD to innovate when an AMD discrete graphics is plugged into an AMD APU, the mythical word of “synergy” will be realized. We are expecting to improve both graphics and compute performance.

När AMD talade om framtiden för diskreta grafikkretsar i sin grafikblogg var det ovan nämnda citat som etsade sig fast i min hjärna. Man avslöjar inte vad man arbetar med eller vad man planerar. Men om vi inte skenar iväg allt för långt borde det kunna betyda att man trots allt kan få användning för sin integrerade GPU, på flera olika sätt, även med ett diskret grafikkort i maskinen.

Personligen har jag några lösningar som känns både vettiga och fullständigt realtistiska;

- Deras integrerade grafikkretsar kommer automatiskt att kunna ta över vid låg belastning och sätta grafikkortet i vila för att spara ström, likt NVIDIA Optimus.

- AMD lär även aktivera någon form av Hybrid CrossFire som gör det möjligt att koppla samman grafikkretsarna för ökad prestanda.

- Förbättra stödet för flera skärmar (Eyefinity) genom att utnyttja utgångar på både moderkort och grafikkort.

Detta är tekniker som egentligen funnits på marknaden i någon form ganska länge men som i det stora hela skulle kunna rättfärdiga den breda satsningen på integrerade grafikkretsar på ett tydligare sätt. Man utökar systemets funktionalitet, förbättrar dess prestanda och optimerar strömförbrukningen.

Jag är övertygad om att vi kommer få se ännu fler lösningar än dessa när väl de integrerade processorna kommer ut på marknaden, men det ger samtidigt ett svar på frågan jag ställde mig i början.

Det är helt enkelt upp till processortillverkarna att visa varför vi borde vara positiva till att se grafikkretsar ta upp värdefull plats i våra processorer.

Mycket bra skrivet! Oavsett hur bra eller dåligt det blir, så är det en första generation av många som förmodligen kommer att förändras ganska radikalt innan den är klar. Kommer bli extremt intressant att se hur detta kommer att gå för Intel mot AMD. Och var kommer Nvidia att slänga in sina produkter i det hela?

Den som lever får se! 8)

Ja något som jag egentligen inte alls tog upp här är NVIDIAs position. Visst har man sin Optimus-teknik, men att AMD eller Intel öppnar upp för bredare “samverkan” mellan CPU och GPU ser ju inte särskilt troligt ut.

Vissa analytiker hävdar ju tom att NVIDIA nu behöver en x86-licens för att kunna konkurrera på allvar med Intel och AMD. Vilket återigen får AMDs köp av ATI att verka som ett riktigt lyft.

Det är lite som SSDs mot hårddiskar. Det behöver inte bli bättre på allt. Det räcker det blir “tillräckligt bra” för att det ska ta över.

När man får en integrerad cpu som kan spela 90% av spelen med “hyfsad” grafik (som en xbox eller ps3a) så kommer de dedikerade graffekorten gå en långsam död till mötes. Det kommer ta ett bra tag, men förr eller senare integreras “allt” i cpun pga moores lag och skalfördelar.

För egen del så ser det ljust ut, dels har jag hållt mig till AMDplattformen sen AM2 och det har ju perspektiv visat sig vara ett bra val ur mitt perspektiv och då bara med integrerad grafik. Att nu enkelt kunna uppgradera bara “cpun” och få vassare grafik på köpet istället för att byta moderkort och eventuellt minne så blir det en bra kostnadsbesparing för egen del och mina behov är inte så höga när det gäller grafisk prestanda. Mina senaste bukar har ju klarat att driva två skärmar bra och det passar mig utmärkt 😀 Enda jag spelar är… Läs hela »

[quote name=”Laglorden”]Det är lite som SSDs mot hårddiskar. Det behöver inte bli bättre på allt. Det räcker det blir “tillräckligt bra” för att det ska ta över. När man får en integrerad cpu som kan spela 90% av spelen med “hyfsad” grafik (som en xbox eller ps3a) så kommer de dedikerade graffekorten gå en långsam död till mötes. Det kommer ta ett bra tag, men förr eller senare integreras “allt” i cpun pga moores lag och skalfördelar.[/quote] Det ligger helt klart något i det du säger. Sen måste jag säga att jag faktiskt blev överraskad när jag kunde lira STALKER… Läs hela »

[quote=”Laglorden”]När man får en integrerad cpu som kan spela 90% av spelen med “hyfsad” grafik (som en xbox eller ps3a) så kommer de dedikerade graffekorten gå en långsam död till mötes. Det kommer ta ett bra tag, men förr eller senare integreras “allt” i cpun pga moores lag och skalfördelar.[/quote] En CPU som klarar 90% av spelen?Dedikerade grafikkort går en långsam död till mötes? Har svårt att tänka mig det, spelutvecklingen står ju inte stilla precis. Ex 3 skärmar blir ju allt vanligare med tiden, likaså 3D. Kolla tex vad tex HardOCP har att säga om de båda teknikerna: [url]http://www.hardocp.com/article/2009/09/28/amds_ati_eyefinity_technology_review[/url][url]http://www.hardocp.com/article/2010/06/29/nvidia_3d_vision_surround_experience/[/url]… Läs hela »

Forts… För att inte tala om HPC-marknaden, den är väl inte liten den heller? Hårdvarumässigt är det väl knappt nåt som skiljer Teslakorten från GeForce, och jag [u]gissar[/u] på att det kommer att behövas dedikerade kort i många år framöver där eftersom de flesta (alla?) vill ha så mycket prestanda de bara har råd med. Och då är det väl en smal sak att sälja endel av korten som grafikkort eller hur? En annan sak. Vad ska den integrerade GPU:n använda som minne, systemminnet är väl för långsamt för att hänga med, eller? Trekanalers DDR3 @-- 1333 har teoretiskt 32… Läs hela »

HTPC-marknaden är stor, visst, men man behöver inga monsterkort för att klara av all dagens HD-upplöst media. Det kom integrerade grafikkort som klarade av detta för flera år sedan så att köpa något att värre till en renodlad HTPC är bara idiotisk.

[quote name=”SS_The_Demon”]Citat om switching och Hybrid CrossFire. :)[/quote]Först och främst drar Cypress 27W vid idle. Även om detta också är väldigt lågt för ett så pass kraftfullt kort är det en ganska onödig förlust. I en stationär dator är det ju inte hela världen, men jag hade verkligen inte tackat nej. Sen om vi kikar på bärbara datorer är det ju extremt viktigt och där har ju AMD alla chanser att “one up” NVIDIAs Optimus-teknik. Ifall du klickar på de länkade orden i Hybrid CrossFire så ser du att jag skrivit nyhet om detta för ett par år sedan. Teknik… Läs hela »

Ja det är absolut intressant att de blir bättre, sålänge strömförbrukningen hålls låg så är det verkligen en positiv utveckling och något jag säkerligen kommer använda till bl.a HTPCn. Det jag svarade på var bara det SS_The_Demon skrev först i sista inlägget, att det skulle behövas kraftfulla kort för HTPC.

Tycker detta är intressant. Framförallt för den bärbara marknaden och alla som bygger sig en HTPC. Sen om det är så fruktansvärt nödvändigt att ha i en stationär dator vet jag inte. Kan tänka mig dessa i stationära kontorsdatorer och familjedatorer men till människor som vill spela krävande spel lär ju en diskret GPU krävas.

Öööh….jag skrev inte HTPC utan jag skrev HPC (High Performance Computing). Monsterkort behövs inte i en HTPC nej, det kan jag hålla med om. Men som sagt, HPC är en annan sak.

Ja du ser, ja det är en annan sak det.

Slöseri på cpus Watt och effekt,

Då dessa gpuer e lika bra som ett onboard som existerar idag.

Dvs alla som inte köper dessa cpuer till en htpc kommer ändå behöva köpa grafikkort.

Så hoppas de kommer finnas både och i framtiden.

[quote name=”lang”]Slöseri på cpus Watt och effekt, Då dessa gpuer e lika bra som ett onboard som existerar idag.Dvs alla som inte köper dessa cpuer till en htpc kommer ändå behöva köpa grafikkort.Så hoppas de kommer finnas både och i framtiden.[/quote]När du säger “alla” menar du de som vill spela spel. I övrigt finns det få som behöver mer grafisk kraft, visst professionella användare osv. Men det är relativt små målgrupper som ofta inte köper dessa mellanklass processorer i vilket fall.En integrerad GPU är inte alltid den bästa lösningen på något sätt, men gör man en bra implementering är jag… Läs hela »