Kända överklockaren Tobias “Rauf” Bergström tar ton och menar att hårdvarutillverkare pressar sina komponenter så långt att bristningsgränsen är nära och överklockning i princip blivit överflödigt.

Detta är en krönika av Tobias “Rauf” Bergström. Här presenterar han sin personliga åsikt.

Överklockning, alltså att trimma en datorkomponent till bättre prestanda än i originalutförande, har funnits i princip så länge datorer har funnits. Någon stans runt millennieskiftet började dock storhetstiden då var och varannan person med minsta lilla datorintresse överklockade sina komponenter.

Tjusningen låg i att få gratis prestanda och faktiskt kunna spela spel som annars inte hade gått att köra på sitt system. På den tiden fanns inte mycket grafikinställningar och 30 fps ansågs vara bra flyt. Marginalerna för överklockning var också större. Det var inte omöjligt att kunna köpa ett grafikkort för 2000 kr och få det att prestera lika bra eller bättre än värstingmodellen på marknaden, som vid tillfället kostade runt 4000 kr.

På senare år har dock intresset och nyttan med överklockning minskat markant. Det finns fortfarande en hel del som uppskattar att testa gränser, pressa sitt system och se vad det kan gå för. Men den vardagliga överklockningen har i mångt och mycket upphört. Eller har den verkligen det?

Överklockningen utvecklade branschen

Tittar vi tillbaka i tiden till glansdagarna runt millennieskiftet är det mycket tydligt hur stor inverkan överklockningen haft på komponentbranschen. Titta på kylarstorleken och effektutvecklingen på ett grafikkort från början av 2000-talet.

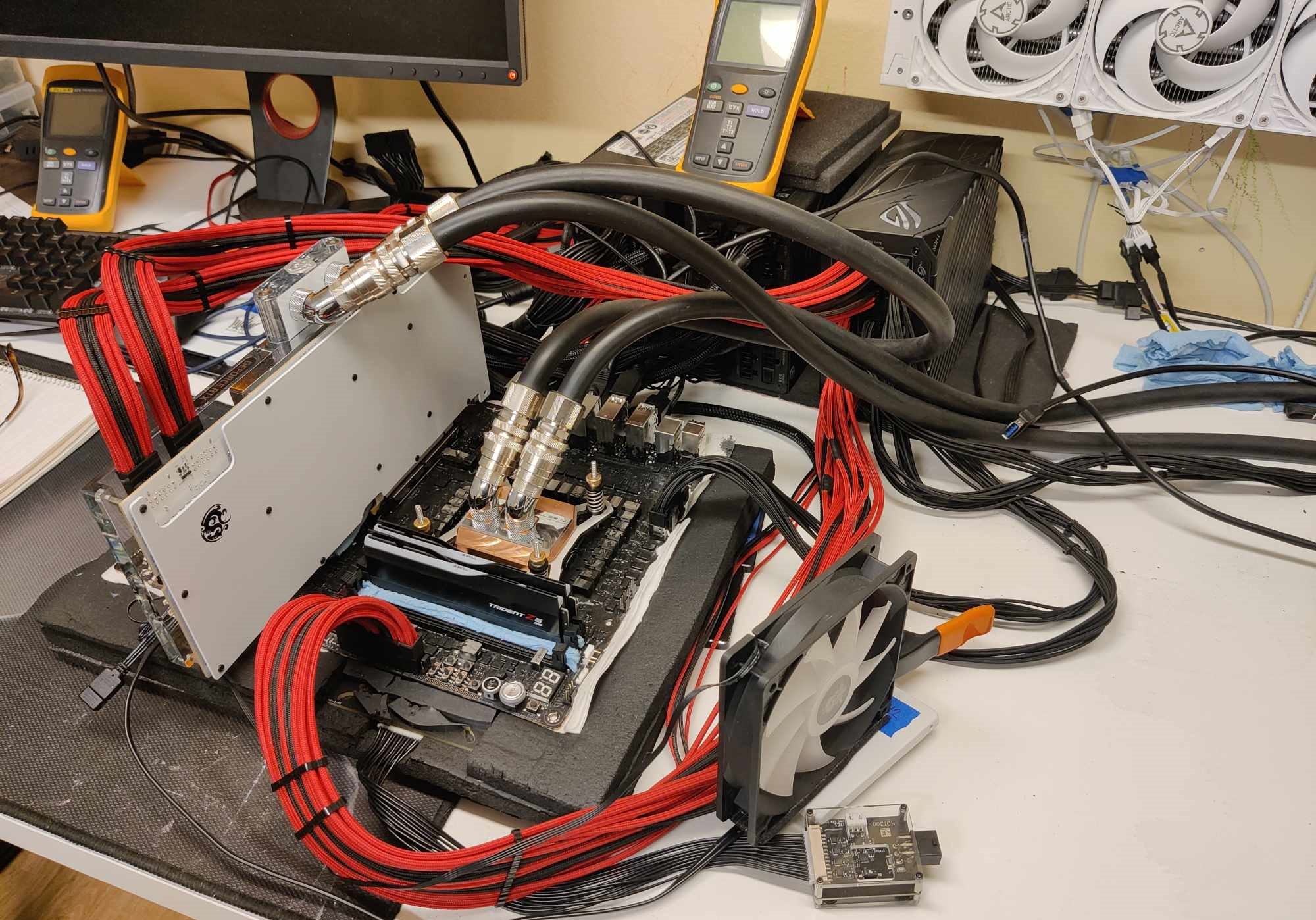

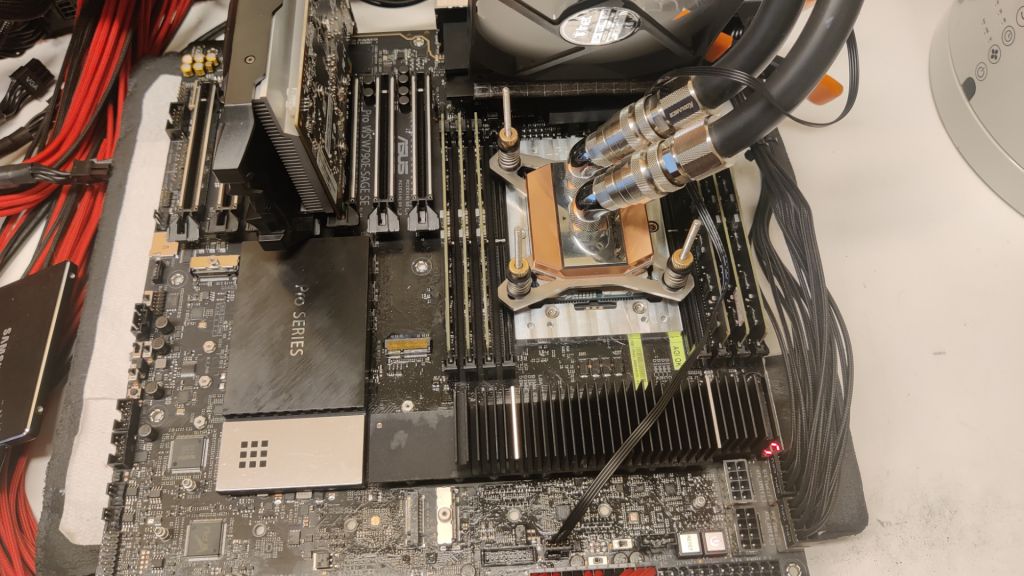

Vad gjorde överklockarna? Jo, vi monterade en CPU-kylare på grafikkortet, med mycket större kylkapacitet. Därefter kunde vi trimma spänning och prestanda till helt andra nivåer. Och det utan att kortet behövde låta som en jetmotor. Tillverkarna följde snart efter och större och kraftfullare kylare blev standard, som därmed öppnade upp för mer effekt och kraftfullare hårdvara.

Det finns gott om andra exempel där överklockningen visat vägen framåt för branschen. Vattenkylning, överklockade ramminnen ledde till XMP och EXPO-profiler, bättre strömreglering, fler strömkontakter med mera. Framför allt så är det dock två saker som verkligen har satt spår: att bättre utnyttja klockfrekvenser samt effektutvecklingen. Det var inte så väldigt länge sedan en processor höll samma frekvens oavsett om den belastade en kärna eller alla kärnor, vilket såklart lämnade en hel del outnyttjad kapacitet. Sedan uppfanns boost-funktionerna, som numera är standard hos alla de tre stora, Intel, Nvidia och AMD.

Boostfunktionerna blev den nya överklockningen

Boost-funktionerna är i praktiken inget annat än en automatisk överklockningsfunktion som kickar in när temperatur, belastning och effekt tillåter det. Boost-funktionerna har sedan utvecklats och blivit mer än och förfinade och pressar numera komponenterna så pass nära sin maximala kapacitet att det inte längre finns särskilt stora marginaler för manuell överklockning.

I grunden är det bara bra. Tillverkarna har hittat sätt att bättre utnyttja hårdvaran utan att hela tiden ligga med stora säkerhetsmarginaler mot vad den egentligen klarar av. Problem har dock uppstått i form av att utvecklingen av tillverkningstekniker har stannat av, Moore’s law kan inte anses gälla längre. Det har fått tillverkarna att behöva ta till nya knep för att kunna ta fram nya, snabbare produkter. När tillverkningstekniken sviker tar tillverkarna till det enda de kan: effekt!

Tillverkarna har drivit ”överklockningen” för långt

På senare tid har tillverkarna pressat sina produkter genom att konstant öka effektutvecklingen på ett sätt som inte längre kan anses sund. För de som mig som sysslar med lite mer extrem överklockning är vi såklart inte främmande för att driva upp effekten. Men det gäller under korta stunder och då för att pressa komponenterna och jaga rekord.

Att köra komponenterna med väldigt hög effekt kontinuerligt är faktiskt inte vettigt. Även om kylningen klarar av det så drar det mycket ström och ger mycket spillvärme. Det resulterar inte sällan heller i relativt högljudda fläktar som ska transportera bort värmen. Barnens rum känns lite smått tropiska när jag går in i rummet efter att de spelat ett tag och då har de ändå inte värstingkomponenter.

Att grafikkort idag kan dra upp till 600W och processorer över 300W är faktiskt i mina ögon inte rimligt. Framför allt är det de där sista få procenten prestanda som pressas ur till en väldigt stor effektökning som är så konstigt att tillverkarna envisas med. Är det verkligen värt 40% högre effekt för 5-10% högre prestanda, som det kan handla om för till exempel RTX 4090.

Undervoltning har tagit över överklockningen

Ett tydligt exempel på att tillverkarna faktiskt har gått för långt i sitt pressande av produkterna är att entusiaster inte längre överklockar. Inte bara för att marginalerna inte längre finns, utan för att de faktiskt föredrar lite sämre presterande produkter.

Målet är såklart inte att produkterna ska prestera sämre, men det blir ofta en bieffekt. Målet är att hitta inställningar som till exempel ger bäst energieffektivitet. genom att sänka spänningen, powerlimit eller frekvens. Genom att testa runt bland dessa inställningar går det att få avsevärt lägre energiförbrukning och svalare och tystare komponenter utan att prestandan blir mer än marginellt påverkad.

Det kanske är så att pendeln har slagit över lite väl långt, och det är dags för tillverkarna att ta ett steg tillbaka och ge oss lite mer välbalanserade produkter. NVIDIAs 5000-serie lär inte vara långt borta, framtiden får utvisa om de tagit till sig av 4090-kortens många brister. Eller om det blir ännu en generation pressad till sina gränser så hårt att till och med strömkontakterna smälter.