Nvidia Pascal GP104: Höga klockfrekvenser och GDDR5X

Man skulle kunna tro att Nvidia siktade mot stjärnorna med de nya klockfrekvenserna för GP104. Maxwellkretsen GM2014 i GTX 980 fick nöja sig med klockfrekvensen 1 126 megahertz och minnesfrekvensen på 7 000 megahertz effektivt men för Pascal väljer Nvidia att skruva på reglagen ordentligt.

Nvidias nya Geforce Pascal-serie

Geforce Pascal mot sina föregångare från Maxwell| GeForce GTX 1080 | GeForce GTX 1070 | GeForce GTX 980 | GeForce GTX 970 | GeForce GTX 980 Ti | Tesla P100 | |

|---|---|---|---|---|---|---|

| Arkitketur | Pascal | Pascal | Maxwell | Maxwell | Maxwell | Pascal |

| GPU | GP104 | GP104 | GM204 | GM204 | GM200 | GP100 |

| Teknik | 16nm Finfet | 16nm Finfet | 28nm | 28nm | 28nm | 16nm Finfet |

| Kretsyta | 314 mm2 | ~300 mm2 ? | 398mm2 | 398mm2 | 601mm2 | ~610mm2 |

| Transistorer | 7,2 Miljarder | 7,2 Miljarder | 5.2 Miljarder | 5.2 Miljarder | 8 Miljarder | 15,3 Miljarder |

| Cuda-kärnor | 2 560 st | 1 920 st | 2 048 st | 1 664 st | 2 816 st | 3 840 st |

| Basfrekvens | 1 607 MHz | 1 506 MHz | 1 128 MHz | 1 050 MHz | 1 002 MHz | 1 328 MHz |

| Boostfrekvens | 1 733 MHz | 1 683 MHz | 1 217 MHz | 1 178 MHz | 1 076 MHz | 1 480 MHz |

| Beräkningskraft | Upp till 8,9 TFLOPS | 6,75 TFLOPS | 4,61 TFLOPS | 3,9 TFLOPS | 5,63 TFLOPS | 21 TFLOPS |

| Minne | 8 GB GDDR5X | 8 GB GDDR5 | 4 GB GDDR5 | 4 GB GDDR5 | 6 GB GDDR5 | 16/32 GB HBM2 |

| Minnesfrekvens | 10 000 MHz | 8 000 MHz | 7 012 MHz | 7 012 MHz | 7 012 MHz | 1 400 MHz |

| Minnesbuss | 256-bit | 256-bit | 256-bit | 256-bit | 384-bit | 4096-bit |

| Minnesbandbredd | 320 GB/s | 256 GB/s | 224 GB/s | 224 GB/s | 336 GB/s | 720 GB/s |

| TDP | 180W | 150W | 165W | 145W | 250W | 300W |

| Strömkontakt | 8-pin | 8-pin | 6 pin + 6-pin | 6 pin + 6 pin | 6 pin + 8 pin | Oklart |

| Anslutningar | 3x DP, 1x HDMI 2.0,1x DVI | 3x DP, 1x HDMI 2.0,1x DVI | 3x DP, 1x HDMI 2.0,1x DVI | 3x DP, 1x HDMI 2.0,1x DVI | 3x DP, 1x HDMI 2.0,1x DVI | Oklart |

| Lanseringsdatum | maj-16 | jun-16 | sep-14 | sep-14 | maj-15 | Q4 2016? |

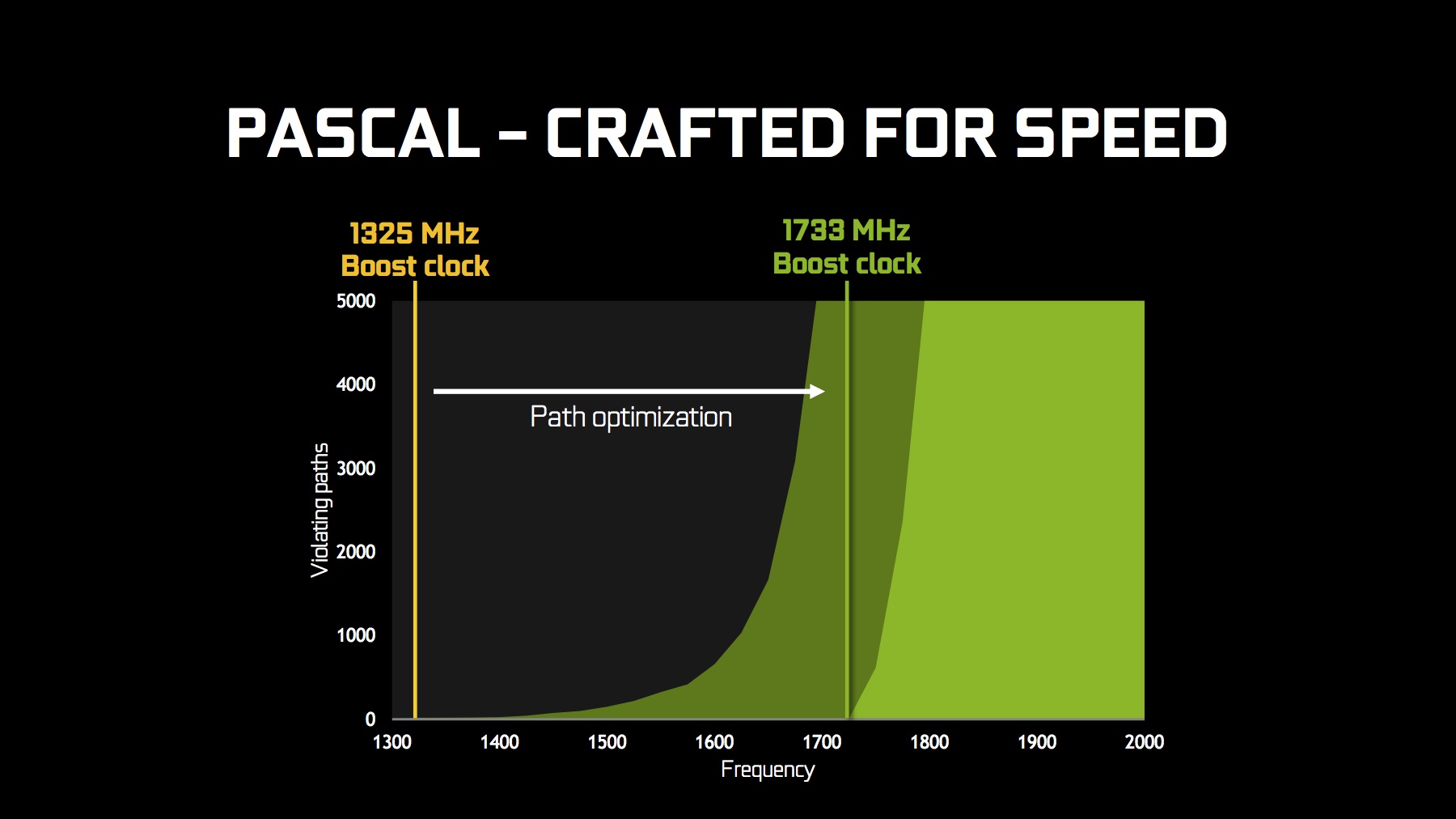

Pascalkretsen GP104 i GTX 1080 har en klockfrekvens på 1 607 megahertz och en Boostfrekvens på 1 733 megahertz, vilket inte alls är dåligt för att vara ett referenskort. Minnesfrekvensen med de nya GDDR5X-minnena från Micron går upp till hela 10 000 megahertz effektivt.

De höga klockfrekvenserna kan tolkas som att Nvidia drar in på överklockningsmarginalen för de nya Pascalkorten, men så verkar inte fallet vara, andra recensenter har lyckats överklocka GTX 1080 till strax över 2 000 megahertz med referenskylaren, och vi räknar med att tredjepartstillverkarna släpper ordentligt överklockade GTX 1080 inom en snar framtid.

GDDR5X – högre bandbredd med samma minnesbuss

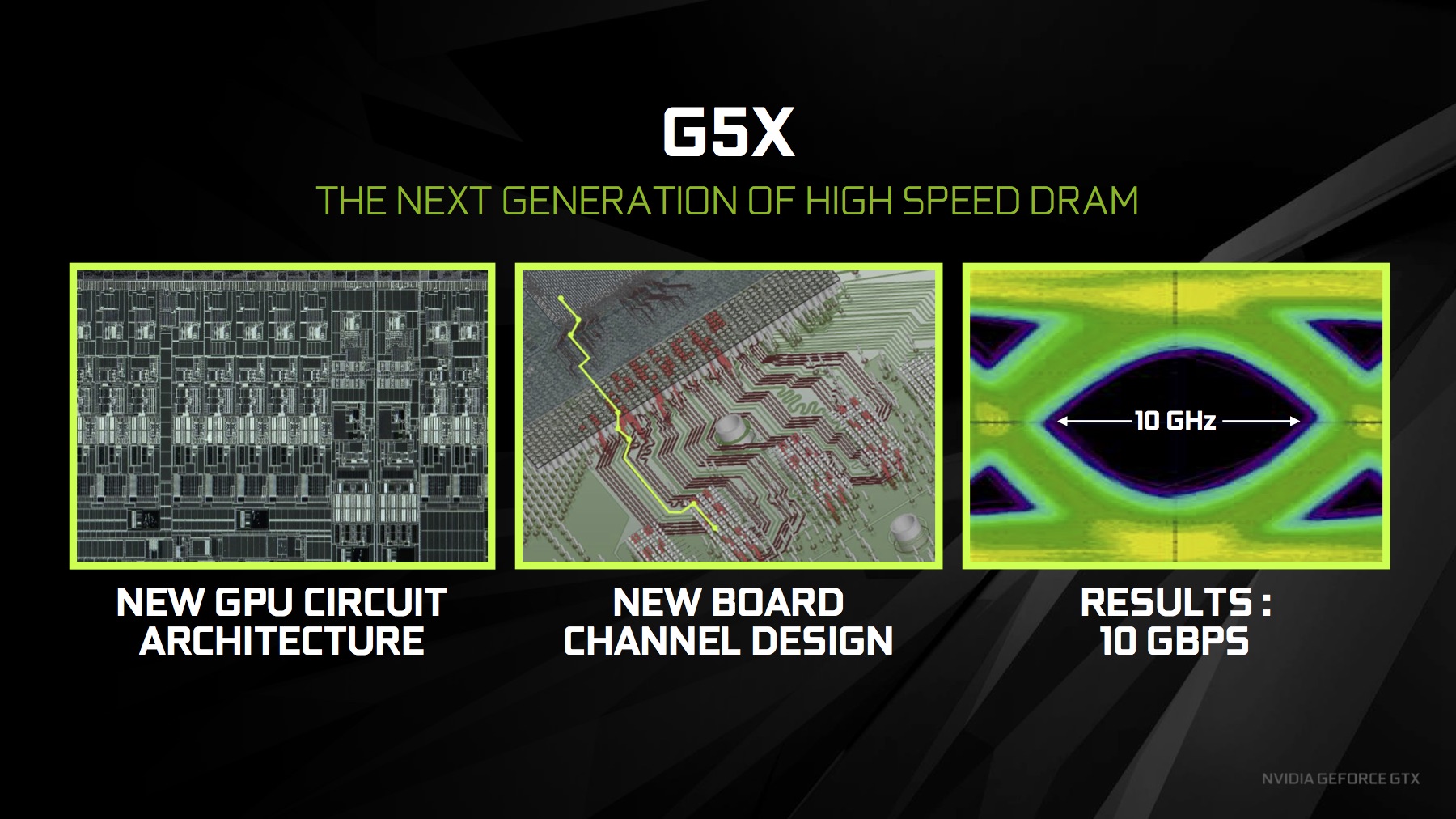

Som allt annat med ett ”X” i namnet så är GDDR5X väldigt, väldigt likt GDDR5 standarden minnesmoduler, som fortfarande används, och kommer att användas för Pascalbaserade grafikkort.

Information om GDDR5X standarden är knapphändig men av det som finns att tillgå så handlar det om dubblering av minnesgränssnittet ”prefetch” från 8n till 16n. Detta ger upphov till dubblerad bandbredd mellan 10 och 14 gigabyte per sekund.

Energieffektiviteten sägs även det ha förbättrats jämfört med GDDR5, VDD, VDDQ (spänningen) har fått en sänkning från 1,5 volt till 1,35 volt i GDDR5X. GDDR5X standarden kommer med tre huvudegenskaper: dubblerad dataöverföringshastigheter, förbättrad energieffektivitet av ”high-end” minnesmoduler, och det definierar möjligheten att skapa tätare minneskonfigurationer.

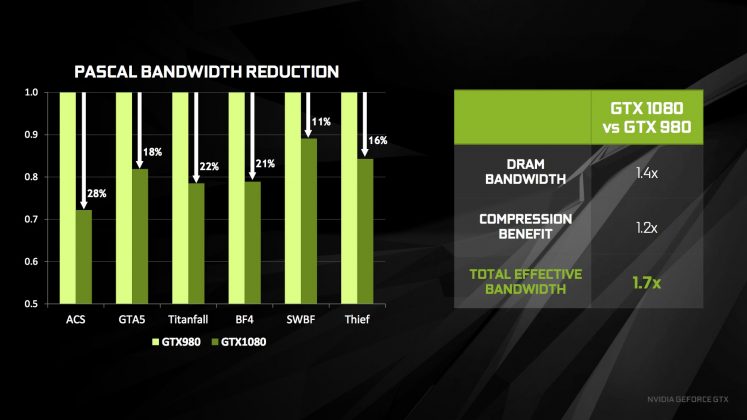

För Pascalkretsen GP104, med åtta stycken 32-bit minneskontroller, och en total minnesbuss på 256 bit, innebär det en minnesbandbredd på 320 gigabyte per sekund. Det är svårt att mäta minnesbandbredd för ett grafikkort på ett statistiskt säkert sätt men vi kan konstatera att minnesbandbredden för GP104 inte bör vara en flaskhals.

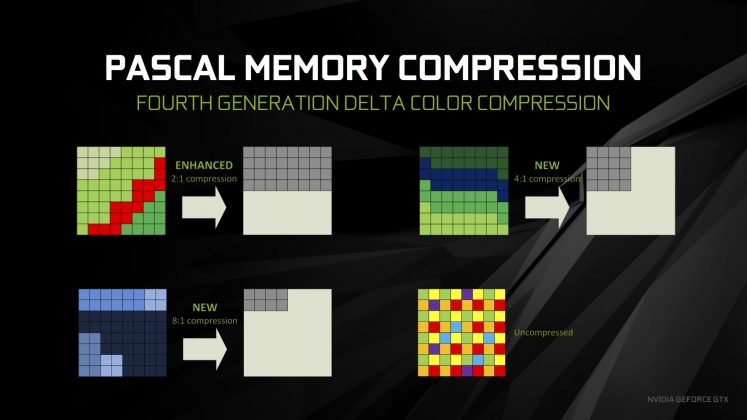

Med Pascal finslipar Nvidia på komprimeringstekniken för minne. Fjärde generations “delta color”-komprimering i Pascal förbättrar bandbreddens effektivitet med upp till 20 procentenheter.

I väntan på HBM2

AMD hade redan förra året klurat ut att 8 gigabyte minnesmängd var ett rimligt nästa steg (High Bandwidth Memory, HBM, begränsades dock till 4 gigabyte i Fury-serien) när man släppte entusiastgrafikkort med 8 gigabyte minnesmängd. Nvidia vill inte stå ensam i kylan när det enda andra företaget gör något nytt så självklart bygger även det gröna laget ut minnesmängden i sitt flaggskepp. För GTX 1080 trycker man in 8 gigabyte minne på en 256 bit minnesbuss och hoppas att minneskomprimeringen och det lite snabbare GDDR5X minnet sköter resten. Nästa generations minnesteknik, HBM2, är fortfarande för mycket av en bristvara för att hitta in i kort i ens den här prisklassen.

Förhoppningsvis försöker man inte spara in på kostnaderna för minnet, igen, likt GTX 970 där man segmenterade grafikminnet i två delar (3,5 gigabyte och 0,5 gigabyte) för syskonet GTX 1070, The North Remembers. Nvidia korrigerade snabbt, efter några månader, specifikationerna för GTX 970 där det visade sig att man hade gett ”fel” information om grafikkretsen.

GTX 970 hade fler SM enheter inaktiverade och en av fyra minneskontroller-partitioner var avstängd, eller fungera delvis, antalet renderingsenheter var 56 och inte 64 och mängden L2 Cache var 1,75 megabyte. Det större segmentet av grafikminne hade en bandbredd på 192 gigabyte per sekund medan den mindre sektionen bara hade en bandbredd på 28 gigabyte per sekund. Prestandatappet var några procentenheter men de falska specifikationerna lämnade många konsumenter med en dålig smak i munnen.

Fra nederst på side 2:

”Räknar vi antalet transistorer per kvadratmillimeter för GM204 får vi 13,1 miljoner transistorer per kvadratmillimeter, samma siffra för GP104 är 22,9 miljarder transistorer.”

Fra 13,1 million til 22,9 milliard transistorer/mm2 altså. Ganske høye tall, spesielt siden hele kretsen er på 314mm2 og har 7,2 milliard transistorer totalt. 🙂

Nu har jag inte tittat så noga men det jag har sått hittills så ser det ut som om alla vräkt på med full kantutgämning på alla tester, även 4K trots att det är helt onödigt. Förstår inte varför det ska hålla på med det då man ändå inte vill använda det och 4K testerna blir totalt poänglösa.

Enig. Min personlige mening er at AA og diverse andre ”optimaliserings” algoritmer har ingen nytteverdi på oppløsninger fra full hd og oppover. Det er vel utelukkende på grunn av den ekstra belastningen at det blir brukt i tester? En del av standard oppsettene i spill endrer vel også disse tingene. Må alltid velge custom oppsett og fikle litt med div innstillinger før jeg blir fornøyd, har aldri forstått hvordan de vurderer hvilke innstillinger som skal være i de standard oppsettene.

Men saken är den att när man ska testa ett grafikkort så är det inte extra belastning som testaren bör vara ute efter utan faktiska användbara exempel.