Testsystem och metod

| Testsystem | |

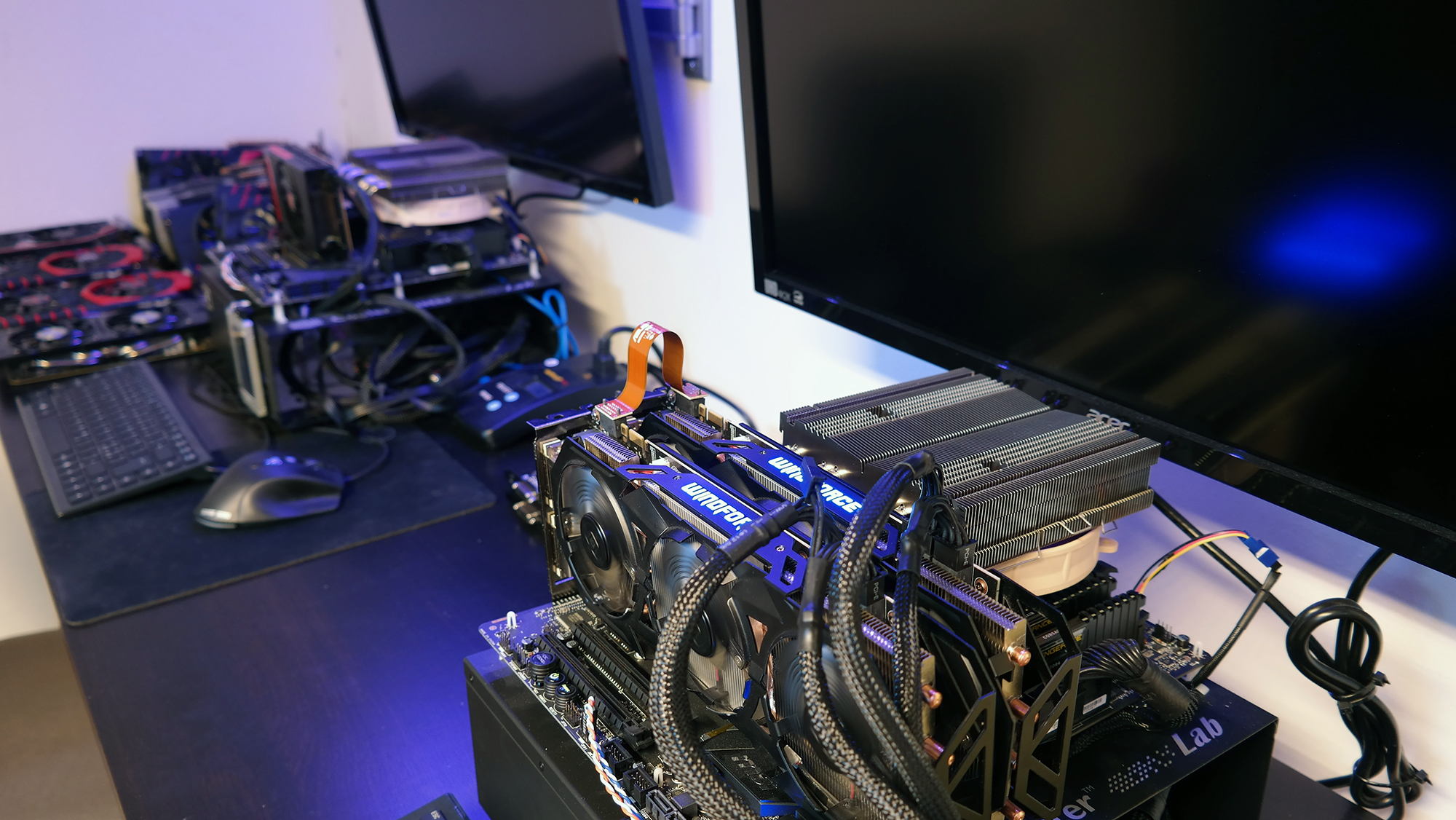

| Processor | Intel Core i7-5960X Alla kärnor låsta till 3,5 GHz |

| Moderkort | MSI X99 SLI Plus UEFI version 1.8 |

| Minne | 4 x 4 GB Corsair Vengeance LPX (CMK16GX4M4A2400C14) 2400 MHz CL14, 1,2 V |

| Grafikkort | AMD Radeon Fury X AMD Radeon R9 290 (Rekommenderat av Massive) AMD Radeon HD 6850 Nvidia Geforce GTX 980 Ti |

| Drivrutiner | AMD Radeon Software Crimson Edition 15.12 (Windows 10 64-bit)

Nvidia GeForce Game Ready Driver 361.43 (Windows 10 64-bit) |

| Lagring | Crucial M550 512GB |

| Nätaggregat | Corsair HX1000i |

| Kylare | Noctua NH-C14 |

| Skärm | Acer XB280HK 3 840 x 2 160 |

| Chassi | Cooler Master Lab |

| Operativsystem | Windows 10 64-bit |

För våra grafiktester använder vi två identiska testsystem baserade på Intels Haswell-E-plattform. Hjärtat i systemen är flaggskeppsprocessorn Intel Core i7-5960X med totalt åtta kärnor och 16 trådar, som vi har låst så att samtliga kärnor ständigt körs i boostfrekvensen 3,5 gigahertz. Processorn kompletteras med en DDR4-minnesmodul per kanal, för totalt 16 gigabyte som körs i 2 400 megahertz och timinginställningarna 14-16-16-31. Med våra nya testsystem tar vi även steget över till Windows 10 för att vara garderade inför ett antal års kommande speltester.

Två standardupplösningar

Vi använder oss av Ultra HD-skärmar från Acer med en maximal upplösning på 3 840 x 2 160 pixel och en uppdateringsfrekvens på 60 hertz. Det låter oss köra den vanligaste standardupplösningen idag samt 4K:

- 3 840 x 2 160 (Ultra HD)

- 1 920 x 1 080 (Full HD)

Ashes of the Singularity

Testerna för Ashes of the Singularity är utförda i DirectX 11 och DirectX 12, med fokus på det senare, med betaversionen av spelet. Vi testar tre kort från AMD och tre kort från Nvidia, i två upplösningar, och även med två olika multi-GPU-konfigurationer: med Radeon R9 Fury X som primärkort tillsammans med Geforce GTX 980 Ti, samt GTX 980 Ti som primärkort tillsammans med R9 Fury X. Det finns många grafikinställningar för Ashes of the Singularity men vi testar spelet på standardinställningen “Extreme”. Vsync är avstängd för att bilder per sekund inte ska vara låst till ett bestämt värde.

Varför har ni inte med Radeon 390 / 390X när ni har med typ alla större nVidia kort GTX970 /980 / 980 Ti i tested.

DX12 visar ju verkligen värdet på 390/390X och detta missar ni ju helt att kommunicera eller gjordes detta med mening för att framställa nVidia som ett prisvärt alternativ över Radeon.

När man tittar på era tabeller ser det ut som om man måste köpa det dyraste Radeon Fury X av Radeon familjen och har man inte råd med detta ska man hålla sig till nVidia.

+1

Är det inte mer intressant vad mellanklasskorten klarar med ett extra kort? Det är väl större chans att någon skulle stoppa i ett kort till när man inte har spelbara frekvenser en att någon som det redan flyter för skulle göra det?

Ytterligare en kombination som hade varit intressant eftersom det nog är mer vanligt:

Att kombinera ett diskret grafikkort med processorns inbyggda GPU.

Men processorn i testlabbet Intel Core i7-5960X kanske inte har inbyggd grafik?

[quote name=”Robertxxx”]Varför har ni inte med Radeon 390 / 390X när ni har med typ alla större nVidia kort GTX970 /980 / 980 Ti i tested.

DX12 visar ju verkligen värdet på 390/390X och detta missar ni ju helt att kommunicera eller gjordes detta med mening för att framställa nVidia som ett prisvärt alternativ över Radeon.

När man tittar på era tabeller ser det ut som om man måste köpa det dyraste Radeon Fury X av Radeon familjen och har man inte råd med detta ska man hålla sig till nVidia.[/quote]

Inte första gång det känns som NH favoriserar Nvidia

Om ni nu känner oklarheter med testmetodiken, kan ni inte fråga skribenten i fråga än att bara hävda en massa. Där finns säkerligen en grundläggande tanke med metodiken, eller begränsningar som gjorde valen av grafikkort. nILGot och Flyfisherman tycker jag har intressanta tankar kring testmetodiken. [quote name=”tony f”][quote name=”Robertxxx”]Varför har ni inte med Radeon 390 / 390X när ni har med typ alla större nVidia kort GTX970 /980 / 980 Ti i tested. DX12 visar ju verkligen värdet på 390/390X och detta missar ni ju helt att kommunicera eller gjordes detta med mening för att framställa nVidia som ett prisvärt… Läs hela »

Det verkar som Nvidia inte har aktiverat async shading i sina drivrutiner ännu. AnandTech [url]http://www.anandtech.com/show/10067/ashes-of-the-singularity-revisited-beta/7[/url][quote]Going hand-in-hand with DX12, RTG’s cards are the only products to consistently benefit from Ashes’ improved asynchronous shading implementation. Whereas our NVIDIA cards see a very slight regression ([b]with NVIDIA telling us that async shading is not currently enabled in their drivers[/b]), the Radeons improve in performance, especially the top-tier Fury X. This by itself isn’t wholly surprising given some of our theories about Fury X’s strengths and weaknesses, but for Ashes of the Singularity performance it further compounds on the other DX12 performance gains for… Läs hela »

[quote name=”Robertxxx”]Varför har ni inte med Radeon 390 / 390X när ni har med typ alla större nVidia kort GTX970 /980 / 980 Ti i tested. DX12 visar ju verkligen värdet på 390/390X och detta missar ni ju helt att kommunicera eller gjordes detta med mening för att framställa nVidia som ett prisvärt alternativ över Radeon. När man tittar på era tabeller ser det ut som om man måste köpa det dyraste Radeon Fury X av Radeon familjen och har man inte råd med detta ska man hålla sig till nVidia.[/quote] En anledning kanske är att de inte hade tillgång… Läs hela »

[quote name=”Robertxxx”]Varför har ni inte med Radeon 390 / 390X när ni har med typ alla större nVidia kort GTX970 /980 / 980 Ti i tested. DX12 visar ju verkligen värdet på 390/390X och detta missar ni ju helt att kommunicera eller gjordes detta med mening för att framställa nVidia som ett prisvärt alternativ över Radeon. När man tittar på era tabeller ser det ut som om man måste köpa det dyraste Radeon Fury X av Radeon familjen och har man inte råd med detta ska man hålla sig till nVidia.[/quote] De korten togs inte med av två anledningar: begränsad… Läs hela »

[quote name=”Carl Holmberg”][quote name=”Robertxxx”]Varför har ni inte med Radeon 390 / 390X när ni har med typ alla större nVidia kort GTX970 /980 / 980 Ti i tested. DX12 visar ju verkligen värdet på 390/390X och detta missar ni ju helt att kommunicera eller gjordes detta med mening för att framställa nVidia som ett prisvärt alternativ över Radeon. När man tittar på era tabeller ser det ut som om man måste köpa det dyraste Radeon Fury X av Radeon familjen och har man inte råd med detta ska man hålla sig till nVidia.[/quote] De korten togs inte med av två… Läs hela »

Är med på era argument. Men att detta inte är någon köpguide ursäktar inte ett onyanserat urval av testkort. Som nämnts tidigare så ser det vid första anblicken ut som att AMDs top of the line-enhet är enda kortet som duger från röda lägret.

Men lär man sig av sina misstag så är ingen skada skedd.

Såååå where can I get the beta??