TEST GeForce GTX 580 är nu här och även om vi de senaste veckorna fullkomligt badat i rykten och informationsläckor är kortet fortfarande något av en överraskning, något som visat sig vara en del av NVIDIA:s storslagna plan. Tanken med GeForce GTX 580 är att göra bot för alla misstag man gjorde med sina först Fermi-produkter, vilket är en gedigen lista.

Med facit i hand har inte ens NVIDIA några problem att erkänna sina synder och även om detta inte gör något ogjort visar det i alla fall att man till viss del lyssnar på sina kunder och även vi i media som gett tillverkaren ganska hård kritik i vissa avseenden.

Något NVIDIA verkligen inte ville upprepa med sin lansering av GeForce GTX 580 var just själva lanseringen och tiden innan densamma. Fermi-arkitekturen blev något av ett spöke för tillverkaren, som drogs med flertalet förseningar och som när det väl lanserades gjorde det med flera jobbiga barnsjukdomar.

GeForce GTX 480 hade den otacksamma uppgiften att försöka vinna tillbaka förtroendet hos konsumenter som väntat på NVIDIA:s nya arkitektur i närmast ett år. Med GeForce GTX 580 ville NVIDIA undvika denna situationen till alla medel och istället ge konsumenterna något oväntat, helt enkelt en positiv överraskning.

Detta är den största anledningen till att NVIDIA:s nya flaggskepp närmast kommit från ingenstans och grafikkortstillverkaren har faktiskt gått så långt att man mörkat kortets specifikationer för större delar av den samlade teknikpressen, vilket betyder att dessa första rader skrivs mindre än ett dygn innan själva lanseringen av kortet sker.

Medan vi själva sitter sömnlösa och gnisslar tänder är det däremot positiva nyheter för alla konsumenter. NVIDIA hävdar bestämt att lanseringen av GeForce GTX 580 är en fullfjädrad sådan, kort ska finnas tillgängliga och det direkt från lanseringsdagen.

Men vad är det då NVIDIA lyckats åstadkomma på de sju månader som gått sedan man lanserade föregångaren GeForce GTX 480? Det hela började med en lista över tre av kortets största brister, ljudnivån, effektiviteten och prestandan. Vi har redan konstaterat att NVIDIA med bravur klarat av lanseringsproblematiken vi tidigare diskuterade, men nu ska vi gräva lite djupare och se hur man försökt lösa de övriga problemen.

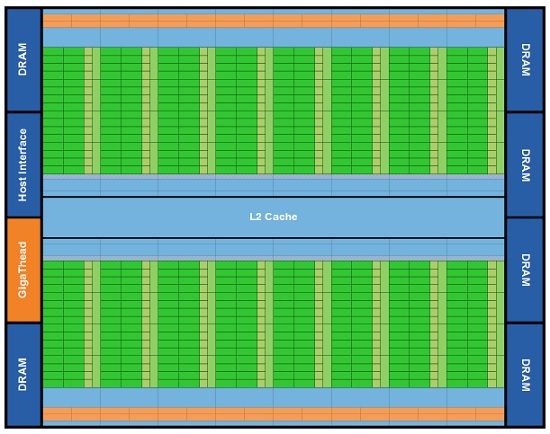

Hjärtat i GeForce GTX 580 heter GF110 och är NVIDIA:s femte Fermi-GPU att nå marknaden. Det är också den första som ger konsumenter chansen att dra full nytta av den kraftfulla grafikkortsarkitektur som Fermi faktiskt är. När GeForce GTX 480 lanserades i slutet av mars 2010 hette grafikkretsen GF100 och trots att det var toppmodellen i Fermi-programmet hade NVIDIA stängt av viss funktionalitet. Närmare bestämt en av kortets 16 SM-enheter och dess tillhörande beräkningsenheter.

Detta var nödlösningen personifierad och kom av det faktum att NVIDIA i hopp om att tillverka marknadens kraftfullaste grafikkort råkat skapa ett strömslukande svart hål. GF100 var på tok för hungrigt och varmt för att klara av 512 CUDA-kärnor – som arkitekturen utvecklats för att nyttja – så NVIDIA:s lösning blev alltså att stänga av ett beräkningskluster och begränsa kretsen till 480 CUDA-kärnor. Trots detta fick man samtidigt skruva ner sina planerade klockfrekvensmål något för att göra kretsen och GeForce GTX 480 redo för konsumentmarknaden.

Trots dessa åtgärder är NVIDIA GeForce GTX 480 det varmaste och mest strömslukande kortet vi stött på under våra 10 år här på NordicHardware. Visst, kortet var det snabbaste på marknaden med en ensam GPU, men priset för denna prestanda var högt – och då pratar vi inte bara om riktpriset på 5 000 kronor inklusive moms.

GF110 släpper på bromsklossarna

NVIDIA höll masken ganska väl under omständigheterna men var samtidigt smärtsamt medvetna om att en liknande fadäs med nästa lansering inte skulle tolereras av varken kunder eller partners. På drygt 7 månader har NVIDIA pulat och filat på sin Fermi-arkitektur och resultatet har vi här idag framför oss, GF110 med sina fulla 16 SM-enheter och 512 CUDA-kärnor.

GF110 drar nytta av Fermi-arkitekturens alla 16 SM-enheter (De gröna vertikala modulerna)

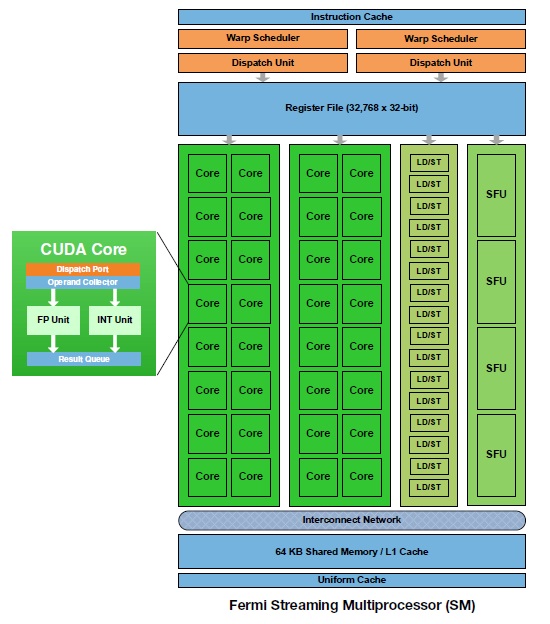

Varje Streaming Multiprocessor innehåller förutom 32 stycken CUDA-kärnor även fyra texturenheter och en PolyMorph-enhet – som sköter NVIDIA:s tessellationberäkningar.

NVIDIA:s SM-enheter förblir intakta

Även om NVIDIA menar att GF110 använder sig av samma grundarkitektur som GF100 har det hänt en hel del när vi kikar ner på transistornivå. NVIDIA hävdade bestämt att man inte plockat bort någon del av Fermi-arkitekturens funktionalitet och alltså ska även GF110 HPC (High Performance Computing) delen finnas kvar, i motsats till tidigare rykten.

Något har dock hänt, NVIDIA vill inte avslöja exakt hur många transistorer som hittas i sina grafikkretsar. Men GF110 ska krympt med runt 200 miljoner för att landa på närmare exakt 3 miljarder transistorer och detta tar oss vidare till nästa del i kapitlet GTX 580. NVIDIA har nämligen inte bara bantat sin nya grafikkrets, men har även trimmat det som finns kvar på detaljnivå.

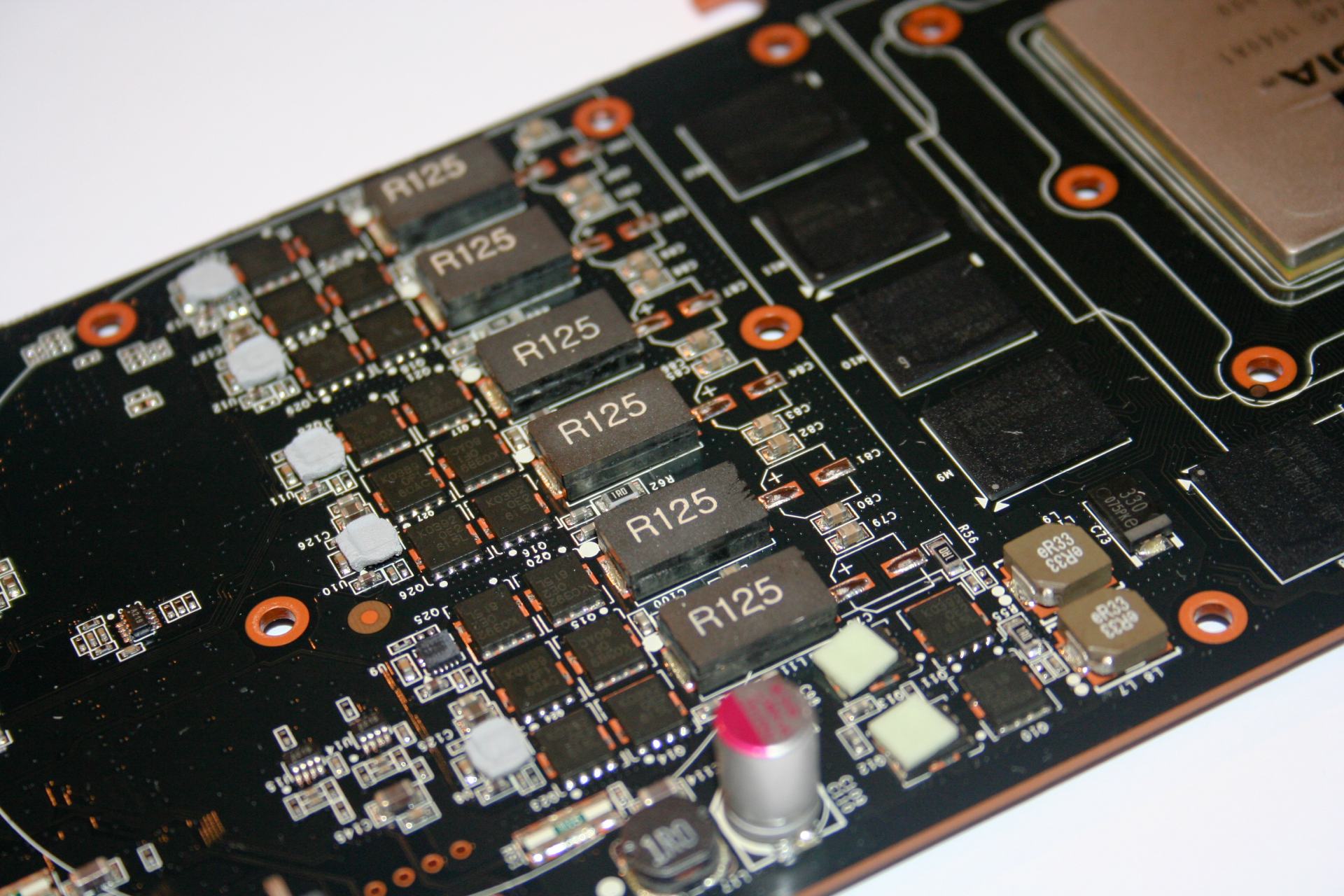

Även om NVIDIA tvingat GF110 genom en bantningskur är grafikkretsen en gigant med 3 miljarder transistorer som alla arbetar för att hålla dataflödet på maximal nivå. NVIDIA gick därmed ett steg längre och även om man var uppbunden mot sin befintliga arkitektur satte man sig ner och gick igenom grafikkretsens alla byggstenar och de transistorer som användes för olika delar av kretsen.

Denna analys avslöjade att man på flera punkter kunde ändra sina prioriteringar och NVIDIA började att byta ut sina transistorer. De delar av kärnan som inte är fullt så prestandapåverkande fick nya strömsnålare transistorer, medan de delar av kärnan som tar hand om beräkningarna fick så kallade högläckage-transistorer med bättre prestanda. NVIDIA vill inte säga hur många transistorer man bytt ut, men hävdar att det är en stor procent av kärnan som setts över.

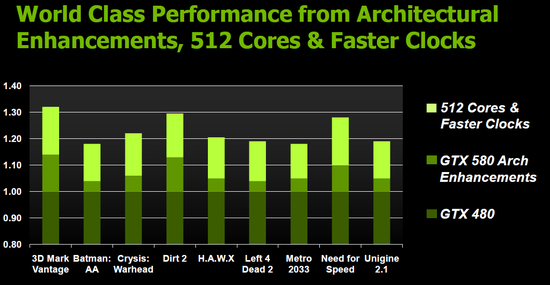

Slutresultatet enligt NVIDIA själva ska vara att man lyckats låsa upp 32 extra CUDA-kärnor, spetsa klockfrekvenserna och ändå landa på en lägre strömförbrukning än i dagens GeForce GTX 480-kort. Vilket vi kan se på två sätt, en imponerande bedrift. Eller vad vi väntade oss av Fermi redan för 7 månader sedan.

NVIDIA sätter koppel på sitt nya monster

Även om GF110 är smalare och effektivare än sin föregångare går det inte komma undan att vi här har en gigantisk krets med en idag förhållandevis föråldrad tillverkningsteknik. Pressar man kretsens alla transistorer till max så kommer grafikkretsen att sluka enorma mängder ström, om än inte lika mycket som sin föregångare GF100.

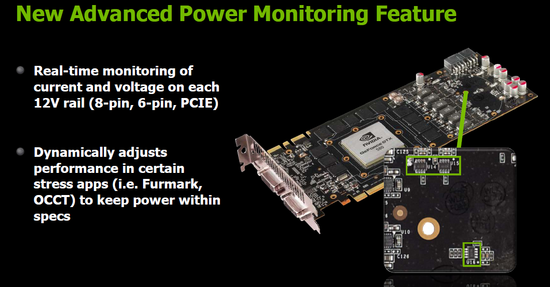

För att tackla detta problemet har NVIDIA dedikerat komponenter på sitt GeForce GTX 580 för att hålla reda på kortets belastning och inte minst strömförbrukning. Detta är något som även AMD arbetat med i sina grafikkort, men bara inte gett några närmare detaljer om. Grundtanken är att grafikkortet känner av när en applikation belastar grafikkretsen onormalt mycket och när strömförbrukningen stiger över ett fördefinerat värde börjar övervakningskretsarna att sänka både spänningar och klockfrekvenser för att hindra kortet från att sluka mer ström än specifikationen tillåter.

I fallet med GeForce GTX 580 har NVIDIA valt att vända blicken mot primärt två applikationer. Det populära Furmark och belastningsmjukvaran OCCT. Dessa applikationer används ofta för att mäta just maximal strömförbrukning på grafikkort och lägger en enorm belastning på kretsarna. I ärlighetens namn är belastningen ofta långt över vad en vanlig användare någonsin kommer att vara i närheten av, även i de mest krävande 3D-spelen, vilket gör att vi kan förstå NVIDIA:s önskan att skydda sina grafikkort i ett orimligt belastningsscenario.

Det orsakar dock vissa problem för oss i media som vill mäta kortets absolut maximala strömförbrukning, samtidigt som vi oroar oss lite över att övervakningskretsarna ska slå till även i andra tillfällen. Vi frågade NVIDIA om eventuella problem vid överklockning, inte minst extrem sådan. Men man hävdar att den mjukvarubaserade lösningen inte ska sätta käppar i hjulet för dem som vill pressa sina kort ytterligare i spel eller andra 3D-tester.

Samtidigt som vi ganska snabbt hittade sätt att kringgå NVIDIA:s begränsningar, något ni får se mer av i våra strömförbrukningstester.

Bättre prestanda per klock än GeForce GTX 480

NVIDIA har även passat på att optimera prestandan i de befintliga beräkningsenheterna och genom att man nu integrerat fullt stöd för FP16 texturfiltrering kan kortets 64 texturenheter pressa ut fler pixlar per klockfrekvens. Samtidigt som förbättringar i stödet för Z-culling ska ge GTX 580 i runda slänger 5-10% bättre prestanda än GTX 480 vid samma antal CUDA-kärnor och klockfrekvenser. Detta är tyvärr omöjligt för oss att testa själva, men NVIDIA menar att man med dessa optimeringar samt fler antal beräkningsenheter samt högre klockfrekvenser ska öka prestandan med mellan 15-30% mot sitt nuvarande flaggskepp, något vi definitivt ska kika närmare på senare i artikeln.

Efter en närmare genomgång av NVIDIA:s nya grafikkrets GF110 är det nu dags att lägga fokus på GeForce GTX 580. Vi skulle kunna dra igång en debatt kring valet av namn, där NVIDIA väljer att starta en helt ny familj trots bara mindre förändringar i en befintlig arkitektur. Men faktum är att vi redan sett något liknande i år med AMD och deras Radeon HD 6000-familj, även om Northern Islands får ses som en större nyhet rent tekniskt än andra generationen av Fermi.

Både AMD och NVIDIA gör sitt yttersta för att marknadsföra sina nya grafikkort, vårt jobb är att se igenom den och se vad som verkligen döljer sig bakom namnen. I slutändan är det viktigaste hur kretsarna presterar och vad de ger oss användare, något som för oss vidare till specifikationerna för NVIDIA:s nya grafikkort.

| GTX 580 | GTX 480 | GTX 470 | GTX 285 | HD 5870 | |

| Tillverkningsteknik | 40nm | 40nm | 40nm | 55nm | 40nm |

| Kärnstorlek | 529 mm2* | 529 mm2* | 529 mm2* | 470 mm2 | 334 mm2 |

| Transistorer | 3 000 milj. | 3 200 milj. | 3 000 milj. | 1 400 milj. | 2 150 milj. |

| Shaderenheter | 512 st. | 480 st. | 448 st. | 240 st. | 1600 st. |

| GPU-frekvens | 772 MHz | 700 MHz | 607 MHz | 648 MHz | 850 MHz |

| Beräkningskraft | 1.58TFLOPs | 1.34TFLOPs | 1.08TFLOPs | 1,01 FLOPs |

2,7 TFLOPs |

| Texturenheter | 64 st. | 60 st. | 56 st. | 80 st. | 80 st. |

| Textur-fillrate | 49.4 Gtexel/s | 42.0 Gtexel/s | 34.0 Gtexel/s | 51.8 Gtexel/s |

68,0 Gtexel/s |

| ROPs | 48 st. | 48 st. | 40 st. | 28 st. | 32 st. |

| Pixel-fillrate | 37.0Gpixel/s | 33.6Gpixel/s | 24.3Gpixel/s | 20,7 Gpixel/s |

27,2 Gpixel/s |

| Minnestyp | GDDR5 | GDDR5 | GDDR5 | GDDR3 | GDDR5 |

| Minnesmängd | 1 536 MB | 1 536 MB | 1 280 MB | 1 024 MB | 1 024 MB |

| Minnesfrekvens | 1 000 MHz (4 000MHz) |

924 MHz (3696MHz) |

837 MHz (3348MHz) |

1242 MHz (2484MHz) |

1200 MHz (4800MHz) |

| Bussbredd | 384-bit | 384-bit | 320-bit | 512-bit | 256-bit |

| Bandbredd | 192,4 GB/s | 177,4 GB/s | 133,9 GB/s | 159,0 GB/s | 153,6 GB/s |

| DirectX-stöd | DX11 | DX11 | DX11 | DX10 | DX11 |

| Max. effekt | 244W | 250W | 215W | 183W | 188W |

Som väntat är skillnaderna inte allt för stora men förutom att NVIDIA alltså utökat antalet beräkningsenheter i form av fler CUDA-kärnor och texturenheter har man trots högre klockfrekvenser specificerat GeForce GTX 580 vid lägre strömförbrukning än sin företrädare.

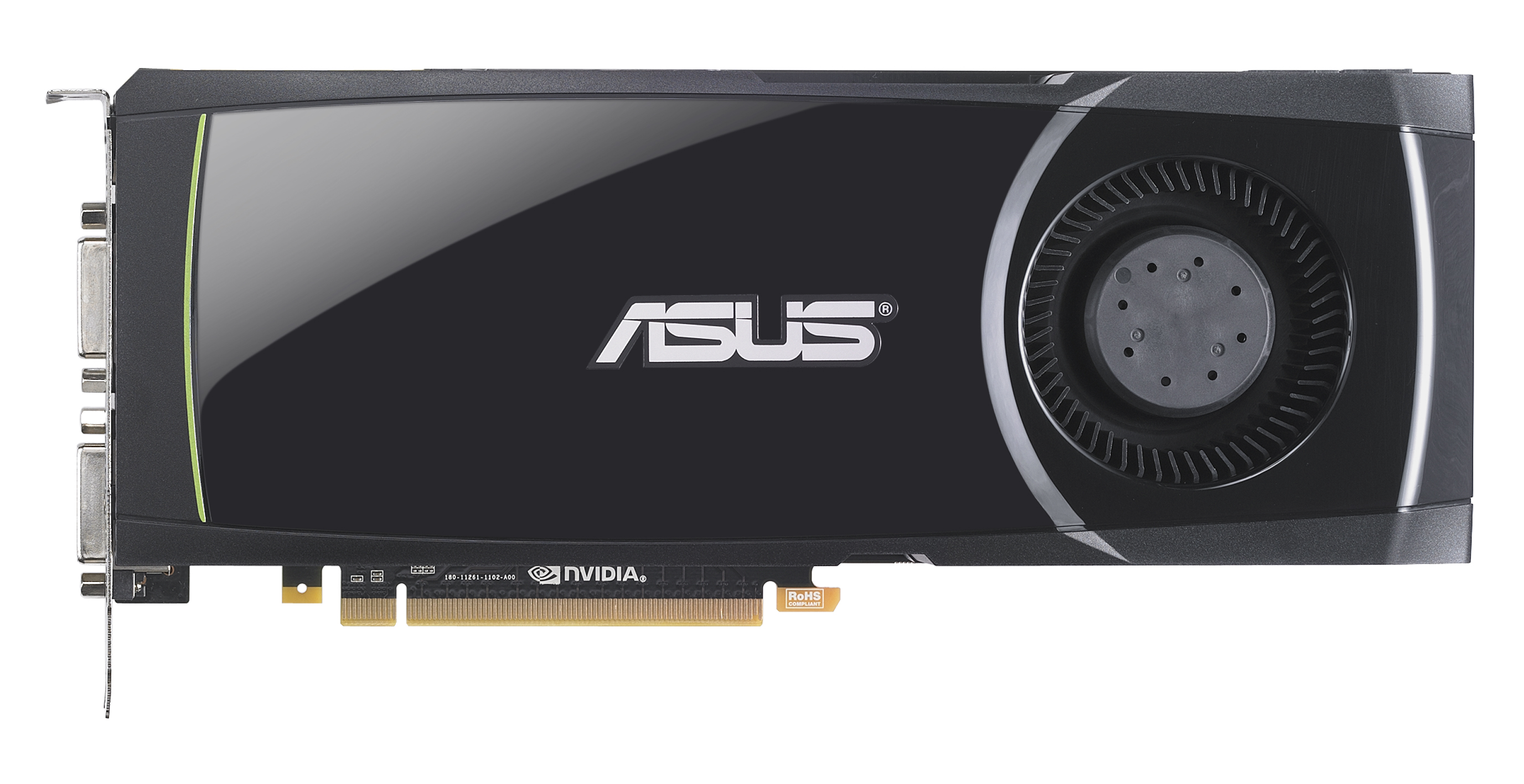

ASUS ENGTX580/2DI/1536MD5

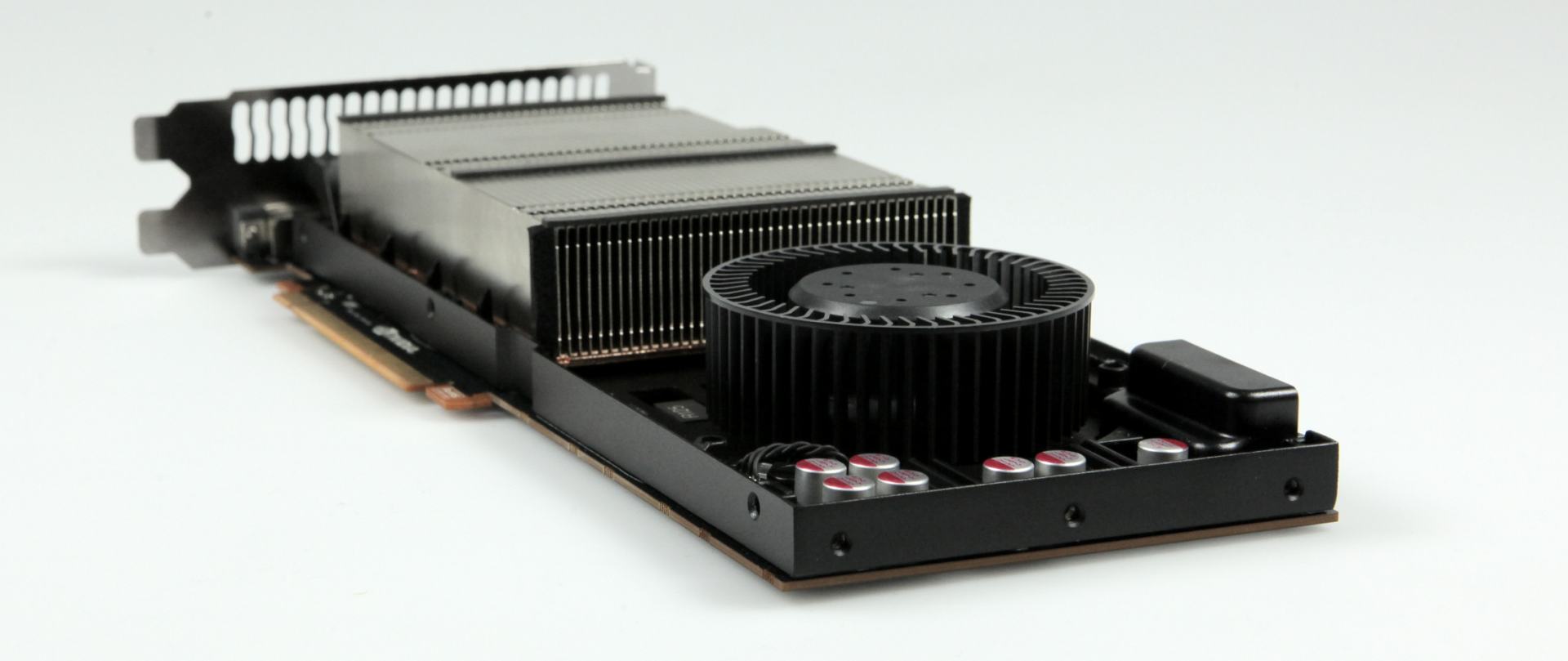

Om vi kikar närmare på själva grafikkortet – som i detta fallet är ett kort från ASUS baserat på referensdesign – får vi bekräftat att även kortets fysisk påminner mycket om föregångaren. Kortet mäter knappt 27 centimeter och är således närmast identiskt med föregångaren GeForce GTX 480. Referensdesignen utrustas med dubbla strömkontakter, en 6-pins samt en 8-pins och vill man koppla in bildskärmar gör man det genom antingen de två DVI-portarna eller en mini-HDMI-kontakt.

Det som i övrigt skiljer ASUS-kortet från mängden är en överklockad grafikkrets. Originalfrekvensen har nämligen ökats med nesliga 10 MHz upp till 782 MHz, men gratis prestanda tackar vi givetvis inte nej till.

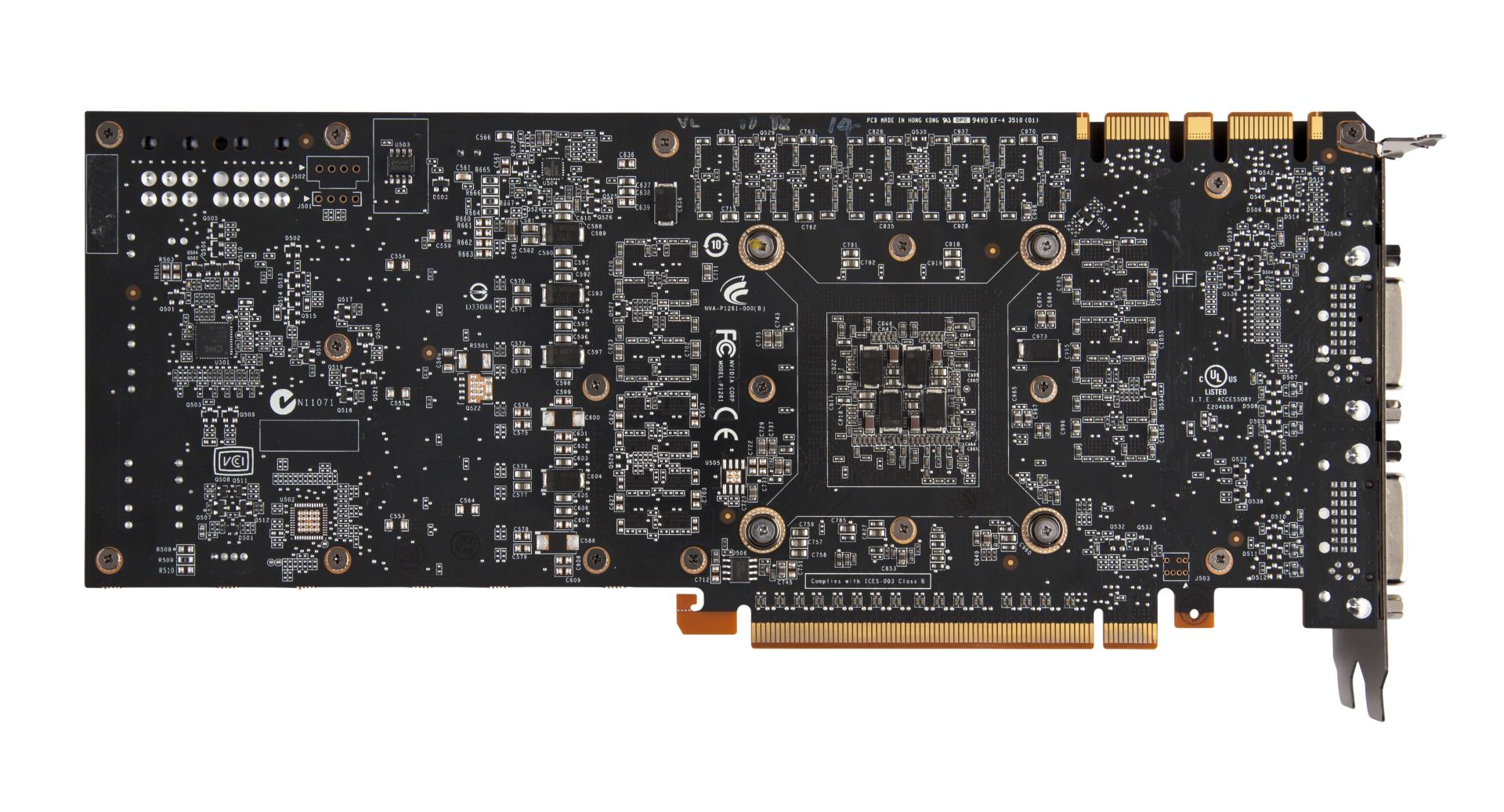

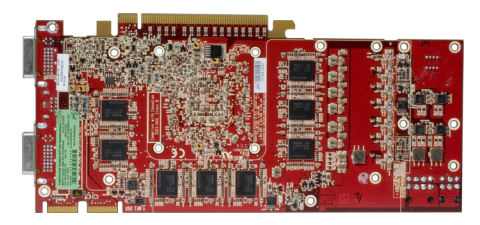

Men om vi dissikerar kortet hittar vi både en ny kylare och ett nytt kretskort.

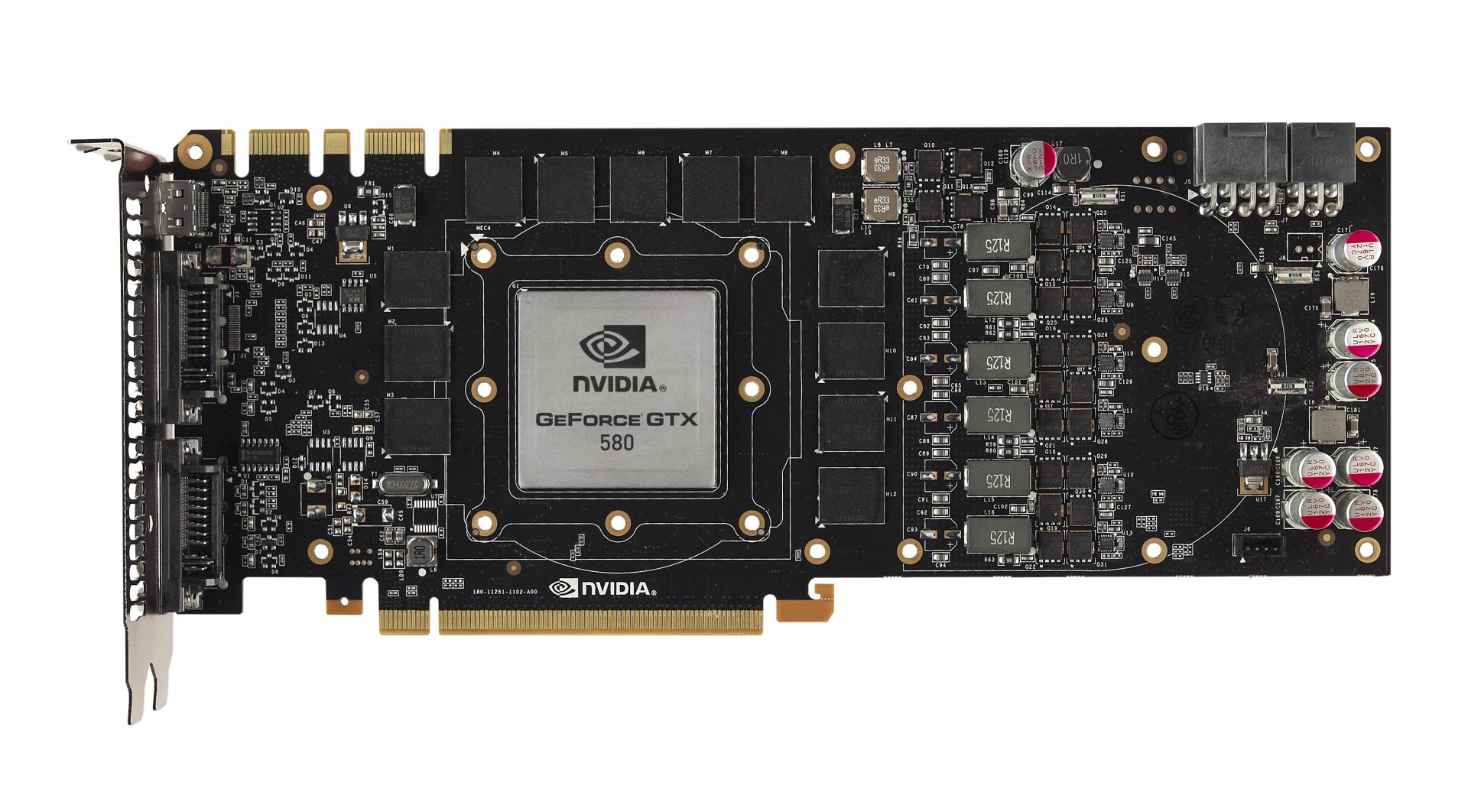

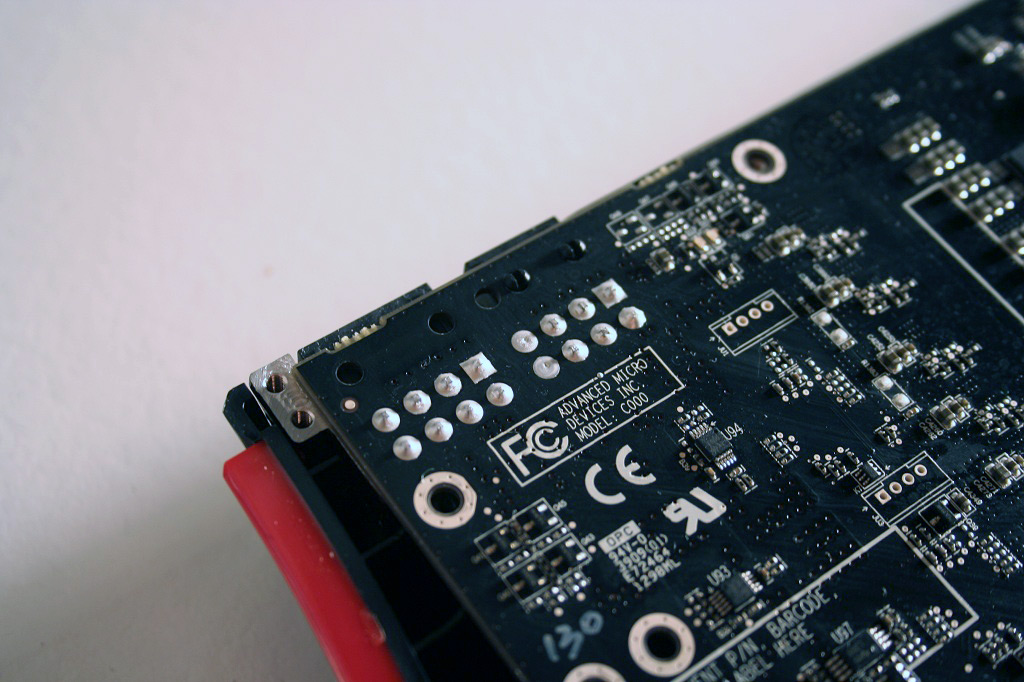

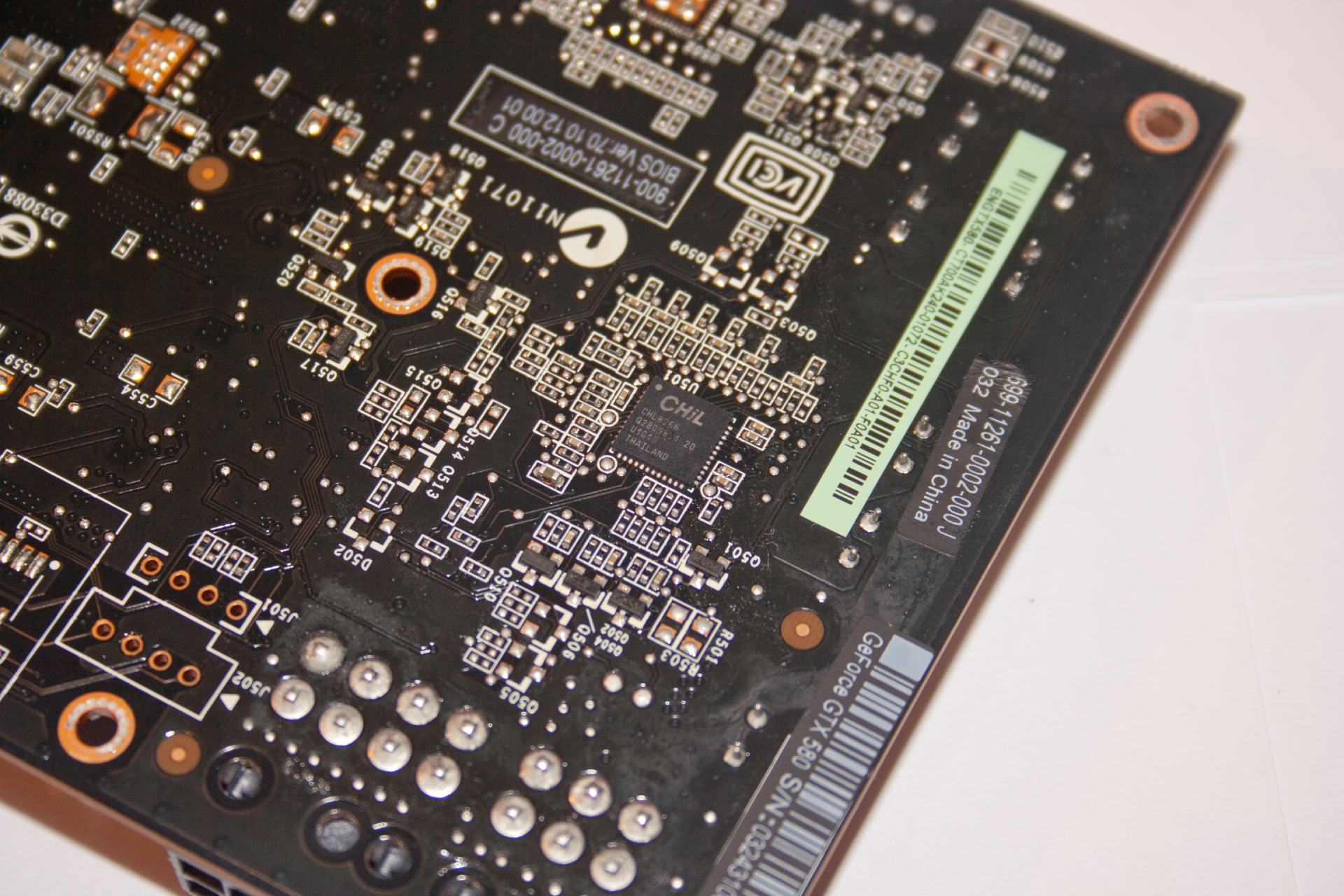

NVIDIA har av någon outgrundlig anledning gått över till en kombination av torx- och stjärnskruvar när man monterat sitt nya flaggskepp och ett tjugotal ettriga skruvar senare står vi här med NVIDIA:s nya flaggskepp, naket och exponerat i all sin skönhet.

Framsidan påminner en del om GTX 480, men med en större märkbar skillnad: kortet är inte utrustat med några ventilationshål till skillnad från föregångaren, i övrigt är upplägget ungefär detsamma.

Baksidan döljer inga större nyheter den heller, förutom att NVIDIA envisats med att jäklas med alla konsumenter som inte har några torx-mejslar hemma. Det mest intressanta vi finner på baksidan är förmodligen Chil:s CH8266-strömkontroller, vilken är densamma som på GTX 480.

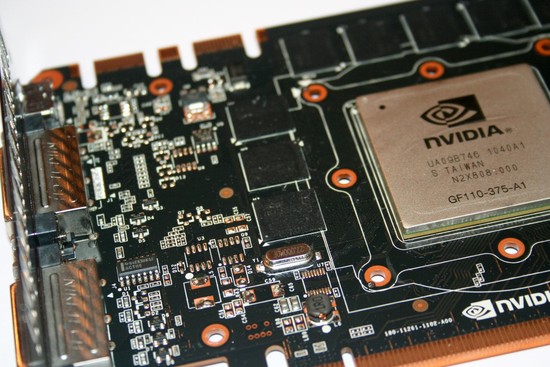

Kärnan är utsmyckad med en ny beteckning, GF110-375 med A1-stepping, till skillnad från GF100 på GTX 480.

Minnena levereras av Samsung och är specificerade till 1250 MHz. Minneskontrollern säger dock stopp för att leverera korten med denna frekvens från fabrik.

NVIDIA har alltså valt att fortsätta med samma Chil-kontroller för spänningen, vilket innebär precis som för GTX 480 ett spektra av program som kan ändra spänningar, så fort GTX 580 läggs till i deras databaser, något vi applåderar. Det onekligen största problemet med kortet måste vara användningen av Torx-skruvar, enda anledningen till detta vi kan se är för att försvåra för konsumenter att lossa dessa, vilket vi som entusiaster inte riktigt kan stödja. Å andra sidan har de flesta förmodligen redan en del Torx-mejslar hemma redan, men principen är densamma; det är ofint att försöka hämma entusiaster i våra ögon.

På nästa sida tar vi en närmare titt på kylaren.

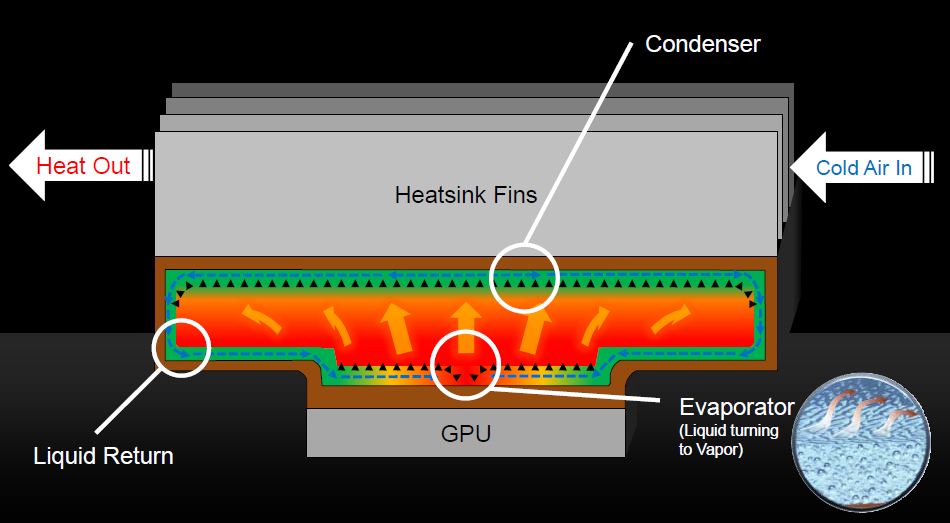

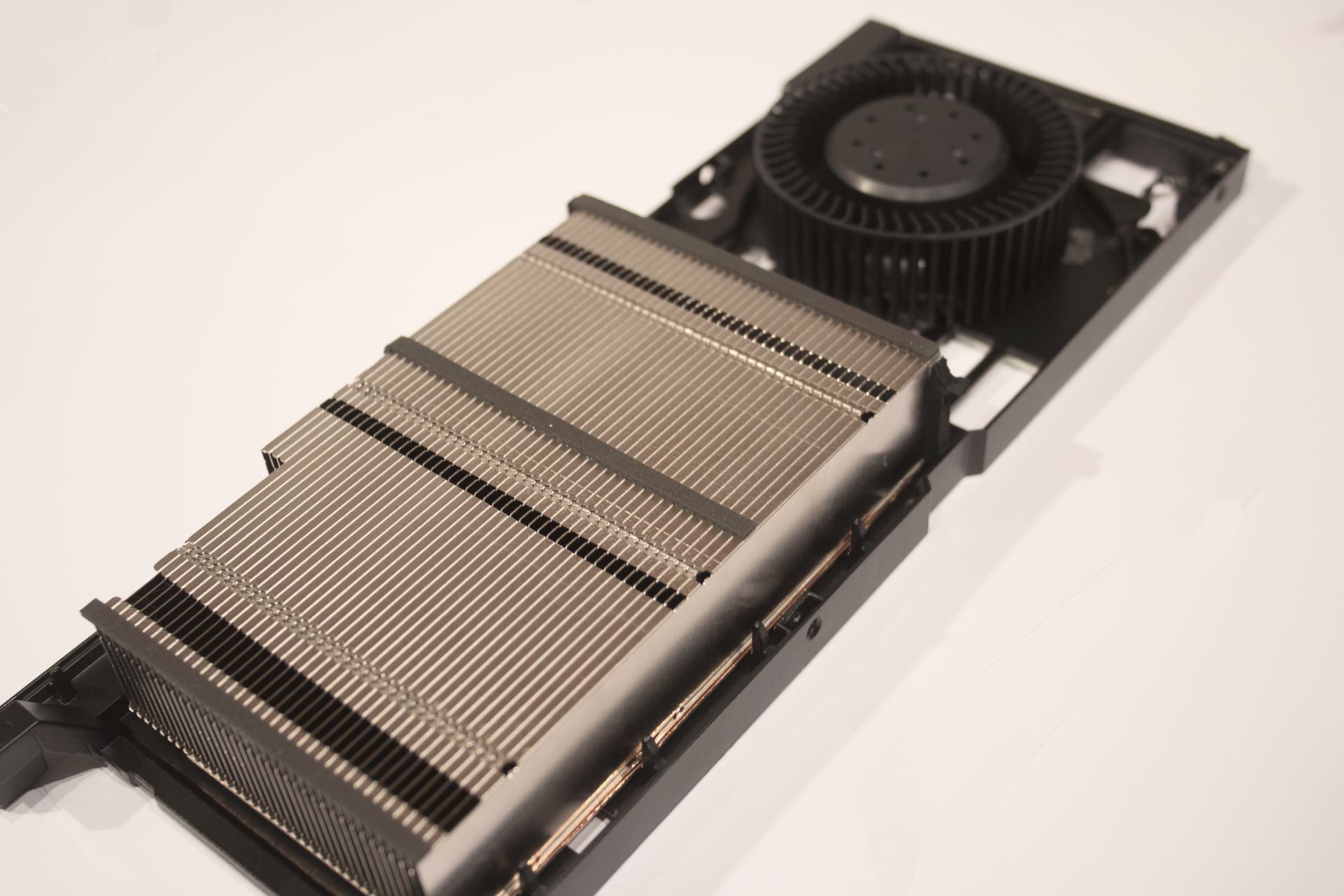

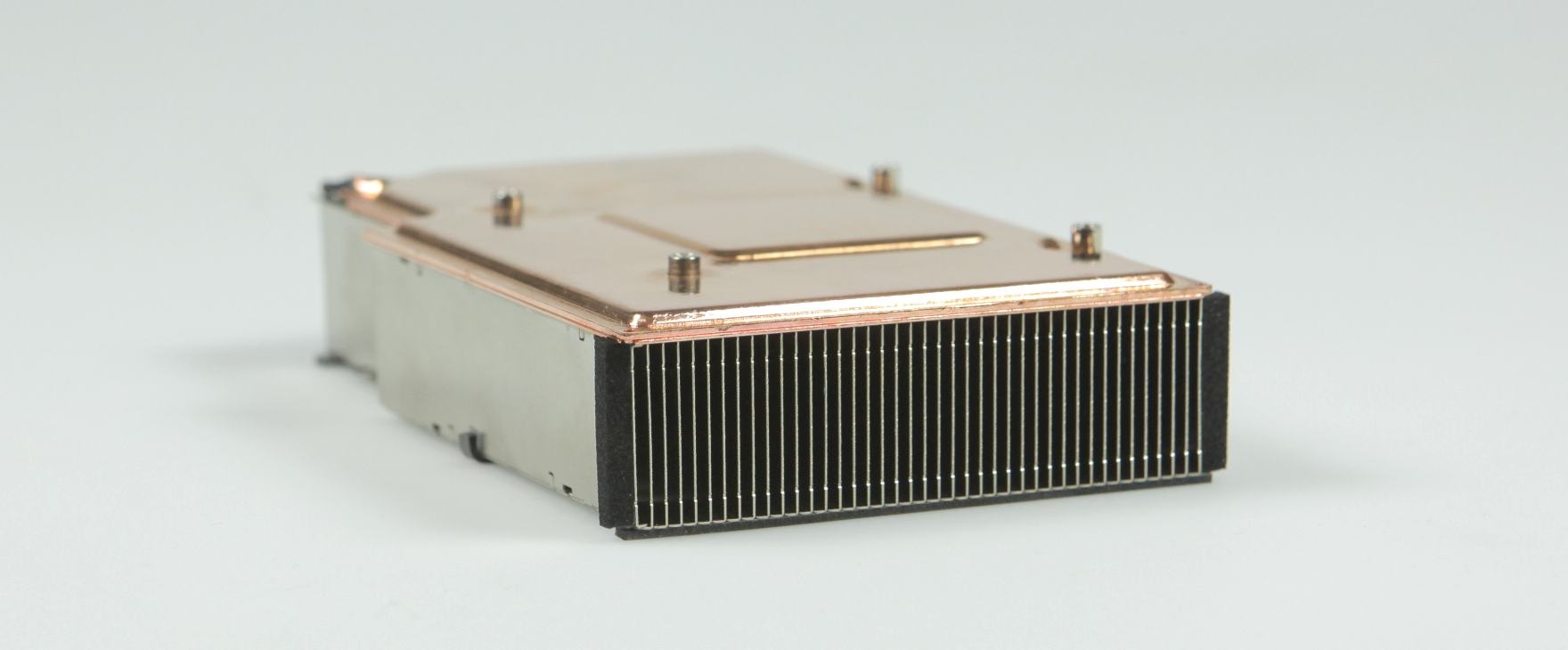

Förutom en ny och effektivare grafikkrets har NVIDIA ytterligare ett ess i skjortärmen för att nå sina mål med GeForce GTX 580. För att förhindra en ny omgång hån för sitt flaggskepps värmeutveckling och ljudnivå har man utrustat grafikkortet med en ny kylare.

Grafikkortskylaren använder sig inte av de klassiska värmerören som annars är så vanliga idag. Istället har NVIDIA valt en annan form av förångningsteknik. Hjärtat i NVIDIA:s nya kylare är en förångningskammare som ligger mer eller mindre i direktkontakt med grafikkretsen. Inkapslad i koppar är kylflänsen optimerad för att snabbt och effektivt föra värmen från grafikkretsen till en mängd aluminiumflänsar som sedan kyls ned av en radialfläkt i bakänden av kortet. Kylarens hölje är också optimerat för att leda luften genom kylflänsen och rakt ut ur chassit genom expansionsplatsen.

NVIDIA har själva utvecklat kylarens design och menar att all luft nu dras in i kylaren från chassit, samtidigt som all varmluft pressas ut ur chassit. Något vi märkt i egna tester är klart gynnsamt för övriga komponenter i systemet. Kylarkåpan är inte heller lika hög som på GTX 480 vilket ska minimera problem med SLI-bryggor och liknande, något man fick kritik för med föregångaren.

Förutom själva kylflänsen har NVIDIA även sett över fläkten som ska arbeta vid en lägre tonhöjd och överlag ge mindre ljud ifrån sig än föregångaren. Samtidigt har man integrerat en ny adaptiv algoritm för fläktkontrollern som ska ge jämnar ut upp-/nedrampningstiderna av fläkthastigheten under belastning.

NVIDIA hävdar att kylaren inte bara är effektivare än sin föregångare utan även gör GeForce GTX 580 inte bara mycket tystare än sin föregångare utan även tidigare toppmodeller från företaget. Hur effektiv den verkligen är får vi återkomma till snart.

| Testsystem | |

| Moderkort | ASUS Rampage III Extreme |

| CPU | Intel Core i7-980X @ 3.46GHz |

| RAM | 6GB Corsair CMGTX2 3x2GB |

| Grafikkort | ASUS GeForce GTX 580 (782/4000 MHz) XFX Radeon HD 6870 XFX Radeon HD 6850 ASUS Radeon HD 6870 NVIDIA GeForce GTX 460 1GB (675/3600 MHz) EVGA GeForce GTX 460 768MB SuperClocked (763/3800 MHz) MSI GeForce GTX 460 1GB Cyclone (725/3600 MHz) MSI Lightning GeForce GTX 480 1536MB (700/3696 MHz) HIS Radeon HD 5850 1GB ASUS Radeon HD 5870 1GB |

| Hårddisk | Western Digital VelociRaptor 300GB |

| Operativsystem | Microsoft Windows 7 64-bit |

| Drivrutiner | NVIDIA ForceWare 262.99 (GTX 580 och GTX 480) NVIDIA ForceWare 260.89 ATI Catalyst 8.782 |

| Testprogram | 3DMark 06 3DMark Vantage Unigine Heaven 2.1 Aliens vs Predator Crysis: Warhead Metro 2033 Lost Planet 2 Resident Evil 5 Final Fantasy XIV StarCraft II: Wings of Liberty S.T.A.L.K.E.R: Call of Pripyat MSI Kombustor |

Testsystem vi använt oss av är baserat på Intels LGA1366-plattform och för att få grafikkorten att jobba riktigt ordentligt har vi valt en sexkärnig Intel Core i7 980X processor som hjärtat i systemet. De kompletta specifikationerna kan ni se ovan.

Testmetodik

Vi har under våra tester valt att begränsa resultaten till upplösningen 1920×1080 pixlar samtidigt som primärt fokuserat på ganska kraftiga inställningar av kantutjämning och anisotropisk filtrering för att optimera bildkvalitén och visa vilken prestanda man som minst kan vänta sig av dessa kort. Referensinställningarna ställda i grafikkortens drivrutiner till 8x SSAA och 16x AF för AMD-korten samt 8x AA Q och 16x AF för NVIDIA.

Den mest intressanta jämförelsen är mellan Radeon HD 5870 och NVIDIA GeForce GTX 480, de två kraftfullaste singel-GPU grafikkorten på marknaden idag. Det senare kortet gestaltas idag av ett nerklockat MSI GeForce GTX 480 Lightning som simulerar exakt den prestanda man kan vänta sig av NVIDIA:s tidigare flaggskepp. Men vi har även medlemmar ur Radeon HD 5700/5800/6800-serierna samt GeForce GTX 460 med på ett hörn för att få lite fler referenspunkter.

Med det sagt kastar vi oss in på prestandatesterna.

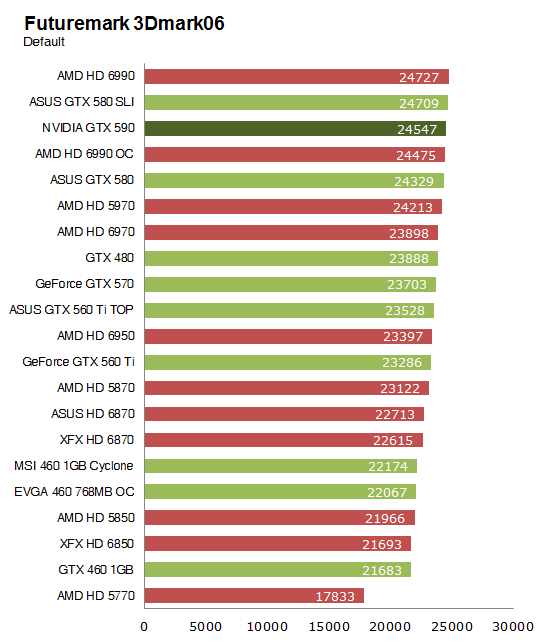

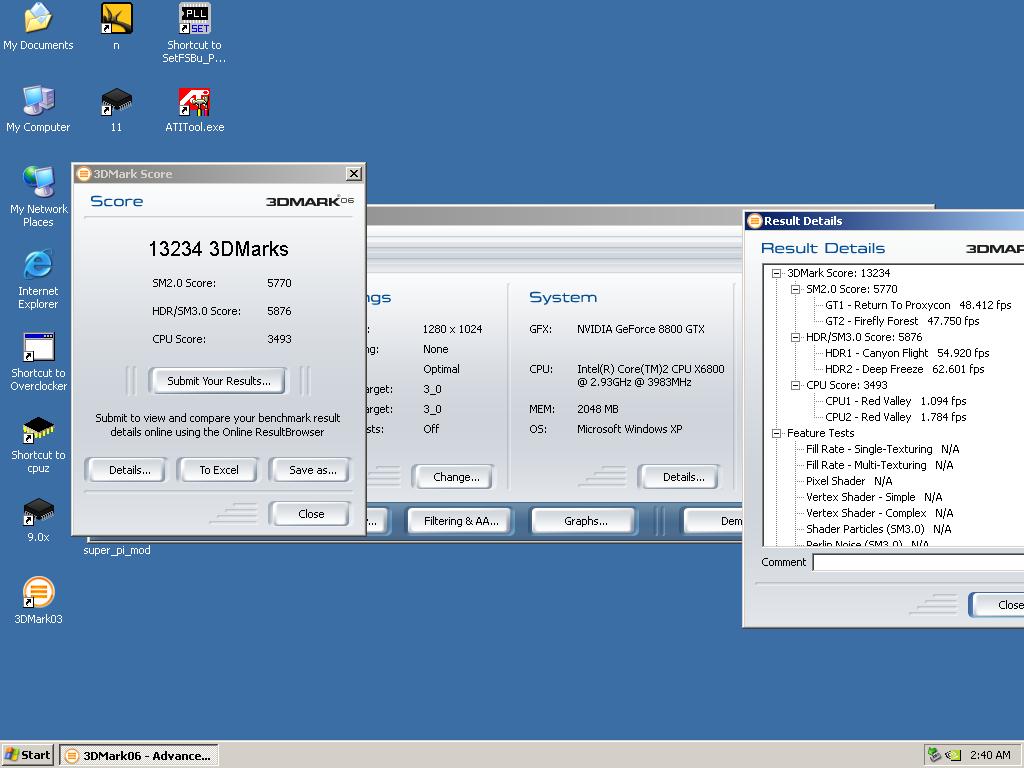

| Futuremark 3DMark06 | |

| Genre: | Syntetiskt 3D-test |

| Grafikmotor: | Egenutvecklad, DirectX 9.0c |

| Systemkrav: | Enkelkärnig CPU på över 2,5 GHz 1GB internminne Grafikkort (256MB minne) med DirectX 9.0c stöd |

| Kommentar: | Populärt prestandatest för grafikkortet och övriga komponenter. – Hemsida |

| Prestandatest: | Inbyggd testfunktion. Standardupplösning: 1280×1024 (poäng) |

GeForce GTX 580 går lite löst ut med en 500 poäng stor ökning jämfört med 480 i 3DMark 06, som i ärlighetens namn med CPU:n tuffandes på i modesta 3,46GHz är ganska CPU-begränsat, varför inga större skillnader syns. En komfortabel delseger för nykomlingen alltså, där även företrädaren GTX 480 inte hade några problem att hålla AMD-motståndet bakom sig.

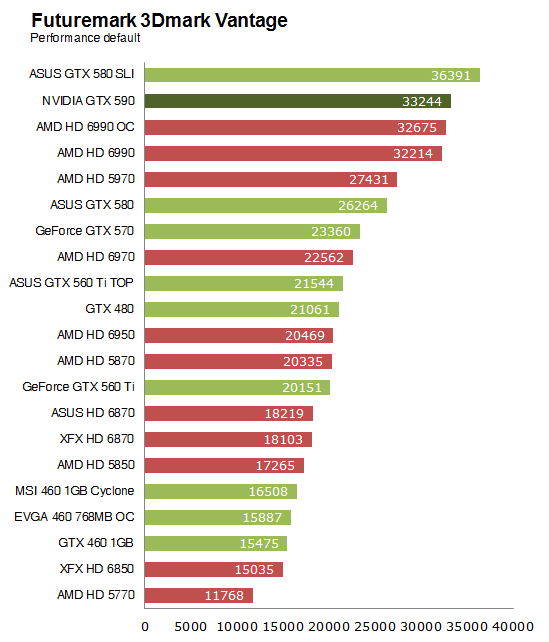

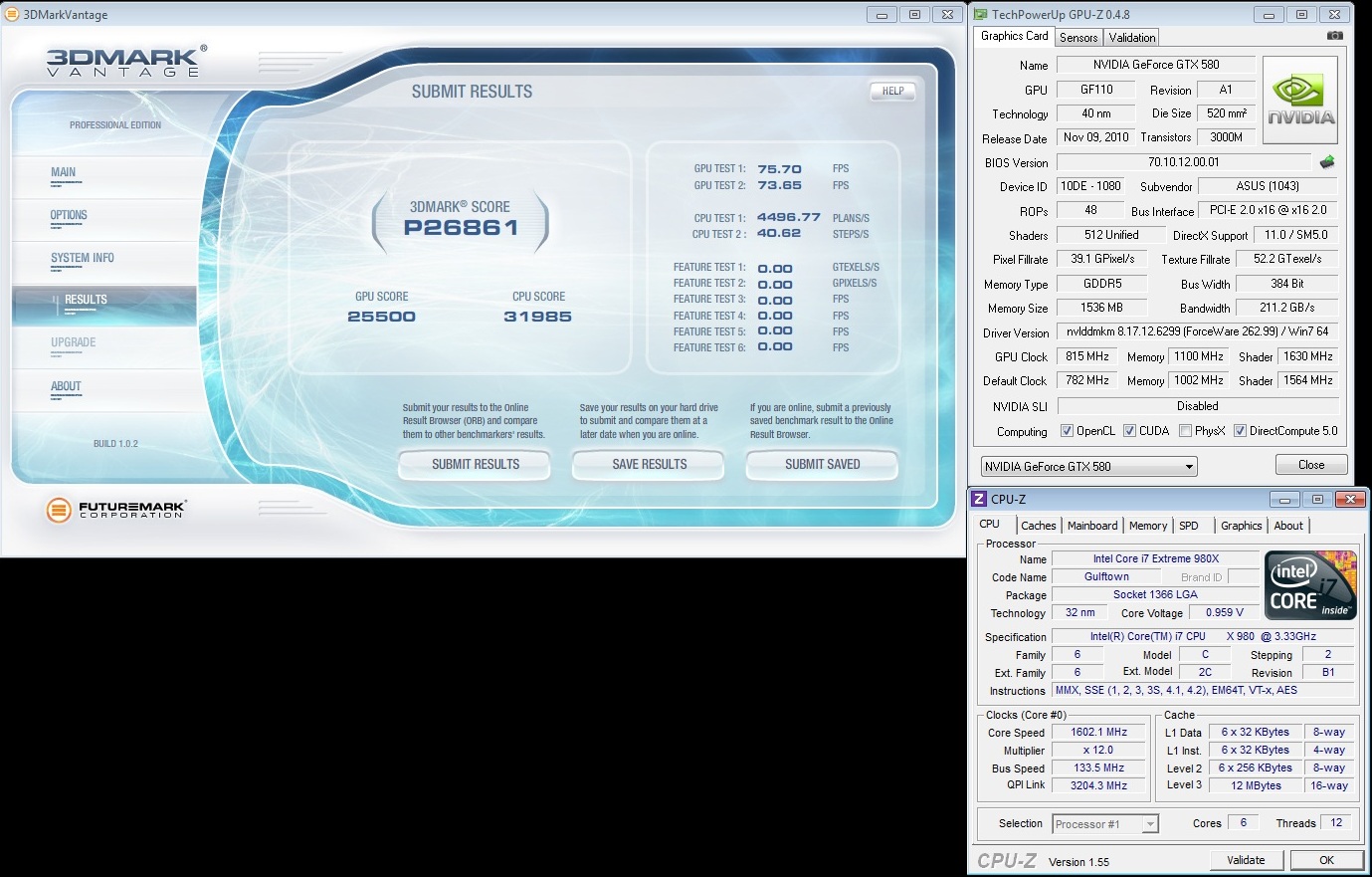

| Futuremark 3DMark Vantage | |

| Genre: | Syntetiskt 3D-test |

| Grafikmotor: | Egenutvecklad, DirectX 10.0 |

| Systemkrav: | Tvåkärnig, motsvarande Intel Core 2 Duo E6600 eller AMD Athlon X2 6000+ 2GB internminne Grafikkort (512MB minne) med DirectX 10.0 stöd |

| Kommentar: | Senaste versionen av 3DMark med tyngre belastning på grafikkortet, kräver DX10. – Hemsida |

| Prestandatest: | Inbyggd testfunktion, Performance preset Standardupplösning: 1280×1024 (poäng) |

3DMark Vantage är till skillnad från 06 mycket mindre beroende av CPU-frekvensen, vilket låter grafikkorten gå loss på pixlarna i det närmaste obehindrat. Här ser vi vad som endast kan beskrivas som en brutal slakt av motståndet från GTX 580, med över 5000 poäng ner till GTX 480 och närmare 6000 poäng till bästa AMD-kort, HD 5870. Vi återkommer till just Vantage i våra överklockningstester.

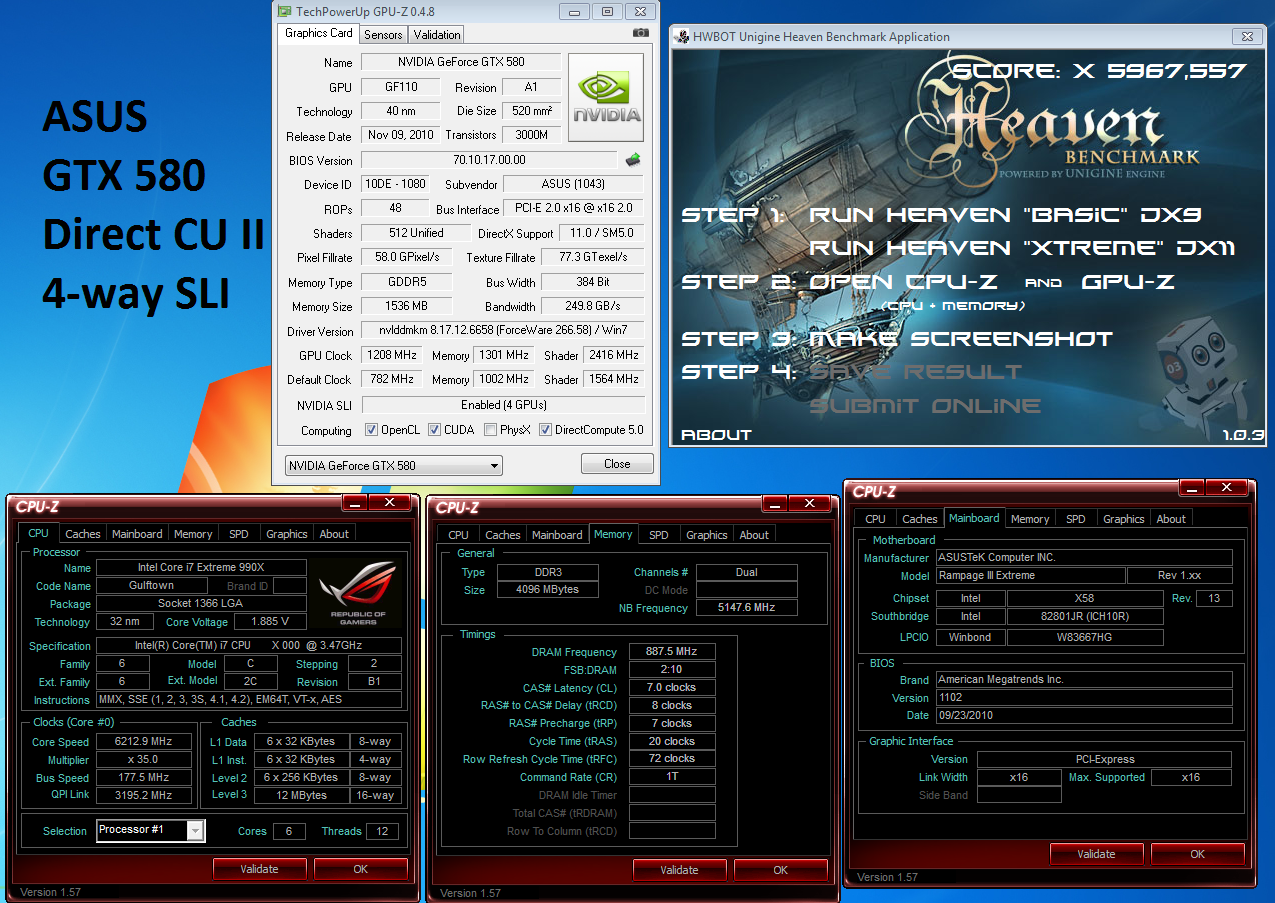

| Unigine Heaven 2.0 | |

| Genre: | Syntetiskt 3D-test |

| Grafikmotor: | Unigine Engine, DirectX 11.0 |

| Systemkrav: | Grafikkort från ATI Radeon HD 2xxx och NVIDIA GeForce 7xxx serierna, eller nyare. För Tessellation-tester krävs grafikkort med DX11-stöd. |

| Kommentar: | Tungt 3D-test med fokus på DirectX 11 och inte minst Tessellation-effekter. – Hemsida |

| Prestandatest: | Inbyggd testfunktion. Upplösning: 1920×1080 pixlar, 4x anisotrophy (poäng) |

Heaven från Unigine är ett ganska tungt DX11-test utvecklat för att testa tesseleringsprestanda först och främst, och här har GTX 480 alltid varit kung. Fram tills nu, alltså. Närmare 12 fps, eller runt 22% bättre är den nya Fermi-arkitekturen i just Heaven, medan AMD är vad man endast kan kalla långt efter.

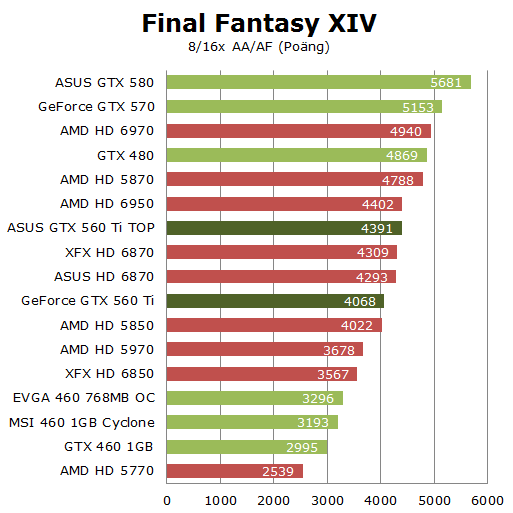

| Final Fantasy XIV | |

| Genre: | Sci-Fi, Massively multiplayer online role-playing game |

| Grafikmotor: | Egenutvecklad, DX9.0c |

| Systemkrav: | Intel Core 2 Duo 2,0 GHz/ AMD Athlon 64 X2 3800+ 1GB internminne Grafikkort (256MB minne) med DirectX 9.0c stöd |

| Kommentar: | Klassisk spelsaga nu i MMORPG-tappning med kraftfull grafikmotor. – Hemsida |

| Prestandatest: | Separat prestandatest. Test 1: 1920×1080, 16/8x AA/AF (poäng) Test 2: 1920×1080, 0/0x AA/AF (poäng) |

För att komma igång med våra speltester för dagen har vi börjat med Final Fantasy, som ja… Är ett spel med en benchmarkfunktion. Även här visar Fermi-familjen vägen, med en 16% stor ökning från GTX 480 till 580.

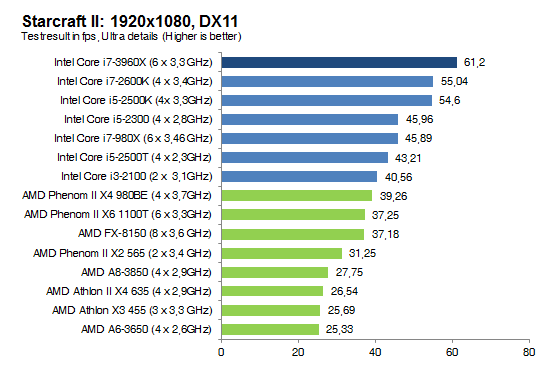

| Starcraft II | |

| Genre: | Sci-Fi Realtidsstrategispel |

| Grafikmotor: | Egenutvecklad, DX9.0c |

| Systemkrav: | Intel Pentium 4 2,6 GHz eller motsvarande AMD processor 1GB internminne (1,5GB för Windows Vista/7) Grafikkort (128MB minne) med DirectX 9.0c stöd |

| Kommentar: | “Världens mest sålda realtidsstrategispel som trots låga systemkrav kan ge tung grafisk belastning.” – Hemsida |

| Prestandatest: | 3min FRAPS under uppspelning av 1v1 replay Test 1: 1920×1080, 0/0x AA/AF, Ultra (FPS) |

Starcraft II är bekant för de flesta, och vi kör här utan AA/AF på, då dessa ger en horribel prestandaförlust. Återigen är GTX 580 vassare än 480, dock inte med samma förkrossande marginal som vi sett hittills, men utan tvekan är kortet herre på täppan.

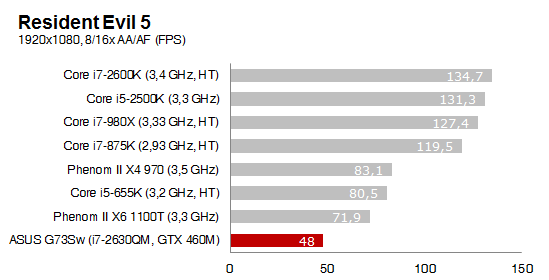

| Resident Evil 5 | |

| Genre: | Skräck Third-person shooter |

| Grafikmotor: | MT Framework, DX10.0 |

| Systemkrav: | Intel Core 2 Duo 2,0 GHz/ AMD Athlon 64 X2 3800+ 1GB internminne Grafikkort (256MB minne) med DirectX 9.0c stöd (DX10 rekommenderat) |

| Kommentar: | Klassisk rysaraction med gott om zombies och blod. – Hemsida |

| Prestandatest: | Inbyggd testfunktion. Test 1: 1920×1080, 16/8x AA/AF (FPS) Test 2: 1920×1080, 0/0x AA/AF (FPS) |

Resident Evil är till stor del CPU-begränsat, men något händer när systemet känner lukten av en Fermi-kärna, vare sig det är GF100 eller GF110. Vi börjar känna igen GTX 580 på topp vid det här laget, även om det inte känns speciellt tjatigt, måste vi påstå.

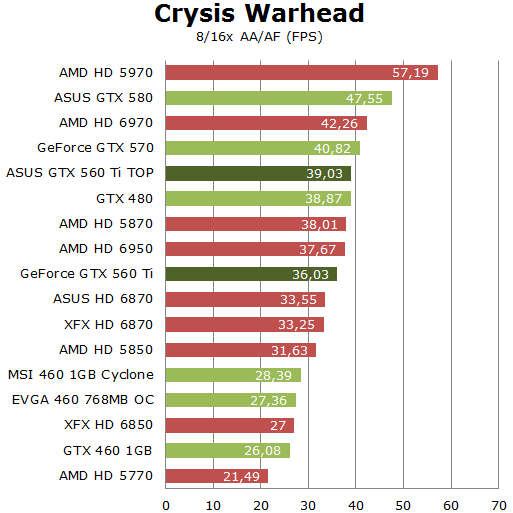

| Crysis Warhead | |

| Genre: | Sci-Fi Förstapersonsskjutare |

| Grafikmotor: | CryEngine2, DX10.0 |

| Systemkrav: | Intel Core 2 Duo 2,0 GHz/ AMD Athlon 64 X2 3800+ 1GB internminne Grafikkort (256MB minne) med DX10 stöd |

| Kommentar: | “Uppföljaren till världens kanske snyggaste och mest krävande spel.” – Hemsida |

| Prestandatest: | Inbyggd testfunktion. Test 1: 1920×1080, Enthusiast preset, Ambush map, 16/8x AA/AF (FPS) Test 2: 1920×1080, Enthusiast preset, Ambush map, 0/0x AA/AF (FPS) |

Gammal är äldst, och Crysis Warhead har hängt med i evigheter, känns det som. Spelet pressar fortfarande grafikkort till det yttersta, vare sig det är på grund av dålig optimering eller helt enkelt höga krav, det ser hur som helst bra ut. Här var det tidigare jämnt mellan AMD och NVIDIA, men GTX 580 återupprättar hedern och ger en 22-procentig ökning i FPS från GTX 480.

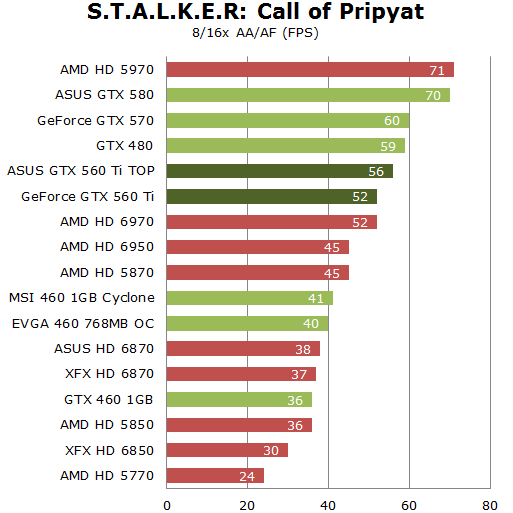

| S.T.A.L.K.E.R : Call of Pripyat | |

| Genre: | Sci-Fi Förstapersonsskjutare |

| Grafikmotor: | X-Ray 1.6, DirectX 11.0 |

| Systemkrav: | Intel Pentium 4 2,0 GHz eller motsvarande AMD processor 512MB internminne Grafikkort (128MB minne) med DirectX 8.0 stöd |

| Kommentar: | Vi strider vidare i ett radioaktivt Tjernobyl på jakt efter mutanter och reliker. – Hemsida |

| Prestandatest: | Separat prestandatest. Test 1: 1920×1080, SunShafts, Ultra, DX11, tesselation, CHS, 16/8x AA/AF (FPS) Test 2: 1920×1080, SunShafts, Ultra, DX11, tesselation, CHS, 0/0x AA/AF (FPS) |

Stalker är nästa spel i raden, och vi tar resultaten från deltestet SunShafts. Vi har sett det förr, GTX 580 är överlägset, denna gång med en 18-procentig ökning från GTX 480.

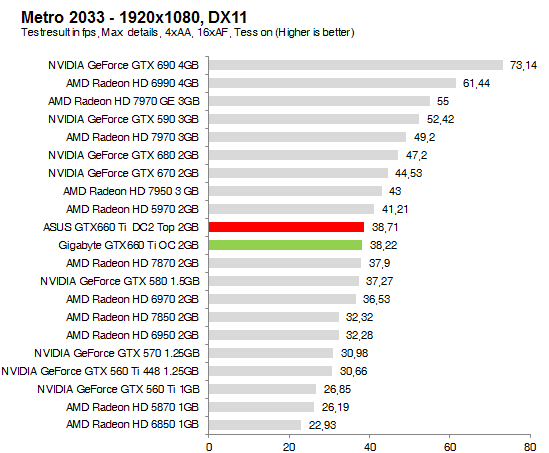

| Metro 2033 | |

| Genre: | Sci-Fi skräck Förstapersonsskjutare |

| Grafikmotor: | A4, DirectX 11.0 |

| Systemkrav: | Tvåkärnig CPU (Core 2 Duo eller bättre) 1GB internminne Grafikkort med DirectX 9.0 stöd, helst även DX11. |

| Kommentar: | Återigen har kärnvapnen drabbat ryssland och Metro 2033 tar oss ner i mörka tunnelbanesystem i ett försök att överleva. – Hemsida |

| Prestandatest: | Separat prestandatest. Test 1: 1920×1080, 16/8x AA/AF (FPS) Test 2: 1920×1080, 0/0x AA/AF (FPS) |

Metro 2033 är precis som Heaven mycket tungt tesselerat, vilket brukar borga för NVIDIA-prestanda, så även idag. Närmare 20% förbättring från GTX 480 finner vi i 580, och motståndet har helt enkelt inte en sportmössa.

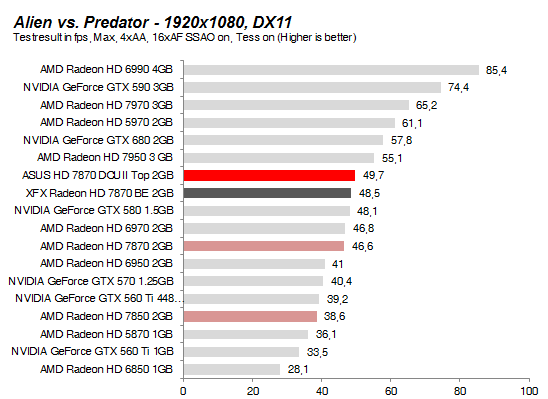

| Aliens vs Predator | |

| Genre: | Sci-Fi skräck Förstapersonsskjutare |

| Grafikmotor: | A4, DirectX 11.0 |

| Systemkrav: | Intel Pentium 4 3,2 GHz CPU/ AMD Athlon 64 3000+ 1GB internminne Grafikkort med DirectX 9.0c stöd och 128MB minne |

| Kommentar: | Marines, aliens och rovdjur ger i vanlig ordning en redig dos action och mörka tunnlar som skrämmer slag på de flesta. – Hemsida |

| Prestandatest: | Separat prestandatest. Test 1: 1920×1080, 16/8x AA/AF (FPS) Test 2: 1920×1080, 0/0x AA/AF (FPS) |

Alien vs. Predator är en het potatis fär AMD har diverse uppdateringar som NVIDIA försöker reda ut med en configfil. Vi motstod dock frestelsen att använda denna, med exempelvis Batman: Arkham Asylum i åtanke och förväntade oss en AMD-seger. GTX 580 kom dock till undsättning precis som vanligt och levererar närmare 15 fps eller 26.5% mer igenom testet, där man återigen är absolut snabbaste singel-GPU-kort.

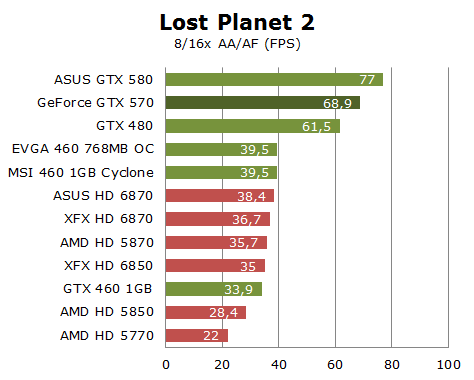

| Lost Planet 2 | |

| Genre: | Sci-Fi skräck Tredjepersonsskjutare |

| Grafikmotor: | MT Framework 2.0, DirectX 11.0 |

| Systemkrav: | Intel Pentium 4 3,2 GHz CPU/ AMD Athlon 64 3000+ 1GB internminne Grafikkort med DirectX 9.0c stöd och 128MB minne |

| Kommentar: | Tampas med gigantiska fiender i djungler och snölandskap, själv eller ännu hellre med dina vänner. – Hemsida |

| Prestandatest: | Separat prestandatest. Test 1: 1920×1080, Type A, 16/8x AA/AF (FPS) Test 2: 1920×1080, Type A, 0/0x AA/AF (FPS) |

Lost Planet 2 är ett spel utvecklat i samarbete med NVIDIA, vilket kanske kan förklara resultaten ovan, där man gör rent hus. GTX 580 är återigen fruktansvärt mycket vassare än föregångaren GTX 480, och ljusår före AMD-motståndet.

Med det har vi kollat igenom alla prestandatester, kika närmare på överklockningsresultat på nästa sida.

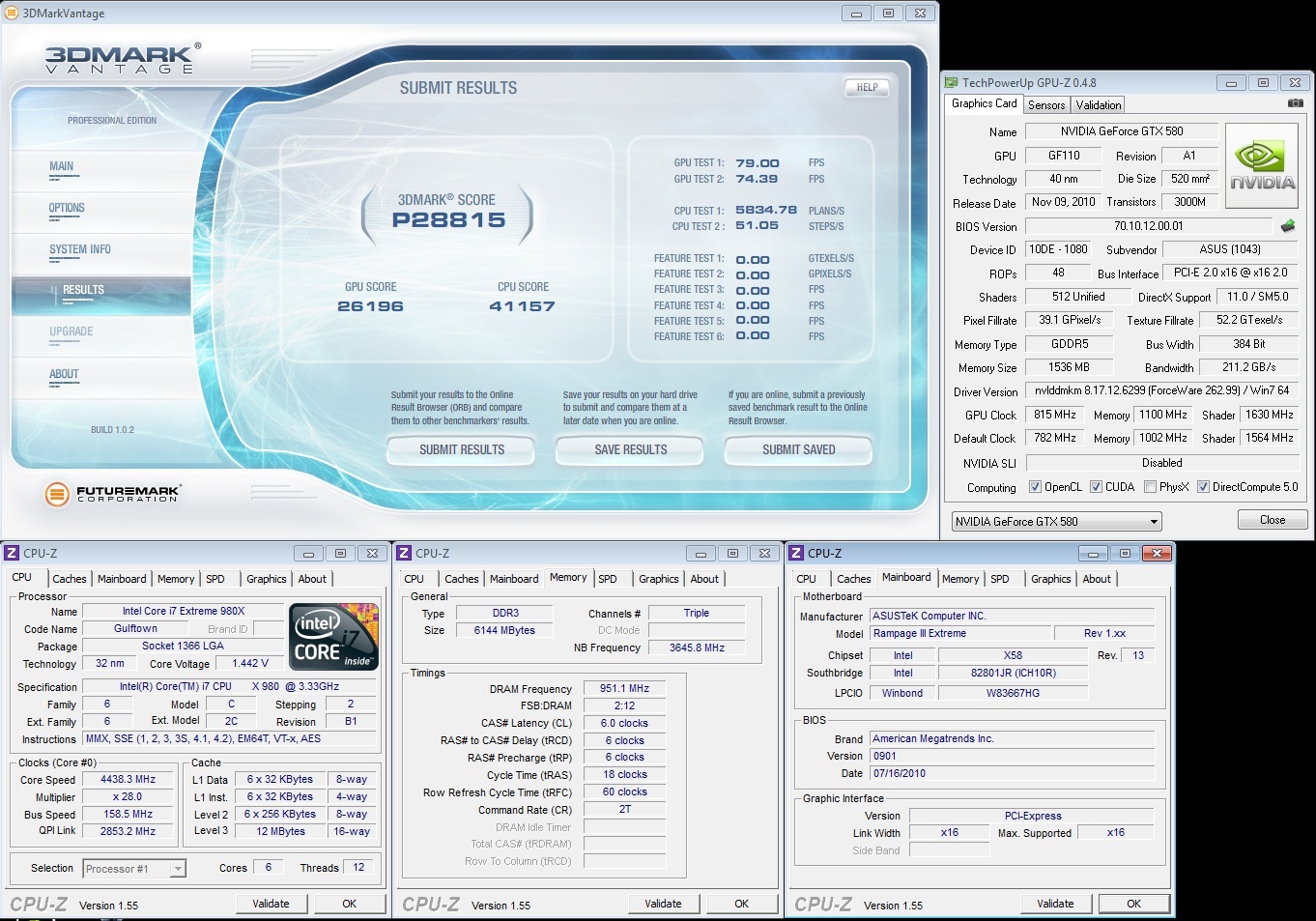

Överklockningen av GTX 480 på luft begränsades till rätt stor del av den kolossala värmeutvecklingen kortet led av, och även om GTX 580 inte direkt är något kort som kan klassas som massivt svalt är det åtminstone svalare. Däremot är frekvenserna högre från fabrik, vilket gör att den procentuella ökningen förmodligen kommer bli lägre i vilket fall som helst. Våra överklockningstester utförs i 3DMark Vantage, där GTX 580 har ett massivt övertag över samtliga konkurrenter.

Börjar vi så smått med GTX 580 i standardspänningar, dvs en överklockning du förmodligen skulle kunna använda dagligen, landar vi på 815/1100, vilket med en CPU i standardfrekvenser ger detta resultat:

26861 poäng är en inte enorm ökning från de drygt 26200 vi åstadkom med standardfrekvenserna 782/1002, men detta skulle kunna bero på att grafikkortet blir hindrat av en “slö” Core i7 980X i standardfrekvenserna 3.46GHz. Kör vi om testet med CPU:n bumpad till 4438MHz med andra optimeringar, blir resultatet istället såhär:

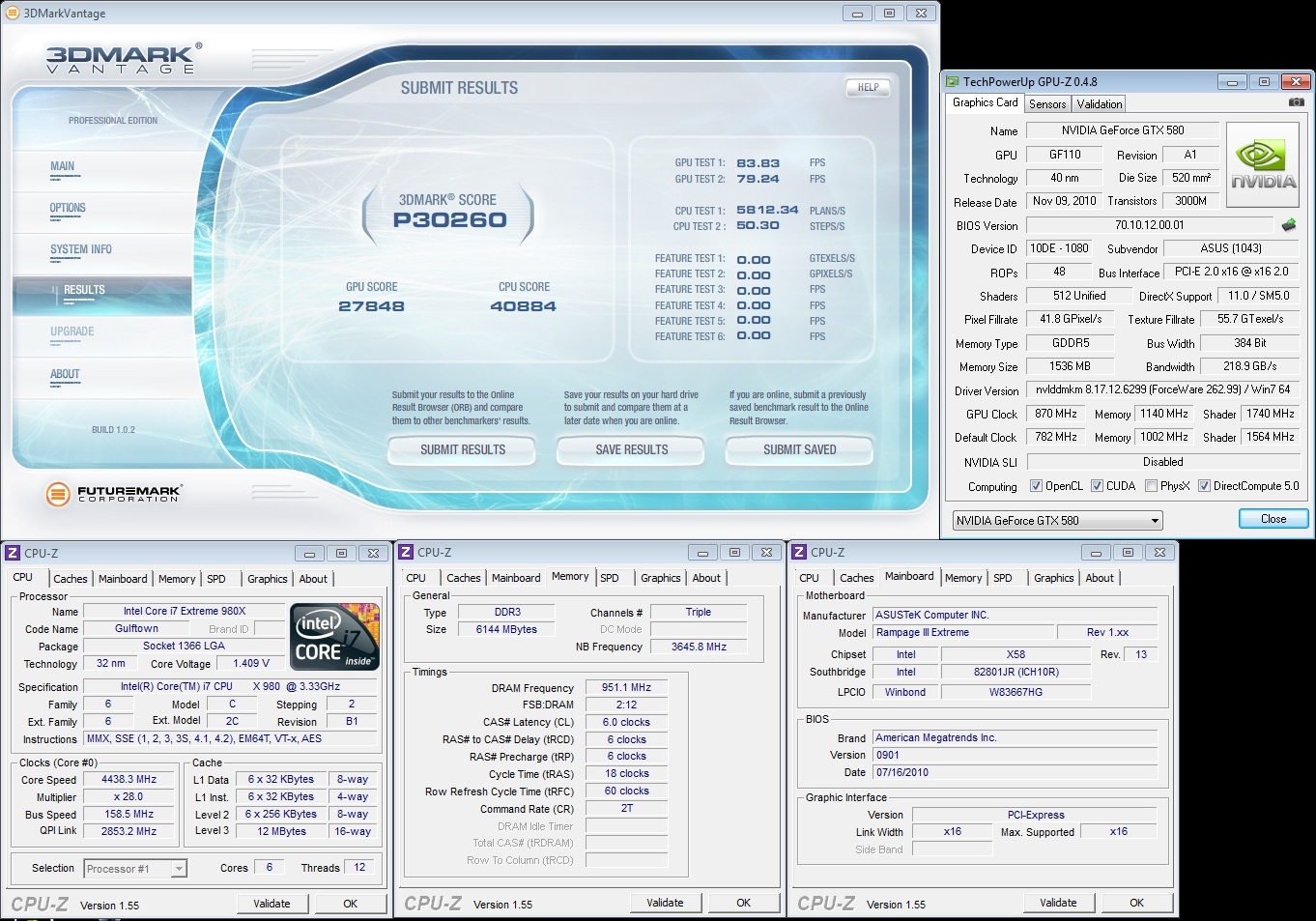

Till sist väljer vi att löpa linan så långt ut som ASUS tillåter oss, dvs lite lätt lekande med spänningar, sätter vi 1.15V uppnår vi hela 870/1140 igenom Vantage, vilket parat med CPU:n i drygt 4.4GHz (det med medföljande boxkylare, ska påpekas) ger oss 30260 poäng, vilket måste vara någon sorts världsrekord för system som kör standardkylare, och det första resultat vi ser över 30000 poäng i Vantage med ett luftkylt grafikkort.

Detta till trots är inte överklockningspotentialen direkt överväldigande på luft, precis som med GTX 480, utan du tjänar mer på att se till att din CPU inte stryper framfarten mer än nödvändigt. Att däremot ha potential att nå över 30000 poäng med ett fullt luftkylt system måste applåderas.

Näst upp är strömförbrukning och temperaturer.

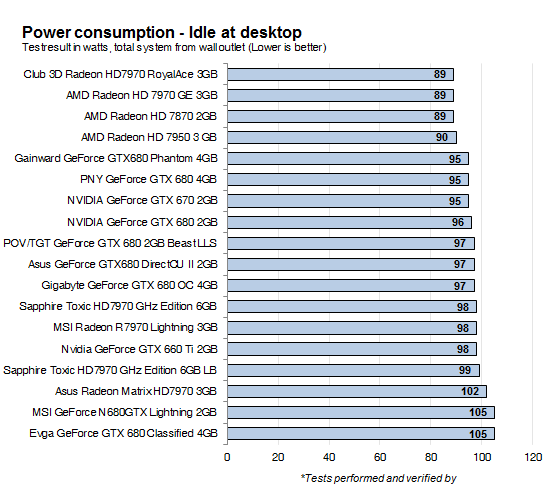

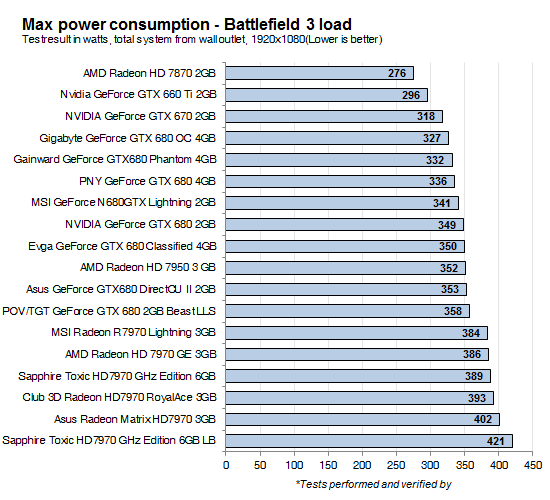

Då var det dags att ta en titt på strömförbrukningen för GTX 580 jämfört med en hel drös andra kort. Vi har som vanligt mätt systemets effekt med en något billigare wattmeter från Clas Ohlson, vilket innebär att resultaten är mer fingervisningar än absoluta sanningar. Låt oss börja med strömförbrukningen utan belastning, dvs bara vanligt stirrande på bakgrundsbilden i Windows.

Här utmärker sig GTX 580 mest genom att ge företrädaren GTX 480 rejält på nöten, med närmare 50W lägre förbrukning. Kortet är fortfarande inte i paritet med AMD:s senare lösningar, men med 8W högre förbrukning än HD 5870 känns inte som en anledning att se förbi NVIDIAs senaste alster enbart på grund av strömförbrukningen så långt. Men hur ser det ut när man visar kortet lite belastning?

Som vi tidigare nämnt har NVIDIA strypt strömförbrukningen för Kombustor, detta är tänkt att skydda grafikkretsen under den syntetiska last programmet faktiskt utgör. Kör vi Kombustor med standardinställningar landar kortet på 256W förbrukning, vilket är mindre än både 5870 och 6870 från AMD. Tar vi oss däremot friheten att kryssa i Post-FX får vi en siffra som mycket mer ser ut att stämma överens med teoretisk maxförbrukning, vilket är bortåt GTX 480-territoriet.

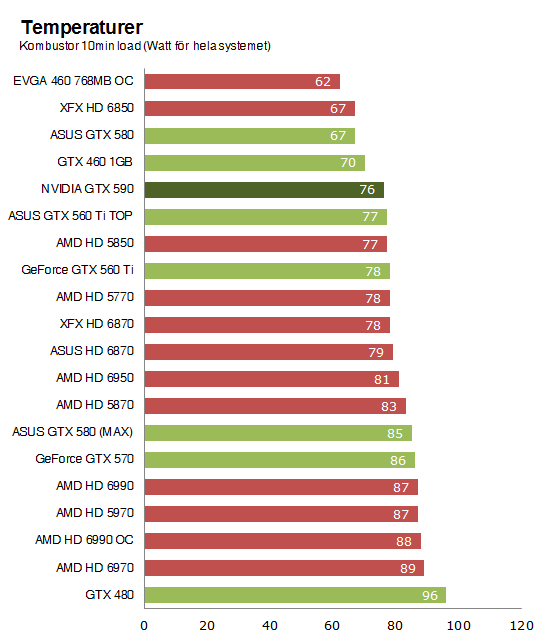

Temperaturer

Vad gäller temperaturer är historian densamma där. Kör vi GTX 580 med Kombustor i standardinställningar är kortet väldigt tyst och knappt ansträngt, vilket fick oss att kryssa i Post-FX igen, eftersom vi under våra övriga speltester sett både högre strömförbrukning och högre fläktljud, vilket vi antar måste berott på högre temperaturer.

Resultatet blir alltså att GTX 580 ser väldigt bra ut i graferna, vilket måste varit NVIDIAs mål, men petar vi som sagt på Post-FX landar det återigen på fel ände av grafen, med 85 graders temperatur på kärnan. Ska vi vara helt ärliga känns inte detta som något sätt att direkt hålla tillverkarens mjölpåsar rena, men å andra sidan har AMD liknande features i HD6000-serien, även om dessa kan stängas av i AMD Overdrive om man så önskar.

På nästa sida tänkte vi samla tankarna och plocka ihop en slutledning.

Då var vi så slutligen här mer eller mindre exakt 24 timmar efter att vi fick vår överraskning av NVIDIA, deras nya flaggskepp på grafikkortsmarknaden GeForce GTX 580. NVIDIA ville överraska alla med sin lansering av sitt senaste alster och även om vi – milt uttryckt – inte ser detta som en optimal lansering för media räknat ser det bättre ut för konsumenter. NVIDIA menar att man ville hålla sitt nya kort en hemlighet och minimera läckor, vilket betyder att man antingen ljuger eller misslyckats fatalt med. Då vi trots NVIDIA:s taktik haft fullständiga uppgifter om det nya kortet under en längre tid.

Men lanseringen av GeForce GTX 580 har gått betydligt mer smärtfritt än för GeForce GTX 480, det kan vi inte neka det gröna lägret. NVIDIA envisas med att tillbakavisa alla rykten om en ”papperslansering” och även om vi var oroliga för tillgängligheten med tanke på det snåla utbudet av testkort verkar det faktiskt finnas kort på marknaden redan från och med idag. NIVIDA talar om tusentals på den Europeiska marknaden och enligt våra uppgifter handlar det om ett 30-40 tal i Sverige de första dagarna. Hur tillgängligheten ser ut de närmaste veckorna är avgörande för hur lyckad lanseringen kan ses, men ska vi tro NVIDIA ser leveranserna friska ut.

Med sin ny GF110 GPU har NVIDIA lanserat vad vi kan kalla andra generationens Fermi-arkitektur. Man har till skillnad från AMD som satsat en hel del på tekniska lösningar – AMD HD3D, DisplayPort 1.2 och ny mediaprocessor – har NVIDIA lagt allt krut på kretsens prestation. GF110 kommer inte med några nya funktioner eller trevliga nyheter. Men kretsen är strömsnålare, svalare, smartare och inte minst snabbare än sin föregångare.

GeForce GTX 580 kan verkligen ses som NVIDIA:s brute force taktik personifierad och till skillnad mot GeForce GTX 480 har man lyckats ganska väl med utförandet denna gång. Återigen kan man se kortet på två sätt. Man kan se det som det kort GeForce GTX 480 borde varit när det lanserades för 7 månader sedan, vilket vi till viss del kan hålla med om. Eller så kan man imponeras över att NVIDIA på endast 7 månader lyckats klämma fram en krets som på alla sätt är bättre än sin föregångare och det med basta.

GeForce GTX 580 gör slarvsylta av konkurrenterna

Vi hade kunnat presentera en summering i slutledningen av artikeln med prestandatabeller och diagram. Men i ärlighetens namn finns det varken tid eller anledning till detta. GeForce GTX 580 är i en egen klass för sig. NVIDIA hade redan innan sin nylansering marknadens snabbaste singel-GPU-grafikkort och med GeForce GTX 580 utökar man den ledningen med runt 20%. AMD har ett brett och fint utbud på grafikkortsmarknaden med en ny arkitektur som på det stora hela är tekniskt bättre än Fermi. Men för dem som intresserar sig för NVIDIA:s nya flaggskepp spelar detta knappast någon större roll.

GeForce GTX 580 är ett kraftpaket utan dess like som trots riktigt imponerande prestanda även lyckats råda bot på problemen med överdriven strömförbrukning och hög ljudnivå. Vi lägger en brasklapp för NVIDIA:s övervakning av strömförbrukningen på kortet, fungerar den som den ska och inte påverkar prestandan i vanliga tester ser vi inga problem, men om den även aktiveras vid fel tillfällen kan detta ge upphov till prestandaförluster och irritation. Även den nya kylaren som NVIDIA knåpat ihop är både effektiv och riktigt tyst för att sitta på ett så pass kraftfullt grafikkort.

Ska vi försöka oss på en slutgiltig summering kan vi konstatera två saker. NVIDIA har precis höjt ribban för grafikkortsprestanda idag och om detta ligger bakom ryktena kring förseningen av AMD Cayman kan vi bara spekulera. Men för att trumfa GeForce GTX 580 i ren prestanda måste AMD dra fram ett riktigt ess ur skjortärmen.

Det andra är att man precis som vanligt får vara vänlig och betala för sig om man vill få tag på det snabbaste kortet på marknaden. NVIDIA GeForce GTX 580 kommer gå att hitta från 4 600 kronor och uppåt under veckan som går och det motsvarar i runda slängar tre stycken GeForce GTX 460 1GB kort. GeForce GTX 580 är inte tre gånger så snabbt som sitt mindre syskon, men för dem som vill få maximal prestanda idag finns det inget annat alternativ och det är verkligen inget dåligt sådant.

|

ASUS ENGTX580/2DI/1536MD5 Fördelar: Nackdelar: Pris: ~ 4 600 kronoe inklusive moms |

äkta guld 😉

Hehe ja guld i prestanda kan man utan tvivel säga. Det är inte marknadens mest kompletta kort, men gisses vad det går undan… 😛

Men 5970 är ändå på de flesta testerna på olika sidor lite snabbare än 580 och då är det 1 år gammalt och kostar 200kr mer. Detta är ett ortroligt snabbat singel gpu kort men kan ändå inte toppa amds bästa som är gammalt. Tror 6990 där kommer det hända grejjer va 🙂

Innan det kommer från någon så ser jag det så att amd bygger kort med 2 gpus medan nv bygger stora kärnor. 5970 är byggt för att konkurrera med 580 kom inte o säg något annat.

Radeon HD 5970 är precis som GTX 580 ett grafikkort och det gör dem ju givetvis till konkurrenter. Vi hade gärna tagit med kortet bland våra referenser om tiden tillåtit det, men samtidigt ska man vara tydlig med att inte alla spel stödjer SLI/CrossFire på tillfredsställande sätt. AMD ocg NVIDIA har utan tvekan olika sätt att utveckla grafikkretsar på och precis som du säger satsar AMD på mindre kretsar man kan koppla samman, medan NVIDIA satsar på stora bjässar som klarar sig bra på egen hand. Vilket som faller en i smaken är nog upp till var och en, men… Läs hela »

Tack Anton. känns skönt när det finns vettiga människor på nätet 😉

Jag tror att HD6900 seriens försening stavas GTX 580. AMD får nog öka klocken och ändra lite i arkitekturen på HD6900 serien. Blir en spännande höst/vinter helt klart! 🙂

[quote name=”Swedish Berserk”]Jag tror att HD6900 seriens försening stavas GTX 580. AMD får nog öka klocken och ändra lite i arkitekturen på HD6900 serien. Blir en spännande höst/vinter helt klart! :-)[/quote]

Det beror på, ifall november var aktuellt när det först rapporterades om november lär dom knappast ha haft tid/möjlighet att ändra någonting alls.

Kan någon bekräfta att GTX 580 fortfarande använder sig utav HDMI 1.3?

[quote name=”aov”]Kan någon bekräfta att GTX 580 fortfarande använder sig utav HDMI 1.3?[/quote]

Edit.

1.4a som stöds.

http://www.nvidia.com/object/product-geforce-gtx-580-us.html

nu är man sugen på 6970 och 6990, ska bli mycket intressant att se hur de korten presterar 🙂

Självklart skulle man haft med dagens snabbaste kort HD5970 i testet för att kunna göra en vettig jämförelse. Tycker hela testet faller lite utan den “detaljen”, man vill ju se om Nvidia når prestanda tronen med sin “Fermi done right”.

Misstänker prissänkningar är att vänta när 69xx lanseras, när det nu blir.

Förresten så saknar jag minimum fps i era test, gissar att det beror det på tidsbrist. Om så är fallet så hoppas jag att ni kunde ta er lite mera tid och göra mera utförliga tester och rapportera minimum fps också eftersom de är minst lika viktiga som medel fps, om inte viktigare. Iaf så föredrar jag kvalitet framom kvantitet, men det är ju jag det.

Detta är dock lite tråkigt. Tagit från Anandtechs recension: NVIDIA slightly revised their display controller for GF110/GTX580; the good news is that HDMI 1.4a is supported, the bad news is that full audio bitstreaming is [b]not[/b] supported so it’s the same as it was on the GTX 480: 8 channel LPCM and lossy audio formats like DD+ and DTS. This actually caught us off-guard since we were expecting the full [b]GF104 treatment here[/b], but it just goes to show that this is a GF100-derrivative after all. Unfortunately this also extends to the number of displays supported – NVIDIA still only… Läs hela »

Oj! Så mycket bättre än vad jag väntat mig. Måste skaffa ett, minst.

Men har dom rätat till tesselleringsfelet? (ojämn fördelning=lågupplösta orginalet syns kvar)

Tvivlar!

[quote name=”HeJo”]Självklart skulle man haft med dagens snabbaste kort HD5970 i testet för att kunna göra en vettig jämförelse. Tycker hela testet faller lite utan den “detaljen”, man vill ju se om Nvidia når prestanda tronen med sin “Fermi done right”.[/quote]Hade vi haft mer än 20 timmar på oss hade vi nog försökt få tag på ett HD 5970 också. Men att testet faller på att kortet inte är med kan jag inte hålla med om. Men vi ska se om vi inte kan uppdatera artikeln och databasen med lite siffror från HD 5970 också.[quote name=”gbglassen”]Oj! Så mycket bättre än… Läs hela »