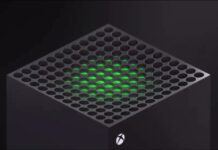

GTX 980 Ti - GM200 för konsumenter

När Nvidia lanserade Geforce GTX 780 Ti förra generationen fanns det slående likheter med dess två närliggande syskon, GTX Titan och GTX Titan Black. GTX 980 Ti fick en fullutrustad GK200-grafikkrets med fler kärnor än GTX Titan, och samma mängd CUDA-kärnor hittade sedan in i GTX Titan Black. Istället för att marknadsföra Titan-korten bara med mängden CUDA-kärnor så ringade Nvidia in den större minnesmängden och stödet för högre flyttalsprestanda med dubbelprecision.

Samma strategi fungerar inte riktigt med motsvarigheterna i Maxwell-familjen i och med att GTX Titan X inte har den extra dubbelprecisionsprestanda som dess föregångare kunde skylta med. Den funktionaliteten är istället exklusiv för de ännu mer påkostade beräknings- och renderingskorten i Quadro-familjen, så det finns inte samma utrymme för att differentiera GTX 900-serien från GTX Titan-serien som det gjorde under Kepler-eran.

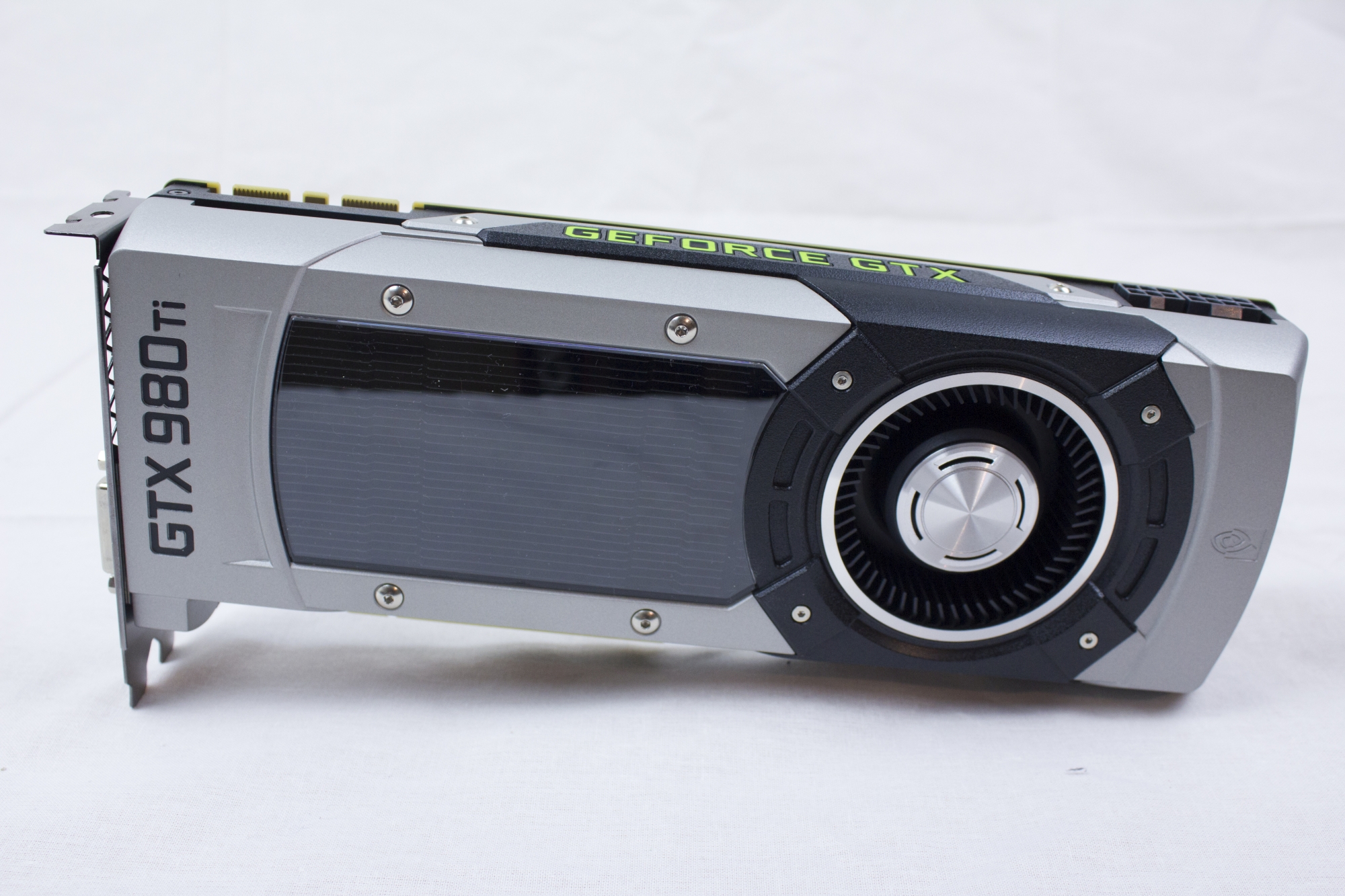

| Geforce GTX 980 | Geforce GTX 980 Ti | Geforce GTX Titan X | |

| Grafikkrets | GM204 | GM200 | GM200 |

| Tillverkningsteknik | 28 nm | 28 nm | 28 nm |

| CUDA-kärnor | 2 048 st | 2 816 st | 3 072 st |

| TMUs | 128 st | 176 st | 192 st |

| ROPs | 64 st | 88 st | 96 st |

| Klockfrekvens | 1 126 MHz | 1 000 MHz | 1 002 MHz |

| Boostfrekvens | 1 216 MHz | 1 076 MHz | 1 075 MHz |

| Minnesfrekvens | 1 750 MHz | 1 750 MHz | 1 750 MHz |

| Minnesbuss | 256-bit | 384-bit | 384-bit |

| Grafikminne | 4 GB GDDR5 | 6 GB GDDR5 | 12 GB GDDR5 |

| Bandbredd | 224 GB/s | 336 GB/s | 336 GB/s |

| TDP | 165 W | 250 W | 250 W |

| Strömanslutningar | 2 x 6-pin | 1 x 6 pin + 1 x 8 pin | 1 x 6 pin + 1 x 8 pin |

| Bildutgångar | 1 x DVI-DL, 1 x HDMI 2.0, 3 x DP 1.2 | 1 x DVI-DL, 1 x HDMI 2.0, 3 x DP 1.2 | 1 x DVI-DL, 1 x HDMI 2.0, 3 x DP 1.2 |

Istället för att släppa GTX 980 Ti som en helt upplåst GM200 har Nvidia därför gått åt andra hållet och inaktiverat två av GMM-enheterna. Det innebär att GTX 980 Ti får totalt 22 stycken för 2 816 CUDA-kärnor, ungefär 10 procent mindre än GTX Titan X. Med åtta TMU:s och fyra ROP:s per SMM-enhet blir det totalt 176 respektive 88 stycken.

Minnesmängden är halverad från de 12 gigabyte vi hittar i Titan X, men kortet har samma 384-bits minnesbuss. Så även om minnesmängden ligger närmare GTX 980 så kan vi förvänta oss en bandbredd snarare i klass med Titan X. Notera även att TDP-värdet på 250 watt är oförändrat från storebror Titan X, och klockfrekvenserna ligger i ungefär samma liga.

4K, VR och DirectX 12.1

För ett år sedan var skärmar med 4K-upplösning fortfarande något av en bristvara för konsumenter, men idag har upplösningsstandarden fått fotfäste på allvar. Det går att hitta billigare 4K-skärmar med TN-paneler för omkring 4 000 kronor, och det finns redan en uppsjö av varianter med betydligt vassare paneler som VA eller IPS som inte kostar en förmögenhet. Med andra ord är 4K på god väg att faktiskt ersätta 1080p- och 1440p-skärmar, men det som håller standarden tillbaka för speldatorer är fortfarande prestandan som krävs för att driva dem.

Enligt Nvidia är det just 4K och VR som är milstolparna man vill bocka av med GTX 980 Ti. Samma sak sades om Titan X, men det kortet var aldrig på allvar avsett för konsumenter utan snarare för utvecklare som vill arbeta på standarden i god tid innan en större utbredning bland konsumenter. GTX 980 Ti är tänkt att fylla det gapet, och enligt Nvidia är målet att kunna hålla 40 bildrutor per sekund i 4K-upplösning med ultra-inställningar aktiverade.

Vad gäller VR så krävs även där stöd för höga upplösningar – exempelvis kommer konsumentvarianten av Oculus Rift få en total upplösning på 2 160 x 1 200 pixlar. Men samtidigt behöver renderingen hålla en hög, jämn bildfrekvens så nära glasögonens uppdateringsfrekvens som möjligt för att undvika illamående, och responstiden måste hållas nere för att rörelsespårning ska fungera bra. Därför gäller det också att renderingen sker så tidseffektivt som bara möjligt.

En teknik Nvidia introducerar i samband med GTX 980 Ti är Multi-res Shading, som är tänkt att minimera mängden prestanda som går till spillo när bilden till ett VR-headset ska “warpas”. VR-glasögon som Oculus Rift använder linser för att göra ett brett synfält av bilden som skickas från datorn, och för att väga upp för förställningen från linserna behöver bilden först tryckas ihop i kanterna, eller “warpas”, för att passa den typen av lins som används. Det innebär att det renderas fler pixlar i ytterkanten av bilden än vad som faktiskt når glasögonen, i och med att information går förlorad under warpningen – därmed renderas fler pixlar än vad som faktiskt behövs, vilket är slöseri med renderingstid.

Med Multi-res Shading bryts bilden istället upp så att mittenpartiet renderas i sin ordinarie upplösing, medan ytterkanterna renderas i en lägre upplösning. Den lägre upplösningen i ytterkanterna ska sedan inte märkas av, eftersom det inte skalas bort mer information än vad som annars hade gått förlorad under warpningen. Vi fick testa tekniken under en produktdemonstration och kan ärligt säga att vi inte upplevde någon som helst skillnad i bildkvalitet – och enligt Nvida utlovas upp till en fördubbling av shader-prestandan i samband med den nedkortade renderingstiden. Innan vi kan testa de siffrorna själva får vi såklart ta de uppgifter som finns om den faktiska prestandaskillnaden med en nypa salt.

Någonting annat som Nvidia driver med sitt nya flaggskepp är fullt stöd för DirectX 12.1 och därmed alla de hårdvarufunktioner som innefattas av DirectX 12-standarden. DirectX 12 har nämligen flera lager av funktionalitet med olika stöd hos olika grafikkretsar. Det mest grundläggande är stöd för D3D 12 som för med sig bättre prestanda genom att ge utvecklare mer kontroll över grafikkretsen och minska CPU Overhead – den här funktionaliteten fungerar även på äldre grafikkretsar från både Nvidia, AMD och Intel.

Det finns dock fler lager som bara fungerar med nyare kretsar som fått stöd i hårdvaran. Det innefattar mer avancerade DX12-funktioner, som går under benämningen Feature Level 12_0, och ger stöd för mer avancerade effekter och ytterligare ökad prestanda genom att hantera grafikkortets resurser mer effektivt. Därtill finns Feature Level 12_1, sopm även kallas DirectX 12.1, som ger stöd bland annat för tekniken Conservative Raster.

Conservative Raster är i sin tur en metod som kan rendera lite mer av exempelvis en skugga än vad som annars behövs. Den extra datan kan sedan användas för ray tracing, en teknik som används för att ge mer realistiska reflektioner och skuggor. Resultatet ska vara extra skarpa skuggor utan hackiga kanter.

Fantastiskt! Dags att krossa spargrisen? Låt oss invänta AMD.

För dyrt för den lilla skillnaden, och dessutom är det bara GDDR5 som är på väg ut i kylan. Nej jag kommer iaf att vänta på Pascal. 🙂

Ja Pascal kommer att ge en ordentligt prestanda boost med du kommer få vänta närmare ett år, kanske mer? Dessutom kommer vi antagligen att få se en prislapp närmare 20k. Sitter man redan på en 4k skärm så känner man sig smått tvingat att köpa 980 TI, jag har varit på väg flera gånger att köpa Titan X men lugnat mig i väntar på 980 TI. Med tanke på hur pass “billig” 980 TI blev, om man ska jämföra med ryktena som spreds innan och jag tror att man ganska snart kommer hitta dem för under 7k eller OC varianter… Läs hela »

[quote name=”Morkul”]Ja Pascal kommer att ge en ordentligt prestanda boost med du kommer få vänta närmare ett år, kanske mer? Dessutom kommer vi antagligen att få se en prislapp närmare 20k. Sitter man redan på en 4k skärm så känner man sig smått tvingat att köpa 980 TI, jag har varit på väg flera gånger att köpa Titan X men lugnat mig i väntar på 980 TI. Med tanke på hur pass “billig” 980 TI blev, om man ska jämföra med ryktena som spreds innan och jag tror att man ganska snart kommer hitta dem för under 7k eller OC… Läs hela »

Jag tror att priset kommer justeras när Fiji kommer, beroende på hur det kortet presterar, vad det kommer kosta samt tillgängligheten. Just som det är nu så har nvidia ingen konkurrens och kan sätta vilket pris som helst.

Håller med ovanstående att det var tur att den inte landade på 9K.

7500 kr är ett betydligt mer övertygande pris.

Siffrorna i NHW’s benchmarks gör att det blir svårt att övertyga sej själv om ett Titan X om man nu inte nödvändigtvis tror att Titan X råprestanda balanserar sej bra mot 12 GB, i framtidens spel.

[quote name=”Skuggan777″]

Jag köper nog lilla Pascal-kretsen som jag inte tror går på över 6.5k vid lanseringen, 20k låter som att inte många skulle lägga ner på ett kort så det skulle nog bli väldigt nischat isåfall.[/quote]

Precis som högprestanda korten kostar idag kommer också högprestanda korten kosta om ett år plus lite extra vid lansering om nu nVidia tror att de kan klara av att sälja kortet. 6.5k är ju bara löjligt att tro… men den som lever få se.

Måste ha NU jag skiter i om Pascal kommer om ett år med svindlande prestanda, fan om ett år kan man ju va död.

Fattar inte riktigt. NVIDIA 980ti och Titan X räcker ju i de flesta fall inte till att hålla spelen över 60 fps i UHD. Dom är ju oxå svindyra att köpa.

Saknar Radeon 295×2 i prestandaindex. Det är nog det enda kortet som är med i testet som verkar klara UHD med hygglig framerate. Dessutom det billigaste av de tre korten

Radeon R9 295X2 visar var skåpet ska stå

[quote name=”MoNsTeR”]Radeon R9 295X2 visar var skåpet ska stå[/quote]

295X2 är ju en dual GPU lösning så då kan du lika bra köpa två GTX 970 och köra SLI och få samma prestanda men pengar över ;). Dock så ser det ut som att det knappt får att få tak på 295X2 längre.

Dock så återstår fortfarande problem med 4k upplösningar då minnesbandbredden blir flaskhals.