GK110 med superdatorgener

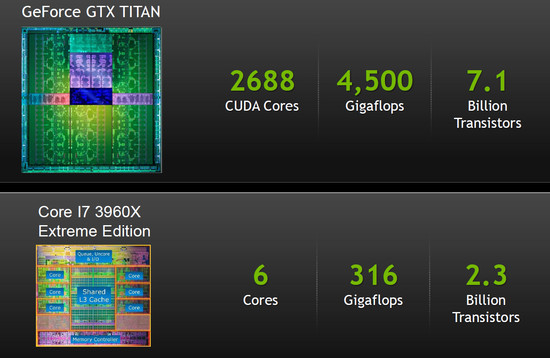

Grafikkislet som Nvidia tillverkar med 28 nanometerteknik är en närmast obscent stor krets som har en kretsyta på 551 kvadratmillimeter. Räknar vi in alla transistorer Nvidia tryckt in i GK110 hamnar siffran på 7,1 miljarder, vilket får marknadens kraftfullaste x86-processor, Intel Core i7-3970X, att se ut som en liten pojkspoling. Intels sexkärniga processor har totalt 2,27 miljarder transistorer och en kretsyta på 435 kvadratmillimeter med en mindre effektiv 32 nanometerteknik.

| Grafikkort | Teknik | Kärna | Transistorer | Storlek | Shaders | Texturenh. | ROP:s | Minnesbuss |

| GTX Titan | 28nm | GK110 | 7 100 milj. | 551 mm² | 2 688 | 224 | 48 | 384-bit |

| GTX 680 | 28nm | GK104 | 3 540 milj. | 294 mm² | 1 536 | 128 | 32 | 256-bit |

| GTX 580 | 40nm | GF110 | 3 000 milj. | 529 mm² | 512 | 64 | 48 | 384-bit |

| GTX 560 Ti | 40nm | GF114 | 1 950 milj. | 360 mm² | 384 | 64 | 32 | 256-bit |

| GTX 550 Ti | 40nm | GF116 | 1 170 milj. | 238 mm² | 192 | 32 | 24 | 192-bit |

| HD 7970 | 28nm | Tahiti XT | 4 310 milj. | 365 mm² | 2 048 | 128 | 32 | 384-bit |

| HD 7870 | 28nm | Pitcairn | 2 800 milj. | 212 mm² | 1 280 | 80 | 32 | 256-bit |

| HD 7770 | 28nm | Cape Verde | 1 500 milj. | 123 mm² | 640 | 40 | 16 | 128-bit |

| HD 6970 | 40nm | Cayman | 2 640 milj. | 389 mm² | 1 536 | 96 | 32 | 256-bit |

| HD 5870 | 40nm | Cypress | 2 150 milj | 334 mm² | 1 600 | 80 | 32 | 256-bit |

| HD 6870 | 40nm | Barts | 1 700 milj. | 255 mm² | 1 120 | 56 | 32 | 256-bit |

| HD 6770 |

40nm | Juniper | 1 040 milj. | 166 mm² | 800 | 40 | 16 | 128-bit |

| HD 4770 | 40nm | RV740 | 826 milj. | 137 mm² | 640 | 32 | 16 | 128-bit |

| HD 4890 | 55nm | RV790 | 959 milj. | 282 mm² | 800 | 40 | 16 | 256-bit |

| HD 4870 | 55nm | RV770 | 956 milj. | 260 mm² | 800 | 40 | 16 | 256-bit |

| HD 3870 | 55nm | RV670 | 666 milj. | 192 mm² | 320 | 32 | 16 | 256-bit |

| HD 2900 XT | 80nm | R600 | 720 milj. | 420 mm² | 320 | 32 | 16 | 512-bit |

GK110 har totalt 2 880 Cuda-kärnar men när Nvidia nu bygger ett konsumentgrafikkort av sin grafikkrets är det endast 14 av kretsens totalt 15 SMX-enheter som är aktiverade. Dessa innehåller vardera 192 Cuda-kärnor och ger Geforce GTX Titan 2 668 Cuda-kärnor att leka med. En ökning med hela 75 procent från lillebror Geforce GTX 680 och grafikkretsen GK104 med sina 1 536 Cuda-kärnor.

Själva Keplers grundarkitektur med flertalet SMX-kluster är densamma som i GK104 och Geforce GTX 680 varför vi rekommenderar er att läsa vår tidigare genomgång av Kepler och GK104 ifall ni vill få mer information om hur själva grafikkortsarkitekturen fungerar.

GK110 har samtidigt vissa större skillnader där vi förutom en massiv ökning i beräkningsenheter även får en välkommet utökad minnesbuss, från 256-bit i GK104 till 384-bit i GK110. Minnesbandbredden är en begränsning i Geforce GTX 680, särskilt vid högre upplösningar. Även om man nu ökar bandbredden med runt 50 procent kommer GK110 med ännu större ökning i beräkningskraft varför det fortfarande finns potential för flaskhalsar i minnesbandbredd.

Inte helt oväntat hittar vi flera likheter med GF110, Nvidias kraftfullaste grafikkrets baserad på Fermi-arkitekturen. Vi har en massiv ökning i antal beräkningsenheter, men detta beror till stor del på den nya SMX-grundarkitekturen. Men antalet ROP:s och minnesbussen är snarlik. Samt kretsarnas storlek som på en bra bit över 500 kvadratmillimeter får övriga grafikkretsar i historien att se ganska ynkliga ut.

AMD har beklagat sig över att GK110 är en grafikkrets inte utvecklad för grafikkort och spel. Något man kan dividera fram och tillbaka om. Vi kan ge det röda lägret till viss del rät om vi ser till kretsens komplexitet och transistorantal som gör den både svår och dyr att tillverka. Samt att Nvidia kanske lagt onödigt stort fokus på beräkningskraft, vilket är bättre lämpat för just GPU-beräkningar i superdatorer och arbetsstationer där GK110 mycket riktigt gjorde debut förra året. Men som ni kommer att se i våra tester är detta en GPU som kan tackla även de mest tungdrivna spel med bravur.

Maximera dubbel precisions-prestanda med GTX Titan

Vill man kan man däremot ställa om grafikkortet till “compute”-läge. Där GPGPU-applikationer som drar nytta av dubbel precisions uträkningar kan maximera sin prestanda. Geforce GTX Titan är det första konsumentkortet med maximal dubbel precisions prestanda, något som görs möjligt tack vare 64 double-precision Cuda-kärnor i varje SMX-kluster kan erbjuda rejält mycket högre beräkningskraft än exempelvis GTX 680 som endast har 8 double-precision Cuda-kärnor per SMX-kluster.

DP-kärnorna körs däremot i lägre frekvens direkt ur kartongen, detta för att 3D-prestandan påverkas negativt om de kör på i full hastighet. Men genom en enkel inställning i Nvidias kontrollpanel kan man slå över till full hastighet på DP-kärnorna vilket ska ge högre GPGPU-beräkningskraft men tyvärr även lägre 3D-prestanda då grafikkretsen arbetar vid lägre frekvenser.

GPGPU-applikationer för konsumenter

Vi har under våra tester med Geforce GTX Titan försökt hitta bra och intressanta applikationer för att testa GPGPU-prestandan i en konsumentmiljö. Tyvärr har detta visat sig vara svårare än vi hade hoppats där vi snarast kunnat konstatera att applikationer antingen inte stödjer GPU-acceleration eller endast stödjer Opencl för AMD eller Cuda för Nvidia.

Vi kommer att fortsätta undersöka nyttan och prestandan med GPGPU-applikationer men som det ser ut idag finns det oerhört få applikationer för vanliga konsumenter som drar nytta av din grafikkrets beräkningskraft. Videoomkodning och lösenordsknäckning är vanligt förekommande GPGPU-applikationer men samtidigt inget vi ser som vanligt använt av konsumenter.

Nvidia har däremot en viss fördel med sitt breda stöd för Cuda och vi kan exempelvis nämna Adobe Premier Pro CS6 som endast stödjer GPU-accelerering med Cuda-baserade grafikkort, AMD-stöd för Opencl finns endast på Mac i dagsläget.

Vi hade tänkt testa den teoretiska GPGPU-prestandan med Luxmark 2.0 och Handbrake. Tyvärr visade det sig att Luxmark kraschade varje gång vi startade applikationen med GTX Titan. Handbrake i sin tur stödjer endast OpenCL för AMD-kort, det går att få hjälp av grafikprocessorns videomotor men prestandan är närmast identisk mellan olika kort i samma generation, vilket tydligt syns i våra tester.

Tills vi hittar vettiga applikationer som både är intressanta för er användare och går att nyttja i jämförande syfte fortsätter vi att se grafikkort som primärt ämnade för 3D-spel och fokuserar också på dessa tester i första hand.

Tur att inköp på korten är 6200:- exkl.moms då 😆

Inte mycket handlarna tjänar ändå säls ju för 8500:- så blygsamma 600:-.

Kanske borde plocka några på firman.

Tycker inte grafikkortet är värt en så hög prislapp, för så överlägset var inte kortet ett 7970 GHz. Det var väl ett par spel som den drog ifrån lite. Om jag skulle köpa ett nytt grafikkort så skulle det nog bli ett AMD kort

Såg inga 660 och 7870 som ni testade

[quote name=”Viking1962″]Tycker inte grafikkortet är värt en så hög prislapp, för så överlägset var inte kortet ett 7970 GHz. Det var väl ett par spel som den drog ifrån lite. Om jag skulle köpa ett nytt grafikkort så skulle det nog bli ett AMD kort[/quote]Värde är ju till viss del personligt. Jag personligen skulle inte lägga 9k på ett grafikkort. Det kan förvisso vara för att jag inte behöver eller för den delen skulle ha råd. Men faktum kvarstår att det för mig inte är värt det. Men för någon annan kan jag förstå att kortet är värt det. Det… Läs hela »

[quote name=”Viking1962″]Tycker inte grafikkortet är värt en så hög prislapp, för så överlägset var inte kortet ett 7970 GHz. Det var väl ett par spel som den drog ifrån lite. Om jag skulle köpa ett nytt grafikkort så skulle det nog bli ett AMD kort[/quote] Öhh, jo mellan 20-40fps beroende av spel så detä r väldigt mycket bättre.Stor skillnad eftersom du i många lägen hamnar över 60fps tack vare detta brutala monster. Sen är inte kortet riktat till folk med mindre pengar utan för dom som vill ha det bäst och struntar i vad det kostar samt vill slippa microstuttering/SLI… Läs hela »

[quote name=”Fidde_gbg”]Öhh, jo mellan 20-40fps beroende av spel så detä r väldigt mycket bättre.Stor skillnad eftersom du i många lägen hamnar över 60fps tack vare detta brutala monster. Sen är inte kortet riktat till folk med mindre pengar utan för dom som vill ha det bäst och struntar i vad det kostar samt vill slippa microstuttering/SLI profiler osv.[/quote] Ser man till lite andra tester där till som exempel skiljer över 10 minuters renderings tid så är detta kortet extremt prisvärt. På företaget har vi inväntat detta kort lite och nu ser det ut som att vi kommer köpa några stycken… Läs hela »

[quote name=”Anton Karmehed”][quote name=”Viking1962″]Tycker inte grafikkortet är värt en så hög prislapp, för så överlägset var inte kortet ett 7970 GHz. Det var väl ett par spel som den drog ifrån lite. Om jag skulle köpa ett nytt grafikkort så skulle det nog bli ett AMD kort[/quote]Värde är ju till viss del personligt. Jag personligen skulle inte lägga 9k på ett grafikkort. Det kan förvisso vara för att jag inte behöver eller för den delen skulle ha råd. Men faktum kvarstår att det för mig inte är värt det. Men för någon annan kan jag förstå att kortet är värt… Läs hela »

Som Quadro kort lär det vara magiskt 😥

Vad tror ni, om att detta kort skulle fungera bra för att folda med?

[quote name=”Viking1962″][quote name=”Anton Karmehed”][quote name=”Viking1962″]Tycker inte grafikkortet är värt en så hög prislapp, för så överlägset var inte kortet ett 7970 GHz. Det var väl ett par spel som den drog ifrån lite. Om jag skulle köpa ett nytt grafikkort så skulle det nog bli ett AMD kort[/quote]Värde är ju till viss del personligt. Jag personligen skulle inte lägga 9k på ett grafikkort. Det kan förvisso vara för att jag inte behöver eller för den delen skulle ha råd. Men faktum kvarstår att det för mig inte är värt det. Men för någon annan kan jag förstå att kortet är… Läs hela »

Jag vill se Titan mot Ares 2 i testet dock. Tror att AMD och Asus plockar hem vinsten med det kortet även i cf mot Titan i sli.

Det hade vart väldigt trevligt att se vad kortet kan göra för renderingstiden i Blender. Har ingen koll på hurvida vray, maya osv har för stöd för CUDA, men Blender har det 😉