Vi har skrivit över 1 petabyte (1 000 terabyte) data till våra testenheter och vi har ännu inte sett några SMART-fel. Men nu har vi lämnat dem utan ström i över två månader och ytterligare en TLC-baserad SSD har gått vidare till de sälla jaktmarkerna.

OBS! Testet är avslutat och uppdateras inte mer.

När vi sist lämnade våra två kvarvarande SSD-enheter från Samsung så hade båda enheterna skrivit 1000 terabyte med data. Då bestämde vi oss för att göra ett enklare test för att se hur bra enheterna kan hålla kvar den data vi lagrat på dem. Vi lagrade 75 gigabyte med blandade filer och gjorde sedan en MD5-hash (en matematisk “summa”, eller fingeravtryck, av innehållet som är unik för specifikt det innehållet) om varje fil. Vi gömde sedan enheterna i en låda på kontoret för att sedan plocka fram dem två månader senare. Vi har nu plockat fram enheterna och försökte verifiera hashen för alla filerna.

OBS! Testet är avslutat och uppdateras inte mer.

Anledningen till att vi gjorde detta är för att se huruvida enheterna kan hålla data under så lång tid, trots det enorma slitaget som vi utsatt dem för. Om någon eller några filer har förändrats när enheterna har lämnats oinkopplade så kommer MD5-hashen inte vara samma som vid urkopplingen. Vi har nu åter monterat våra testenheter i testsystemet och försökt verifiera så att hashen, och därmed alla filer, är intakta. Är så fallet?

Samsung 850 Evo biter i gräset

Det korta svaret på frågan är: nej. Efter uppstart av systemet så gick båda enheterna igång utan problem och det gick bra att bläddra runt bland filerna. För säkerhets skull tittade vi återigen på enheternas SMART-data via Samsungs Magician-programvara, och allting såg bra ut. Men när vi satte igång att verifiera filerna på den första enheten så började det genast dyka upp fel. Ungefär 1 procent av filerna som kontrollerades hade inte samma hash-värde som när datan sparades för två månader sedan. Det betyder att filen på ett eller annat sätt är skadad.

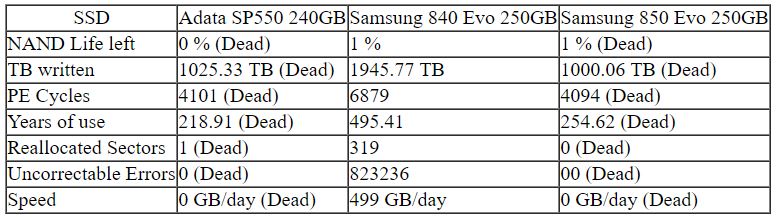

Till en början så tuggade enheten igenom alla filerna och gav fel på vissa. Men när vi hade kommit till 38 procent så gick det betydligt långsammare att verifiera hashen för varje fil. Att komma från 38 procent till 42 procent tog nästan 6 dygn och under tiden så började även SMART att visa fel. Åtskilliga läs- och skrivfel återspeglades och till slut så verkade det som om vårt testsystem hade hängt sig helt och hållet. Efter en omstart så hittades inte en av enheterna av systemet längre. Tyvärr så gjorde detta att vi inte lyckades läsa ut någon mer SMART-data innan enheten dog.

Märkligt nog så var det inte den enhet som vi trodde skulle dö först (Samsung 840 Evo) som gav upp, utan Samsungs V-NAND-baserade 850 Evo. Samsung har sagt att 850 Evo ska ha ungefär 2 000 skrivningar till varje minnescell och 840 Evo ska bara ha 1 000. Båda våra enheter har klarat betydligt mer än så (båda är på ungefär 4 000 nu) men vi trodde nog ändå att 850 Evo skulle dra det längsta strået. Sedan ska vi också komma ihåg att Samsungs V-NAND-teknik är förhållandevis ny och det kan vara stora skillnader från enhet till enhet. Det här betyder alltså inte att 850 Evo håller sämre än 840 Evo. Det betyder bara att vår 840 Evo klarade sig längre än vår 850 Evo gjorde. Det kan skilja väldigt mycket från enhet till enhet.

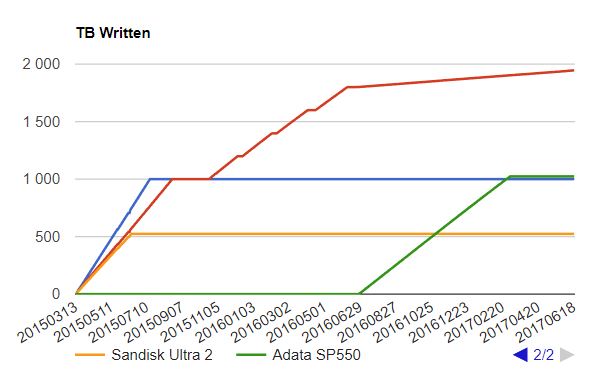

Obs! Testet är avslutat. I bilden saknas även beskrivning för Samsung 840 Evo (röd) och Samsung 850 Evo (blå)

Vad som är lite bekymrande är att det fanns återigen inga indikationer på att något var fel. Inga fel rapporterades av SMART förrän det mer eller mindre var för sent. Vi började se SMART-fel när vi försökte verifiera hashen men innan det så såg vi inga fel alls. Man ska dock komma ihåg att vi skriver/läser väldigt mycket data under kort tid och därför borde man få lite tidigare varning än vad vi fått här.

Detta betyder att vi numera bara har en enhet kvar, nämligen Samsung 840 Evo som nu återigen skriver data för allt vad cellerna har att ge. Vi har också bestämt oss för att göra ett sådant här hash-test lite oftare. Så från och med nu så kommer vi att stoppa testet efter 100 terabyte och sedan lämna enheten utan ström i en vecka och sedan kontrollera hashen igen.

Så vad tror ni? Hur långt kommer 840 Evo att klara sig?

testa med deras rekommenderade annars slår testet helt fel.

när ni skrivit så mycket så vore det konstigt ifall det funkade helt felfritt.

skriv något under rekommenderat, stäng av i 2 månader etc..

där ett mer realistiskt användare scenario. även om det går att diskutera med.

En annan intressant aspekt i detta är väl just alla filer man [i]inte[/i] ändrar på? Antar att dom flesta inte skriver om disken mer än att nytt gränssnitt dödar disken före den slutar fungera.

Det intressanta är alla bilder och dokument som man skriver en och annan gång och sedan blir liggandes till det finns anledning att använda dom.

Så frågan är: Blir filerna även förstörda för att dom är “bortglömda” även om disken används frekvent? Har sett fenomenet på hårddiskar där filer inte har rörts på flera år men disken har använts var och var annan dag.

[quote name=”flopper”]testa med deras rekommenderade annars slår testet helt fel.

när ni skrivit så mycket så vore det konstigt ifall det funkade helt felfritt.

skriv något under rekommenderat, stäng av i 2 månader etc..

där ett mer realistiskt användare scenario. även om det går att diskutera med.[/quote]

Det här testet är tänkt att vara extremt och 840 Evo fungerar ju fortfarande.

men det ska bli intressant att se vad som händer.

[quote name=”Sebbe”]En annan intressant aspekt i detta är väl just alla filer man [i]inte[/i] ändrar på? Antar att dom flesta inte skriver om disken mer än att nytt gränssnitt dödar disken före den slutar fungera. Det intressanta är alla bilder och dokument som man skriver en och annan gång och sedan blir liggandes till det finns anledning att använda dom. Så frågan är: Blir filerna även förstörda för att dom är “bortglömda” även om disken används frekvent? Har sett fenomenet på hårddiskar där filer inte har rörts på flera år men disken har använts var och var annan dag.[/quote] Så… Läs hela »

Det mest oroväckande med detta test är att SMART verkar helt värdelöst.

Har ni hittat några andra saker man kan göra eller förlita sig på i sin vardag som ger en indikation på när SSDn är på väg att ge upp?

[quote name=”Sebbe”]En annan intressant aspekt i detta är väl just alla filer man [i]inte[/i] ändrar på? Antar att dom flesta inte skriver om disken mer än att nytt gränssnitt dödar disken före den slutar fungera. Det intressanta är alla bilder och dokument som man skriver en och annan gång och sedan blir liggandes till det finns anledning att använda dom. Så frågan är: Blir filerna även förstörda för att dom är “bortglömda” även om disken används frekvent? Har sett fenomenet på hårddiskar där filer inte har rörts på flera år men disken har använts var och var annan dag.[/quote] Det… Läs hela »

[quote name=”xemacs”]Det mest oroväckande med detta test är att SMART verkar helt värdelöst. Har ni hittat några andra saker man kan göra eller förlita sig på i sin vardag som ger en indikation på när SSDn är på väg att ge upp?[/quote] Jag håller med. Det känns som om SMART inte rapporterar fel när man kör RAW. Vilket skulle vara helt sjukt eftersom SMART kommer från enheten firmware och ska inte bry sig om filsystem eller liknande. Inför testet av den sista SSD-enheten så skapade jag en VHDX-disk som ligger på en formaterad NTFS volym. Så om så är fallet… Läs hela »

[quote name=”ondjultomte1″]Det är anledningen till att man kör med ett filsystem som klarar av att hantera sådana fel. ZFS tex, med redundans.[/quote] Hur är det med btrfs som är journalförande eller är det i princip samma sak? Jämför man med RAID så går det ändå inte att garantera om det är original, disk två i RAID 1 eller pariteten i RAID 5/6 som är “rätt svar”. Så vad skulle man egentligen ha backup på, eller är tre eller fler udda diskar i en RAID 1 säkrare då minst två kan ge samma svar? (Vi bortser från backuper av andra orsaker… Läs hela »