G-Sync är som det mesta Nvidia utvecklar en proprietär teknik. Ett extra smärtsamt faktum när jag efter en knapp timmes bekantskap inser att jag precis sett framtiden. Inte bara för datorspel och skärmar utan kanske även för TV-apparater, mobiltelefoner och surfplattor.

Nvidias överraskande tillkännagivande av kombinerade GPU- och skärmtekniken G-Sync förra veckan gav eko inom spelcommunityn. De första mediarapporterna var smått lyriska och Nvidia bjöd på en kavalkad av sprudlande glädjecitat från alla de stora namnen inom spelutvecklingsvärlden.

När Nvidias inbjudan damp ner i inkorgen 23.30 i onsdags kväll satt jag och slet med recensionen av huvudkonkurrentens nya flaggskepp Radeon R9 290X. Inte direkt optimal tajming att ta beslut på en snabbvisit till London två dagar senare. Men trots ett pressat schema och härligt kort varsel övervägde jag alternativen och beslutade mig tidigt dagen efter för att faktiskt ta chansen. Hypen hade blivit för stor och om det var någon teknik man borde se live innan man uttalar sig om densamma var det G-Sync.

Nu står jag här vid en laddstation på Heathrow och väntar på ett försenat flyg hem till Köpenhamn och en efterlängtad helg. Just nu är det däremot tankarna kring G-sync som far runt i skallen och behöver komma ut på pränt eller åtminstone i text.

Det är inte omöjligt att vi i ett senare skede publicerar en mer detaljerad teknikartikel men hela poängen med G-Sync handlar om din personliga upplevelse när du spelar. I detta fallet väljer jag därför att fokusera på min egen upplevelse snarare än tekniken i sig, även om vi nog gör bäst i att börja i den tekniska änden.

Problemen med alla digitala skärmar

Problemet med datorspel och digitala skärmar är att våra datorer och grafikkort skickar ut ett varierande antal bildrutor varje sekund (fps) medan våra skärmar målar upp bildrutorna efter en fast uppdateringsfrekvens varje sekund (hertz).

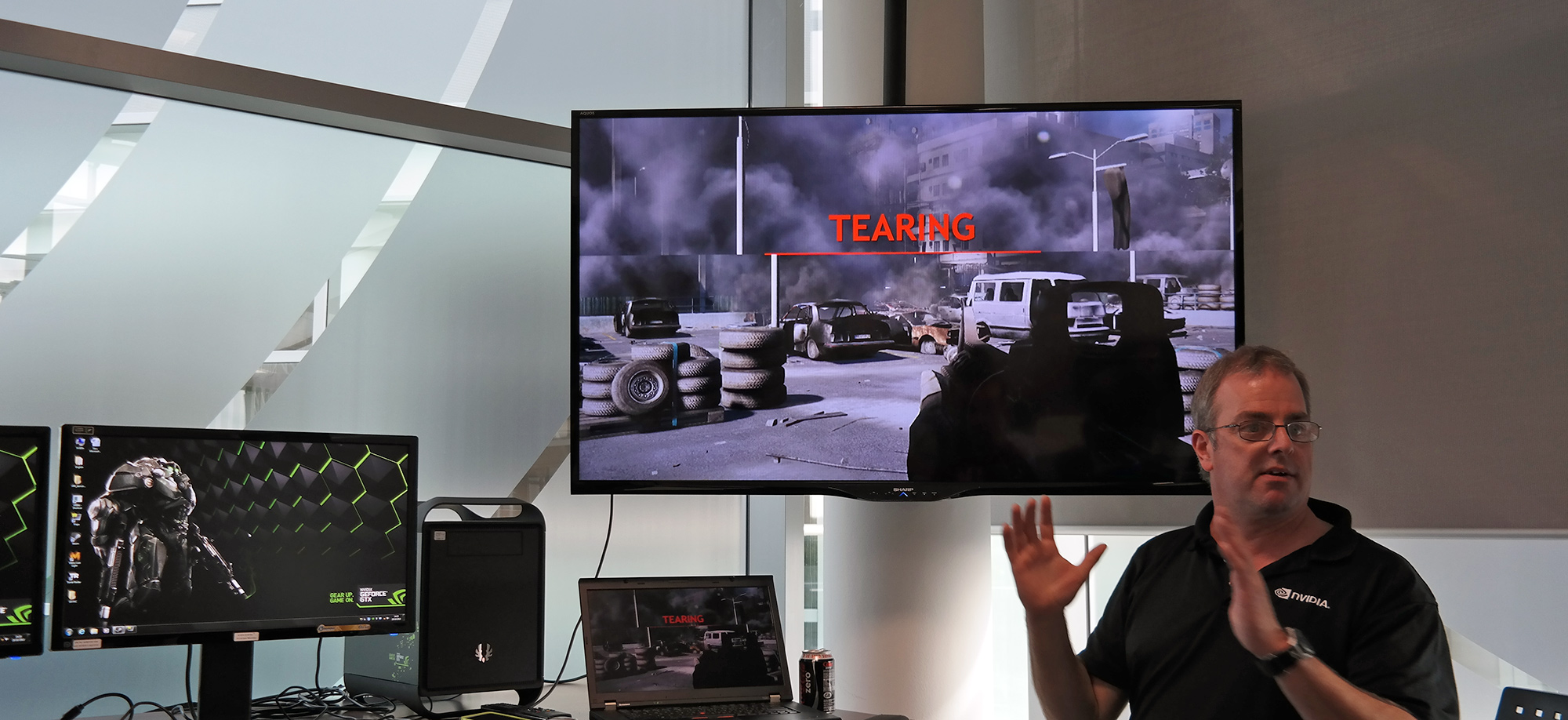

En skärm med 60 hertz uppdateringsfrekvens målar upp en ny bild på sin panel med ett fast intervall på 16 millisekunder, varje bildruta målas fram uppifrån och ner. För att ge en perfekt och följsam spelupplevelse krävs det att grafikkortet levererar minst 1 bildruta var 16:e millisekund så att varje ny bild skärmen målar upp stämmer överens med de bildrutor grafikkortet levererar. Detta är ett scenario som egentligen aldrig uppstår då grafikkortet oftast antingen levererar för få eller för många bildrutor per sekund. Detta ger så kallad ”tearing” där en uppmålad bild på skärmen i själva verket kan bestå av två eller flera separata bildrutor som matas in av grafikkortet och kraftigt stör spelinlevelsen.

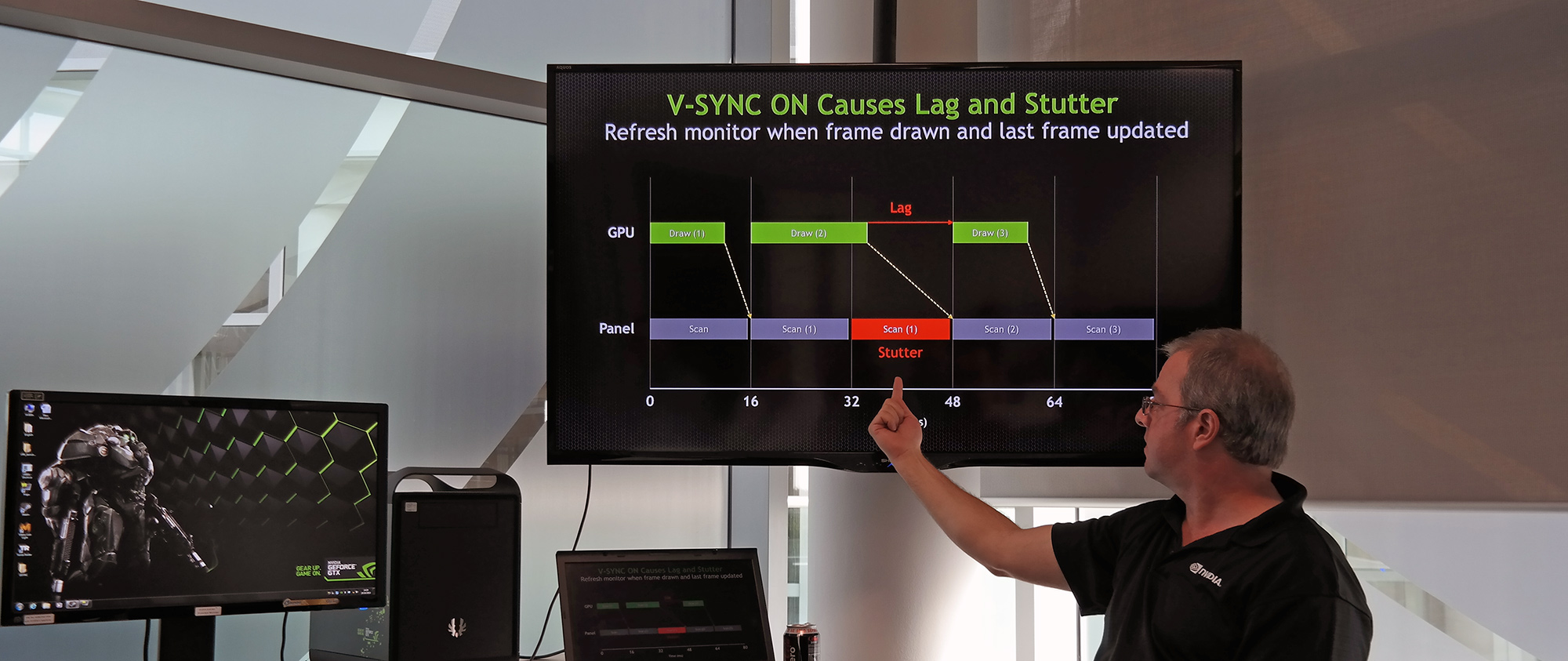

Med tekniken V-Sync låser man leveransen av bildrutor från grafikkortet till skärmens uppdateringsfrekvens. Detta stoppar i stort problemen med tearing men skapar istället problem med lagg och stutter när ditt grafikkort inte hinner rendera en bildruta var 16 millisekund, det som behövs för att matcha skärmens uppdateringsfrekvens.

Lösningen – Grafikkortet i förarsätet

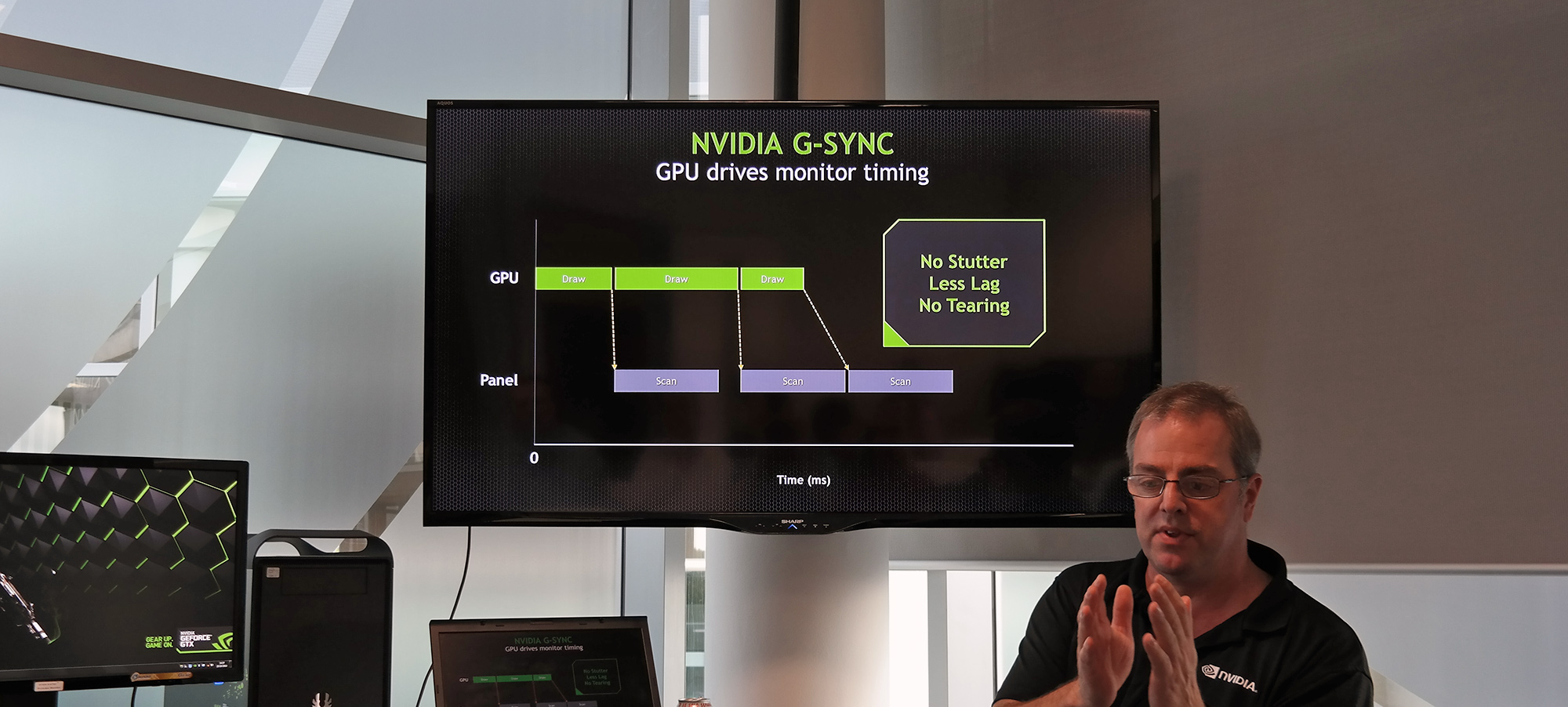

Detta är fenomen och problem som funnits i alla tider och som nu Nvidia säger sig ha löst med G-Sync. En teknik som kort och gott sätter grafikkretsen i förarsätet och placerar skärmen på passagerarplats. Dit grafikkortet kör följer skärmen efter.

I tekniska termer betyder det att skärmens uppdateringsfrekvens styrs helt av grafikkortets renderingsfrekvens. Skärmen uppdateras varje gång en ny bildruta skickas från grafikkortet och vi får på detta sätt en perfekt synkronisering mellan grafikkort och skärm som följd av en variabel uppdateringsfrekvens.

Resultatet blir ett flyt och en spelinlevelse som varken jag, eller någon annan för den delen upplevt tidigare.

Välformulerat Anton!

V-sync är inget bra alternativ idag, och med det off inte heller optimalt.

Det känns ju fantastisk men om vi nu köper nya monitorer till våren kommer det nya till hösten med A-Sync? (AMD 🙂 inge bra upplägg för framgång.

Här kommer dock en person som verkligen gillar och förstår G-Sync John Carmack och förklarar mer än Nvidia vill att han ska göra.

http://www.youtube.com/watch?v=gbW9IwVGpX8

MVH

/Janne

[quote name=”3D-Blaster”]Välformulerat Anton!V-sync är inget bra alternativ idag, och med det off inte heller optimalt.Det känns ju fantastisk men om vi nu köper nya monitorer till våren kommer det nya till hösten med A-Sync? (AMD 🙂 inge bra upplägg för framgång.Här kommer dock en person som verkligen gillar och förstår G-Sync John Carmack och förklarar mer än Nvidia vill att han ska göra. http://www.youtube.com/watch?v=gbW9IwVGpX8MVH/Janne[/quote]Tack Janne! Det är ju det som är kruxet idag, jag är supertaggad på tekniken med synkroniserad uppdateringsfrekvens. Men sättet den måste implementeras med G-Sync och att det inte funkar med alla produkter överallt gör mig lite… Läs hela »

Jag är inte lika övertygad, ännu bättre är det ifall grafikkortet klarar av att hålla skärmens uppdateringsfrekvens, då klockar jag hellre grafikkortet 30% och slår på Vsync.

[quote name=”adolf512″]Jag är inte lika övertygad, ännu bättre är det ifall grafikkortet klarar av att hålla skärmens uppdateringsfrekvens, då klockar jag hellre grafikkortet 30% och slår på Vsync.[/quote]

På vilket sätt skulle det bli bättre Adolf? Då skulle du behöva hitta grafikinställningar som gör att en frame aldrig renderas långsammare än på 16ms. Vilket skulle tvinga dig att göra avkall på mycket fina grafikinställningar. Vsync är i praktiken inte en i närheten lika bra lösning som synkroniserade uppdateringsfrekvenser.

Med G-Sync eller motsvarande kan du ju fortfarande överklocka grafikkortet? 🙂

Läste igenom artikeln lite snabbt men hittar ingentstans om det krävs en speciell bildskärm för detta eller lirar det bra med valfri skärm?

Intressant teknik dock. Skulle gärna se det i verkligheten då det är svårt att se det bra på film. Även om jag tycker mig se lite skillnad iaf.

[quote name=”Blaxxor”]Läste igenom artikeln lite snabbt men hittar ingentstans om det krävs en speciell bildskärm för detta eller lirar det bra med valfri skärm? Intressant teknik dock. Skulle gärna se det i verkligheten då det är svårt att se det bra på film. Även om jag tycker mig se lite skillnad iaf.[/quote]Det finns lite mer teknisk info i nyhetsartikeln som är länkad i slutet på krönikan. hade tyvärr redan skrivit nästan för mycket för att kunna gå in på tekniska detaljer i denna artikeln också.https://www.nordichardware.se/Grafik/nvidia-g-sync-tar-kontroll-oever-din-skaerm-foer-optimal-spelupplevelse.html Men kort och gott ser det ut såhär. G-Sync kräver följande:[list][*]Geforce GTX 650 Ti Boost… Läs hela »

Hur stora problem har folk med tearing med mera? För mig har problemet varit så obefintligt att jag knappt vet vad det är. Visst har det laggat när grafikinställningarna jag haft varit för höga, men jag kanske har för dåliga grejer och brukar dessutom alltid vrida ner inställningarna för att få det att flyta.

Anton vet du om man även kunde använda G-sync till video uppspelning?

30fps?

pratar vi konsol spel eller?

Kanske Nvidia behöver kraftigare grafikkort för bättre spel värde?

så skärmen kostar mer, lär vara bunden till Nvidia kort och kräver ett grafikkort i 1000krs klassen för att utnyttjas för att märka skillnad.

Orsaken som han säger är att med svagare kort så kan tekniken påvisas ha fördelar då det märks där.

3D, PhysX, G-sync etc..vad är nästa pryl?

[quote name=”3D-Blaster”]Anton vet du om man även kunde använda G-sync till video uppspelning?[/quote]Ja det ska fungera även där och Nvidia påpekade att flera TV-tillverkare är intresserade just för streaming och spel där man ofta har variabla frame rates. Men även Blu-ray och annat videomaterial kan dra nytta av detta med en TV som har synkroniserad uppdateringsfrekvens, vilket hade varit awesome. 🙂 [quote name=”flopper”]30fps?pratar vi konsol spel eller?Kanske Nvidia behöver kraftigare grafikkort för bättre spel värde?så skärmen kostar mer, lär vara bunden till Nvidia kort och kräver ett grafikkort i 1000krs klassen för att utnyttjas för att märka skillnad.Orsaken som han… Läs hela »

[quote name=”Anton Karmehed”].

I min värld finns det inte på kartan att vi inte får se motsvarande lösningar överallt i framtiden, jag hoppas bara inte det blir ett jäkla mekk med olika standarder osv.[/quote]

SOm jag sade i artikeln om G-Sync så gillar jag hela iden men den kommer att bli föråldrad väldigt fort.

Kommande OLED och diverse varianter av OLED kommer med sådan hög uppdaterings frekvens (I teorin en efresh rate på upp till 100 000 Hz) lägg där till att dynamisk refrech ticker styrs ifrån källan. Källan kan alltså vara ett grafikkort, BR-spelare, etc etc..

[quote name=”Morkul”][quote name=”Anton Karmehed”].I min värld finns det inte på kartan att vi inte får se motsvarande lösningar överallt i framtiden, jag hoppas bara inte det blir ett jäkla mekk med olika standarder osv.[/quote] SOm jag sade i artikeln om G-Sync så gillar jag hela iden men den kommer att bli föråldrad väldigt fort. Kommande OLED och diverse varianter av OLED kommer med sådan hög uppdaterings frekvens (I teorin en efresh rate på upp till 100 000 Hz) lägg där till att dynamisk refrech ticker styrs ifrån källan. Källan kan alltså vara ett grafikkort, BR-spelare, etc etc..[/quote] Jag tror du… Läs hela »

Det här känns ju så sjukt självklart som du säger. Varför skulle man inte synka så att skärmen levererar en hel bild direkt det finns en hel bild. Jag tänker mer på vad det kan göra för energisparande. Om grafikkretsen bara levererar bilder när bilden förändras, behöver inte skärmen heller uppdateras förrän då. Det innebär ju att om man läser en text exempelvis kanske varken skärmen eller grafikkortet behöver uppdatera på flera minuter vilket borde spara en del ström. Det går mot att datorer blir mer dynamiska, alltså att strömförbrukningen är linjärt beroende vad den egentligen behöver göra, istället för… Läs hela »

[quote name=”Morkul”]

Kommande OLED och diverse varianter av OLED kommer med sådan hög uppdaterings frekvens (I teorin en efresh rate på upp till 100 000 Hz) [/quote]

Intressant, det skulle ju eliminera behovet av denna teknik. Med nuvarande teknik ser jag dock G-sync som enda vettiga möjligheten att ta del av 4K-upplösning i krävande spel på ett smärtfritt sätt nu när grafikkortsutvecklingen har börjat bromsa in. Att slippa både tearing och delay blir en win-win.

Bra artikel Anton!

Jag fattar precis vad du menar med känslan av “flyt” och spelupplevelse som överglänser det vi har nu. Jag har alltid varit irriterad på tearing och stutter/mikrostutter, vilket gjort att jag konsekvent dragit ner grafikinställningarna för att aldrig komma under 16 ms. Trots det, stör jag mig fortfarande på ojämna animationer…

Kudos till Nvidia som satsar på att förbättra spelupplevelsen och inte bara jagar fps.

Men….

Risken är ju betydande att man ju gör som vanligt och att det blir ett nytt PsysX och låser in användaren till Nvidiakort, men det är väl iofs tanken 😕

[quote name=”Morkul”][quote name=”Anton Karmehed”].I min värld finns det inte på kartan att vi inte får se motsvarande lösningar överallt i framtiden, jag hoppas bara inte det blir ett jäkla mekk med olika standarder osv.[/quote] SOm jag sade i artikeln om G-Sync så gillar jag hela iden men den kommer att bli föråldrad väldigt fort. Kommande OLED och diverse varianter av OLED kommer med sådan hög uppdaterings frekvens (I teorin en efresh rate på upp till 100 000 Hz) lägg där till att dynamisk refrech ticker styrs ifrån källan. Källan kan alltså vara ett grafikkort, BR-spelare, etc etc..[/quote]Jag ska rota bland… Läs hela »

[quote name=”Anton Karmehed”]Jag ska rota bland inspelningarna från pressmötet men jag vet att OLED kom på tal och att G-Sync skulle fungera även där. Hur stor effekt och fördel man får av det är väl svårare att säga ännu men det ska ju bli jäkligt intressant att se. :)[/quote] Det skulle vara kul att läsa om. Speciellt eftersom oled redan har en teknik som är extremt lik G-Sync plus den extrema uppdateringsfrekvensen gör att G-Sunc borde inte spela någon roll. Ska vara lösningar med dubbla grafikkort då men även där har jag svårt att se större nytta. Men som sagt… Läs hela »

http://www.youtube.com/watch?v=GtYqG7Xl-SU

V-Sync förklaring och allt det andra 😉

Yay, bara att köpa nya skärmar för 4-5k styck och hoppas på att det slår igenom och blir en standard.

Det som är mer intressant för mig är, hur bra eller mycket bättre är detta än att ha en rigg som klarar av 60+ FPS eller t.om. 120+ FPS stabilt, märker man någon skillnad?

En annan intressant grej är väl musrörelser i spel i förhållande till FPS, i vissa spel blir det segt som sirap när FPS går ner.

alltså det med med fps o vsync och tearing….jag kör tex battlefield och upplever tearing vid stora variationer av fps och stutter vid för låg fps eller åtminstonde vid en kraftig snabb dipp i fps.men jag har alltid gjort så att jag cappar maxf-fps:en och försöker bibehålla en fps som matchar skärmens uppdateringsfrekvens. med en ganska kraftig dator så kör jag nu allt på high i bf3 och går aldrig under 100fps och heller aldrig över = aldrig någon tearing, allt flyter nått gränslöst! kan tillochmed tillåta mig själv att köra allt på ultra och få dippar nedåt 90 (hilltop… Läs hela »