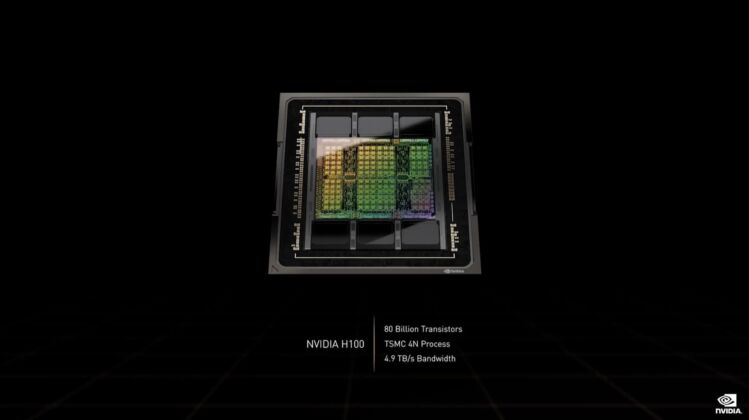

Nvidia har nu avtäckt sin senaste arkitektur Hopper och först ut blir beräkningskortet H100 med 80 miljarder transistorer, över 16 000 CUDA-kärnor och 80 gigabyte HBM3-minne.

Nvidia H100 har avtäckts officiellt och Nvidia överraskade något genom att inte basera enheten och den nya grafikprocessorn på TSMC:s tillverkningsprocess på fem nanometer. Istället använder man sig av en specialdesignad teknik på fyra nanometer. Detta är dock inte allt som är nytt med beräkningskortet.

H100 kommer att erbjuda en monolitisk design och inte en MCM-design (Multi-Chip Modul) som tidigare trott. Denna gigantiska pjäs innehåller 80 miljarder transistorer och 16 896 FP32 CUDA-kärnor. I alla fall hos SXM-varianten. Den PCI Express 5.0-baserade insticksmodellen erbjuder 14 592 kärnor. En fullt upplåst GH100-grafikprocessor erbjuder 144 streammultiprocessorer för massiva 18 432 CUDA-kärnor.

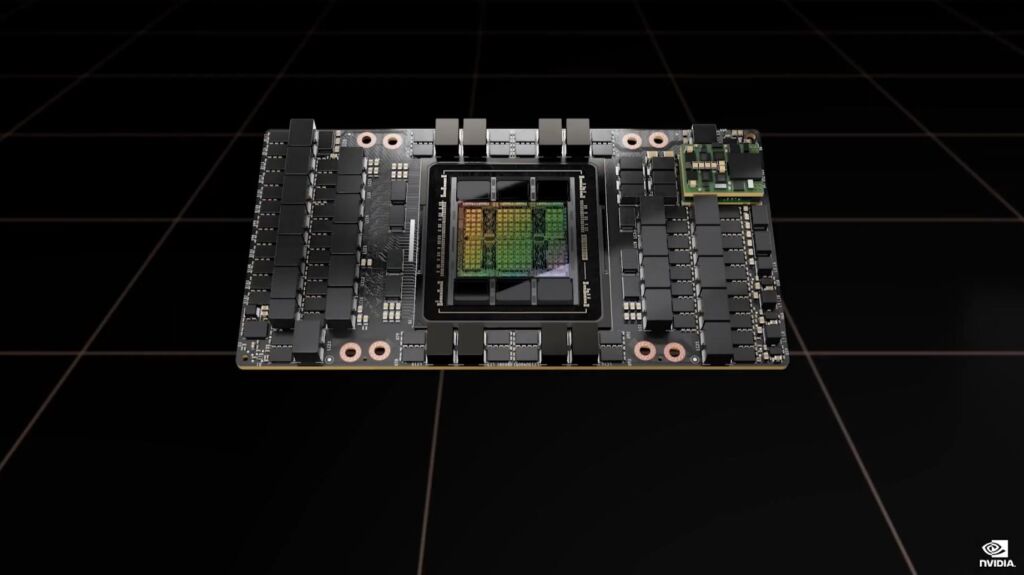

Nvidia H100 kommer ett erbjuda 80 gigabyte minne i form av HBM3. Här ska bandbredden ligga på tre terabyte per sekund. Omkring en och en halv gång högre än minnesbandbredden hos föregångaren A100. Denna specifikation gäller dock även den för SXM-modellen. Den PCIe-baserade varianten av H100 utrustas istället med HBM2e-minne med en bandbredd på två terabyte per sekund.

TDP-värdet är också något som skiljer sig mellan de två varianterna av Nvidia H100. SXM-varianten kommer med ett TDP-värde på massiva 700 W medans PCIe-varianten har begränsats till 350 W.

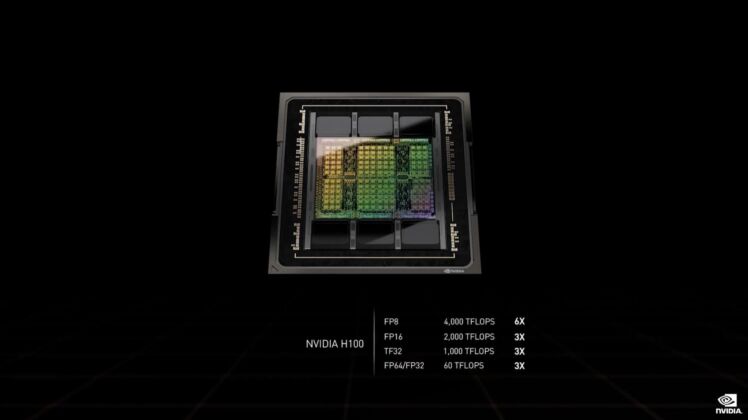

Sett till prestanda hävdar Nvidia att H100 erbjuder tre gånger så hög beräkningskraft i FP64, TF32 och FP16 jämfört med A100. I FP8 ska det röra sig om sex gånger prestandan hos föregångaren.