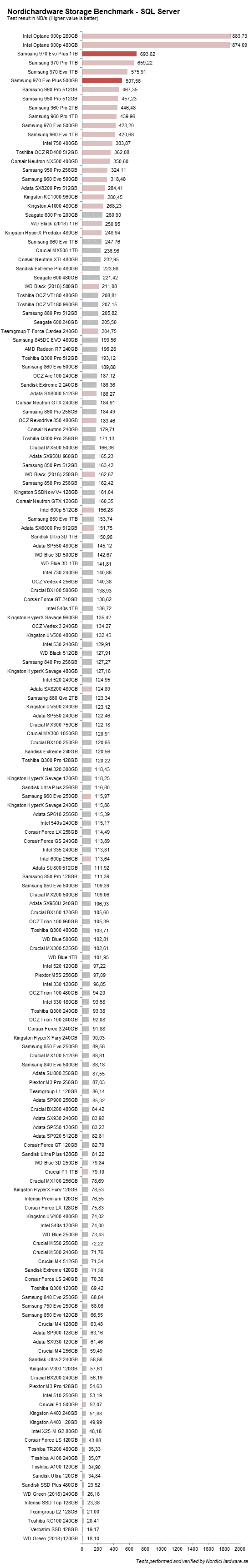

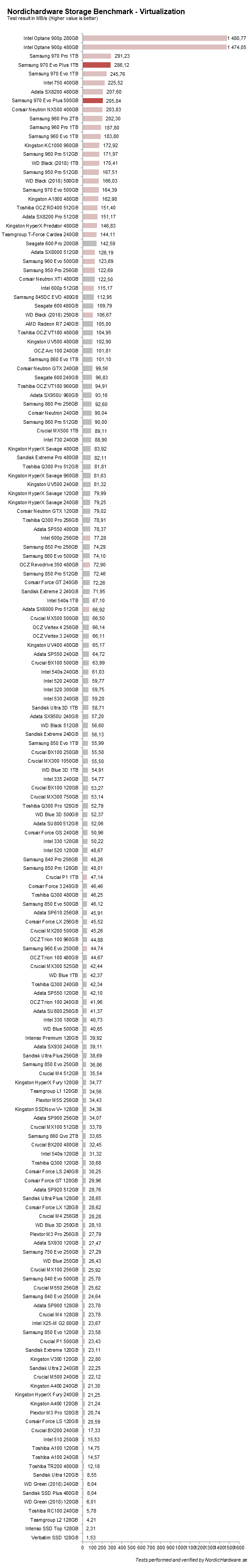

Testresultat: NHSB Virtualization & SQL Server

Dessa tester är baserade på den typ av belastning som man stöter på i en arbetsstation eller server. De är således designade för att fokusera på långvarig och intensiv belastning. Enheter som har mer overprovisioning, och andra enheter som har sina rötter på servermarknaden, får därför en lite extra fördel. Förutom att dessa tester är större och tyngre än de andra, körs de också på en disk som redans fyllts med data precis innan. Det ger också en viss indikation på hur snabb en SSD är när den är full jämfört med om den är helt tom.

Traditionella konsument-SSD-enheter är designade att ge bra prestanda under kortare perioder. I de här testerna brukar dessa enheter falla långt ner i listan. Ju mer en enhet är beroende av SLC-cachen, desto sämre presterar får den i dessa tester. Samsungs nya 970-enheter har inte det problemet och levererar grym prestanda. Den är givetvis inte ens i närheten av Intels Optane 900 men den är ändå i klass med 970 Pro, vilket är imponerande.

Det är inget snack om 970 Evo Plus är snabba enheter, även under tung belastning. Samsungs implementering av SLC-cache är nog den bästa på marknaden i dagsläget. Det är en starkt bidragande orsak till varför enheterna är så snabba. Vi ser att att Virtualization-testet är lite tyngre och det beror nog på högre QD.

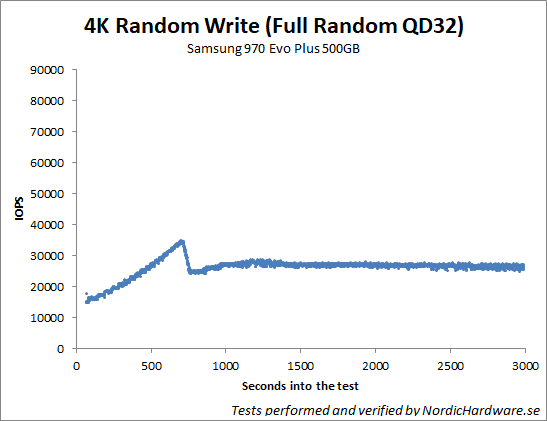

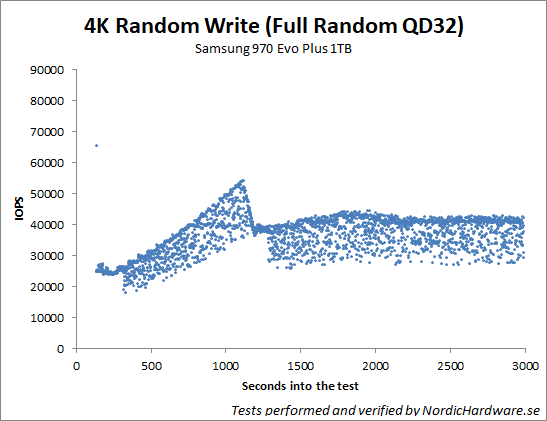

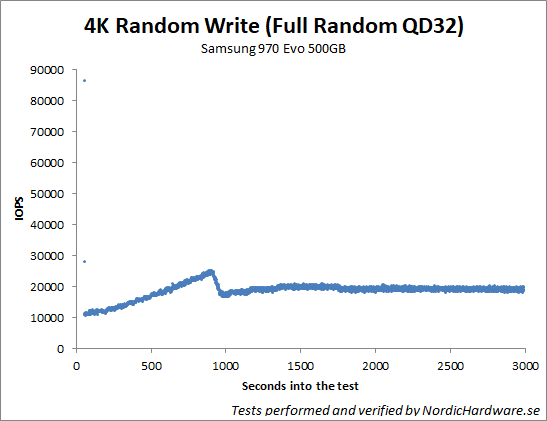

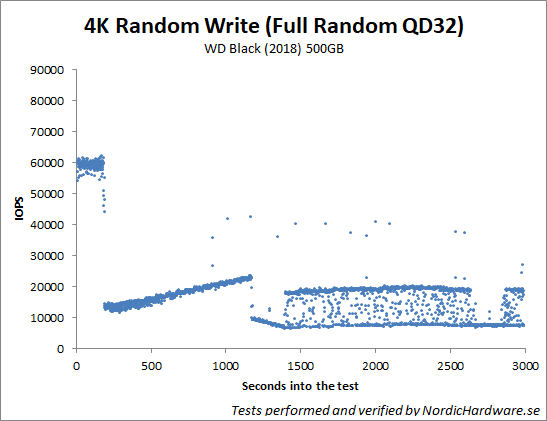

Här gör vi ett slumpmässigt skrivtestet på enheten för att se hur lång tid det tar att sätta enheten i steady-state och sedan se hur konsekvent prestandan är när enheten når dit. Vi vill se alla prickar hopklumpade så att de bildar en linje.

Samsungs mönster är väldigt olikt andras. Konkurrenterna har hög prestanda i början tills SLC-cache är slut. Därefter tappar den rejält i prestanda för att sedan försöka återhämta sig igen. Samsungs 970-enheter jobbar annorlunda och här öka prestandan vartefter. När Samsungs enheten är i steady-state är de på en betydligt högre nivå än andra enheter. Det är också intressant att se hur olika 1000 GB- och 500 GB-modellerna är från varandra.

Riktigt bra test som vanligt! Har ett par frågor. Varför ser IOPS resultaten med fullskrivning så olika ut för 500 och 1000gb-modellen? 500gb modellen har en fin stadig IOPS medan 1000gb modellen är överallt? Och på Robocopy testerna hur menar ni med när ni tar och gör en kopia på Large och mediumtesterna? Hur går det till och hur får ni ut resultaten från dessa?

Hej och tack för dina frågor. Jag är osäker på vilken graf du menar. Jag antar att du menar den graf som visar prestanda i steady-state. Det är faktiskt inte helt klart varför det skiljer så mycket. Det logiska hade varit att kurvan skulle vara densamma men att 1000GB har högre medel. Det skulle kunna vara värme som stökar till det eftersom 1000GB har en betydligt högre prestanda generellt och det sätter högre press på kontrollern. Det kan också vara delvis på grund av SLC-cachen dom ibland beter sig lite konstigt med syntetiska tester. Vi såg precis samma sak med… Läs hela »