Testresultat: Städteknik och TRIM

Att lagra data på en SSD har många fördelar, men även nackdelar. SSDns grundfunktion gör att enhetens prestanda kommer att minska med tiden och beroende på hur mycket data du lagrar på den. För att enheten inte ska bli helt oanvändbar efter något år, så används flera olika tekniker för att enheten ska “städa” sig själv och hålla prestandan på topp. Man kallar detta för “Garbadge collection”.

Under hösten så har vi på NordicHardware arbetat med ett nytt test för våra SSD recensioner. Tidigare så har vi inte haft något bra sätt att mäta hur bra en SSD är på att städa sig själv, eller hur bra TRIM fungerar. Då det inte är praktiskt möjligt att testa användandet av en SSD under lång tid, så fick vi försöka hitta en annan lösning. Vi gjorde helt enkelt ett eget test som simulerar tung långstidsanvändning. För den som vill läsa mer om hur TRIM fungerar så finns det en rejäl genomgång att hitta i en av våra tidigare SSD-jämförelser.

Vår idé var att göra ett antal sekventiella skriv-operationer över hela enheten. Vid varje test mäts skrivhastigheten 200 gånger på olika ställen över enhetens lagringsyta. Från dessa resultat tar vi sedan fram ett minsta värde, ett maxvärde och ett medelvärde. Från det kan man få fram hur enhetens städteknik fungerar och hur bra den fungerar.

Först kör vi en så kallad Secure Erase på varje enhet. Det betyder att alla minneschip rensas helt och hållet från aktiv och nerskräpad data. Enheten presterar då som när den var ny från fabrik. Sedan kör vi Test nummer 1. Test 1 ger oss ett referensvärde som vi mäter övriga resultat emot. De värden som vi ser i första testet är de bästa möjliga värden som enheten kan väntas ge. Därefter fyller vi hela enheten så mycket som det bara går med slumpmässig data som inte kan komprimeras. Sedan torteras enheten under 40 minuter med slumpmässiga skrivningar på 4K vid QD32. Detta sätter enorm press på enheten, då den redan är full med data. Samtidigt så måste den stuva om informationen för att hitta lediga platser att skriva till. Detta försätter enheten i ett slags värstafallsscenario. Den här typen av bealstning utsätts SSD-enheter nästan aldrig för under normala förhållanden.

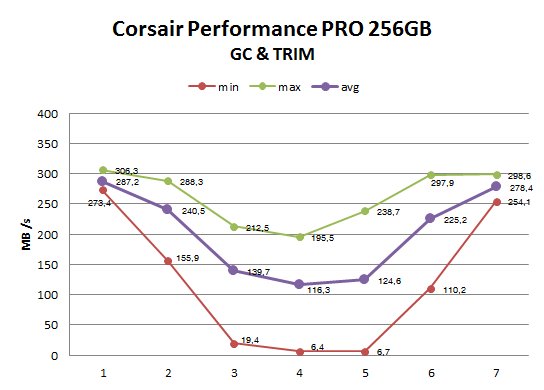

Sedan kör vi Test 2. Test 2 visar enhetens och prestandan i ett värstafallsscenario, och är betydligt sämre än innan. Vad som händer sedan är det som kommer vara intressant. Under Test 3, 4 och 5 körs vår sekventiella skrivning över hela disken, tre gånger efter varandra. Efter det så ligger enheten i viloläge i 20 minuter för att sedan köra Test 6. Till sist så körs en TRIM på enheten och sedan körs Test 7. Om TRIM fungerar som det ska så ska enhetens prestanda vara ungefär densamma som vid Test 1. Men ska vi vara realistiska kommer den nog inte återställa sig helt.

Då detta test är nytt förr oss, så har vi tyvärr inte haft chansen att testa det på alla SSD-enheter som tidigare funnits i testlabbet. Så vi valde ut att testa det på en av huvudkonkurrenterna som finns tillgänglig, Corsair Performance Pro. Delvis för att det just är en stor konkurrent till Intel SSD 520, men framförallt för att den hanterar Garbage Collection på ett helt annat sätt än SandForce.

Metodiken i testet är följande:

- Secure Erase

- Test 1

- Fyll enheten med okomprimerbar data

- Kör IOMeter som tortyrtest i 40 minuter

- Test 2

- Test 3

- Test 4

- Test 5

- 20 minuter vila

- Test 6

- Formatera hela enheten (aktiverar TRIM)

- 10 minuter vila

- Test 7

När det gäller Performance PRO så ser vi tydligt att Corsair valt att använda en passiv form av Garbage Collect. När enheten fyllts så blir prestandan bara sämre och sämre för varje test som går (Test 2 – 5). Men när den får ligga och vila i 20 minuter så återhämtar den sig (mellan Test 5 och 6) ganska bra. För att sedan återvända till nästan full prestanda efter TRIM (Test 7).

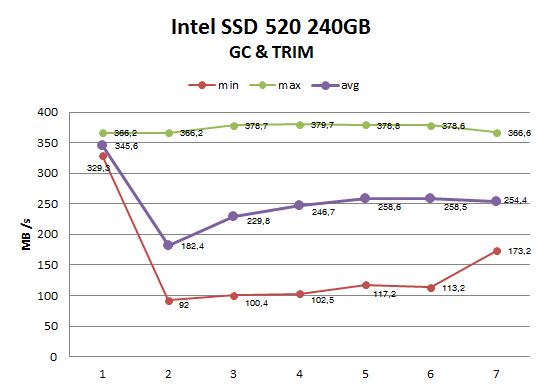

Om vi istället tittar på Intel SSD 520 240 GB så ser vi en helt annan bild. Efter Test 2 så ökar prestandan för varje test som körs. Det betyder att enheten städar sig själv samtidigt som den skriver ny data. Det skulle förklara den stora skillnaden mellan minimum- och max-värde. När enheten skriver så kommer den ibland behöva avsätta en del av prestandan till att skyffla data “internt” och då ser vi en betydligt lägre skrivhastighet.

Samtidigt så finns det ställen när enheten skriver i full hastighet. Vi ser inte heller någon ökning av prestanda mellan Test 5 och 6. Det betyder att när systemet är i viloläge, så gör inte SSD-enheten något annorlunda än när den arbetar. Tillslut så ser vi att en TRIM inte helt återställer prestandan till dess ursprung som vi såg vid Test 1. Det är lite oroväckande att en TRIM inte återställer prestandan. Vi gjorde detta test på vår Corsair Force GT och precis som här så gjorde inte TRIM så stor nytta. Vi har inte utfört samma test på Intel SSD 520 180 GB, kurvan i diagrammet bör vara identiskt med den storebror på 240 GB får.

Detta är något som SandForce har haft problem med tidigare. När enheten väl hamnat i ett läge med lägre prestanda så vill den inte riktigt återfå sin fulla prestanda oavsett vad man gör. Nu har vi inte testat så pass mycket för att dra några direkta slutsatser, men en sak är klar. Detta är ett fenomen som troligtvis ingen kommer att se då detta inte kommer kunna hända vid vardaglig användning och normala förhållanden. Om det skulle ske är man tvingad att göra en Secure Erase på enheten för att få prestandan tillbaka på ursprungliga nivåer.

Jag tycker Intel gör helt rätt som ger en solid garanti till skillnad mot många konkurrenter. Tyvärr är det ju så att priserna behöver sjunka något för att man ska kunna slå sig in på allvar bland retailköparna i min mening, 120GB modellen ligger bättre till i pris men prestandan på denna enheten är lite osäker, bör ju vara V3 klass men svårt att säga helt säkert. Sen tycker jag det ska bli spännande att se hur Intel väljer att göra med sin egen kontrollerdesign. Är alla tredjepartskontrollers bara en mellanlandning innan en ny stor kontrollerlansering från Intel själva, eller… Läs hela »

Jag tror tyvärr att Intel nästan givit upp sin egen kontroller design. Det känns lite så. Hade de varit dedikerade till att utveckla sina egna kretsar så hade vi nog hört eller sett någon form av antydan till ny enhet. Eventuellt gör de gör en enterprise-kontroller för Sata 6,0 Gbps där det finns mer pengar.

Samsung enheten verkar ha en mer jämn prestanda genom alla tester, priset är dessutom inte speciellt högt heller. Intel kommer helt enkelt alldeles för sent med den här enheten. Stabilitet är inte ett tillräckligt stort argument i dagsläget då det finns marvell enheter som visat sig vara stabila och samsung har också visat sig vara stabila (830 serien behöver nog lite mer tid på sig för att bevisa detta). Sänker de ner priserna så kan jag tänka mig att de kan bli riktigt attraktiva, men hade dock velat se 120GB modellen i testet..

Jag är skeptisk när ni skriver att extrahering av rar-filer hänger mycket på CPU-hastighet och minnesbandbredd. Under normala omständigheter är det alltid disk som begränsar extrahering, särskilt som majoriteten av alla rarade ISO-filer man hittar på nätet dessutom helt saknar kompression. När jag läste artikeln under gårdagen kunde jag bara tänka en sak. Skriv era artiklar i ett program med grammatik- och stavningskontroll samt korrekturläs innan ni publicerar. Det såg riktigt illa ut. Inte en sida var fri från stavfel, typos, särsskrivningar, grammatiska fel och blandad stavning mellan engelska och svenska. Förhoppningsvis är en del av det redan fixat sen… Läs hela »

[quote name=”Snigeln”]Jag är skeptisk när ni skriver att extrahering av rar-filer hänger mycket på CPU-hastighet och minnesbandbredd. Under normala omständigheter är det alltid disk som begränsar extrahering, särskilt som majoriteten av alla rarade ISO-filer man hittar på nätet dessutom helt saknar kompression. När jag läste artikeln under gårdagen kunde jag bara tänka en sak. Skriv era artiklar i ett program med grammatik- och stavningskontroll samt korrekturläs innan ni publicerar. Det såg riktigt illa ut. Inte en sida var fri från stavfel, typos, särsskrivningar, grammatiska fel och blandad stavning mellan engelska och svenska. Förhoppningsvis är en del av det redan fixat… Läs hela »

Ser lovande ut.

Hoppas dock som vanligt på att även få se en jämförelse med den bland normala konsumenter betydligt vanligare storleken 120Gb då prestandan oftast skiljer sig ganska markant från 240Gb modellerna. Men jag antar att företagen bara vill visa upp sin bäst presterande enhet som valigt tyvärr…

Tyvärr är det mer regel än undantag att tillverkarna skickar 240GB modellerna när det gäller SSD-tester. Det kan tom vara väldigt svårt att överhuvudtaget få tag på 120GB modellerna från tillverkarna själva och ibland har vi fått låna SSD-enheter från butiker exempelvis för att kunna göra testerna kompletta, då vi precis som de flesta konsumenter ser att 120GB enheterna är prismässigt mest intressanta.

Samtidigt måste jag erkänna att 120GB inte räcker för mina egna behov, dock är det i min mening fortfarande för dyrt med 240GB modellerna men alla har ju olika budget. 🙂 Hoppas på rejäla prissänkningar/GB framöver.

[quote name=”Anton Karmehed”]Samtidigt måste jag erkänna att 120GB inte räcker för mina egna behov, dock är det i min mening fortfarande för dyrt med 240GB modellerna men alla har ju olika budget. 🙂 Hoppas på rejäla prissänkningar/GB framöver.[/quote]

Det brukar räcka om partitionerar klokt och har en mekanisk disk/extern disk vid sidan. Dock kan jag tänka att du syftar på din laptop där portabilitet är viktigt och där är väl ända lösning en extern disk, men har man pengarna så är ju en 240GB disk en ganska rejäl uppgradering mot 120GB

Jag kör bara en partion för C: på SSD:n just för att maximera vad jag får in på den. Saken är väl den att man blivit mer kräsen med vad man lagrar på SSD:n också. Jag menar faktiskt i min stationära nu, både den hemma och på kontoret. Jag har två spel installerade på den stationära hemma WoW och BF3. Sen är det program för resten och det är typ 5GB ledigt eller något.. Arbetsburken ligger ännu värre till med Adobe-sviten och alla pågående artiklar och dokument. Har ändå lyft över en hel del till min 2TB-disk men det är… Läs hela »

Kör en 60GB vertex2 idag och klarar mig bra på det med 2 spel installerade (varav ffxi tar ca 11GB) så 240 är definitivt overkill för min del men blir nog en 120 nästa gång för att vara på den säkra sidan. Känns dock inte som jag någonsinn kommer ha behov av 240 som C på en stationär men beror väl på vad man har för behov när det gäller program samt om man lägger in 10 spel åt gången.Hursomhelst ser jag mycket gärna fler tester på 120GB varianter. pga att prestandan ofta skiljer sig så markant tycker man att… Läs hela »

Precis som Anton säger så är det i första hand 120GB modeller som vi vill testa, då dessa är inressantast. Men oftast är det 240/256GB modeller som man får och då kan det vara riktigt svårt att få tag i 120GB exemplar. Angående storleken på C: så beror det VÄLDIGT mycket på vilken OS man kör.En ren XP installation hamnar brukar inte bli mycket mer än 2-3 GB (inklusive alla program som följer med) men väcer väldigt fort när det gör systemåterställningspunkter, installeras driverutiner och framförallt installerar uppdateringar. Windows 7 32bit blir betydligt större och hamnar ganska fort på 10GB… Läs hela »

Jag kör ovanstående setup med windows 7 64bit så 60Gb för windows 7 64bit är inte nödvädigtvis alldeles för litet då min windows install tar ca 9-11Gb. Dock så är det första jag gör att stänga av restore points (är den man sparar minst på och rekomenderar inte att stänga av om du inte vet vad du gör) och stänger av hibernation och tar bort hiberfil.sys som tar ca lika mycket plats som den egentliga installen (ta inte bara bort filen utan att stänga av funktionen), då jag tycker hibernation är bortkastade 10-15Gb på ett stationärt system. Förutom detta sätter… Läs hela »

Givetvis kan man slimmaner installationen och ta bort onödiga saker som man inte behöver använda. Jag tycker nog ändå aatt 60GB är för lite då man gärna vill ha plats över för overprovisoning. Då det är ganska snålt tilltaget som det är på de små diskarna.

Jag kommer nog rekomendera en Win 7 x64 install på mindre än 80GB 🙂

32bit kan man nog köra på 60GB däremot.

Håller med om att det är i minsta laget och som jag sa från början kommer bli en 120 för min egen del nästa gång för att inte behöva tänka på det, men ville bara visa att 60Gb är tillräckligt om man vill för att få med båda sidorna om någon som funderar på detta skulle råka läsa det här 🙂 (vad man än har för storlek på disken tycker jag dock 10-15Gb hibernation fil är totalt bortkastat utrymme på en staionär dator men det är jag) Hur som helst det jag ville få fram är att jag hoppas ni… Läs hela »

Jag är beredd att hålla med dig drizzit. Hibernation har faktiskt givit mig mer problem än vad det givit nytta. Maskiner som inte vill vakna på grund av taskiga drivrutiner osv. Det största problemet med att testa små enheter, är att det blir rätt ont om plats när vi kört vår testsvit. Ont om plats betyder högre Write Amplification och därmed sämmre prestanda. Men du har en poäng i att det även finns intresse för billigare SSDer. Om det är någon särskilld SSD som du önskade att vi testade, skriv här eller dra iväg ett mail till mig så ska… Läs hela »

Med billigare modeller menar jag nu i princip inte 30 och 60 då som vi redan kommit överens om 60Gb är i minsta laget men att iaf få med några 120 modeller och eventuellt kanske någon 90Gb av de märken som erbjuder dessa vore mycket intressant. Den första anledningen är att dessa modeller i dagsläget nog ger bäst kompromiss Gb/kr. Med kompromiss menar jag att visst en dubbelt så stor disk för dybbelt så mycket är samma Gb/kr men inte många mig inkluderad är beredd att lägga 4000+ på en system disk utan lägger hellre detta på lagringsdiskar. På grund… Läs hela »

Jag förstår mycket väl vad du pratar om Drizzit och det är något som jag ständigt försöker få till. Om vi bara får testa en enhet så väljer jag 120/128GB versionen i de flesta fall. Då dessa är de som är intressantast för läsare och konsumenter. Ibland har man tyvärr inget val, utan man får det man får och då får vi försöka sätta enheten i rätt kontext.Ibland har vi dock lite tur och får möjlighet att testa samma enhet, men i två olika storlekar. Då kan man enkelt jämföra dessa och se hur stor skillnad det faktiskt är.Mitt tips… Läs hela »

Intel 520 180GB är ju helt klart intressant! Om det är en 120GB man är ute efter dock känns det som att Samsung tar hem priset. Komprimeringstesten är väldigt intressanta btw, då det delvis kan återspegla hur disken presterar gällande krypterad data. Jag har för övrigt märkt att ni tar med samtliga tidigare SSD:er i graferna för varje nytt SSD-test – uppskattas! 🙂 Dock saknar jag detta på sidan “Städteknik och TRIM” (men hade ju behövts sammanställas på ett mer minimalt och överskådligt sätt isf). Kanske borde ni även skriva ut min/max-hastigheter också? Tyckte att ni nämnde att hastigheterna svajade… Läs hela »

[quote name=”POE”]Intel 520 180GB är ju helt klart intressant! Om det är en 120GB man är ute efter dock känns det som att Samsung tar hem priset.[/quote] Ja det är en ett bra “mellanting”. Faktum är att Sandforce enheter tappar väldigt mycket av sin “glans” när man kommer ner på 120GB. Den här enheten är en bra kompromiss för de som inte har rpd med 240GB. Dock så börjar de komma ner så pass i pris nu att även 200GB+ är inressanta för oss vanliga dödliga. Personligen hade jag nog tittat på en 250GB enhet i dagläget. [quote name=”POE”]Komprimeringstesten är… Läs hela »

Vill tacka för en givande diskussion ang C: size

För mig gav detta en del att fundera på inför kommande installationer 🙂

[quote name=”Chasm”]Vill tacka för en givande diskussion ang C: size

För mig gav detta en del att fundera på inför kommande installationer :-)[/quote]

Alla ev frågor är bara att ställa i forumet eller här. Det finns massor med folk som gärna svarar på dina frågor.

[quote name=”-Tjalve-“]ja jag har länge funderat på om jag inte skulle göra tester med en krypterad disk (typ True Crypt). Finns det något sådant intresse från er läsare?[/quote] Ja, tack, intresse finns, iaf från min sida. Tar det extra lång tid för man måste “kryptera igenom” hela disken? Annars kan man ju se krypterad data som okomprimerbar data bara och kolla på grafer för det, eller om det finns nåt test som istället för att skriva likadana 4ks block kan skriva random-genererade 4ks block? Om jag gjorde ett disktestprogram skulle jag defnitivt göra ett där man kan välja random/icke random… Läs hela »

[quote name=”Lagl0rden”]Ja, tack, intresse finns, iaf från min sida. Tar det extra lång tid för man måste “kryptera igenom” hela disken? Annars kan man ju se krypterad data som okomprimerbar data bara och kolla på grafer för det, eller om det finns nåt test som istället för att skriva likadana 4ks block kan skriva random-genererade 4ks block? Om jag gjorde ett disktestprogram skulle jag defnitivt göra ett där man kan välja random/icke random vilka block man ska skriva.[/quote] Ja att kryptera en hel disk är inte riktigt praktiskt. beroende på enhetens hastighet och storlek på disken, men det kan nog… Läs hela »

[quote name=”-Tjalve-“]ja jag har länge funderat på om jag inte skulle göra tester med en krypterad disk (typ True Crypt). Finns det något sådant intresse från er läsare? Det skulle ju ta väldigt lång tid att testa, och det är mycket därför som vi valt bort det i dagläget. Man kanske skulle kunna ta några olika enheter och bencha dem efter att de blivit krypterade för att se vad skillnaden blir?[/quote]Helt klart intressant. Det känns som att testerna med komprimerad data ger ungefär samma sak dock. Men testa kan man ju göra iaf, kanske dyker det upp nåt oväntat intressant… Läs hela »

[quote name=”POE”][quote name=”-Tjalve-“]ja jag har länge funderat på om jag inte skulle göra tester med en krypterad disk (typ True Crypt). Finns det något sådant intresse från er läsare? Det skulle ju ta väldigt lång tid att testa, och det är mycket därför som vi valt bort det i dagläget. Man kanske skulle kunna ta några olika enheter och bencha dem efter att de blivit krypterade för att se vad skillnaden blir?[/quote]Helt klart intressant. Det känns som att testerna med komprimerad data ger ungefär samma sak dock. Men testa kan man ju göra iaf, kanske dyker det upp nåt oväntat… Läs hela »