I vår senaste recension tar vi en titt på NVIDIAs senaste grafikkrets ur ett mer humant perspektiv än vi gjort fram tills nu. Vi erbjuder er här helt enkelt en bild av GeForce 8800 GTX under mer normala förhållanden.

Grafikkortslanseringar ser vi ofta ett par nya varje vecka och då handlar det oftast om olika tillverkare som släpper kort på de för tillfället mest populära kretsarna. Med ett par månaders mellanrum brukar de lite större lanseringarna dyka upp när till exempel NVIDIA eller ATI lanserar en nya serie av grafikkort och då finns det såklart mer intressant att skriva om. NVIDIA G71 var en trevlig uppdatering när GeForce 7900-serien först lanserades och likaså ATIs motsvarighet R580 och deras X1900-serie. Men i ärlighetens namn var det inte mycket som skiljde de nya grafikkretsarna från de gamla, ett märkbart lyft i prestanda är aldrig fel men vi har med åren blivit lite för kräsna för att vi ska få våra begär mättade av dessa lanseringar. De tillfällen vi verkligen väntar på är när NVIDIA och ATI bestämmer sig för att börja om på ny kula och lansera en helt ny arkitektur, vilket är precis vad NVIDIA gjort nu med lanseringen av G80-arkitekturen.

Vi har redan publicerat en kortare förhandstitt på NVIDIA nya G80-arkitektur och primärt deras nya flaggskepp GeForce 8800 GTX men när nu NVIDIA lanserar en helt ny arkitektur är vi självklart inte nöjda med att bara bjuda på en förhandstitt. Nästa steg i vår rapportering av G80-arkitekturen är den fullskaliga recension ni läser för tillfället och här kommer vi gå in närmare på hur NVIDIA utvecklat sina nya arkitektur, hur den skiljer sig från nuvarande grafikkortsarkitekturer och självklart hur GeForce 8800 GTX presterar jämfört med sina konkurrenter. Först ska vi kika närmare på just GeForce 8800 GTX och hur G80-arkitekturen som kortet använder sig av är uppbyggd.

Grafikkortet som vi längtat efter längre än vi tror är här, GeForce 8800GTX har anlänt i testlabbet och finns tillgänligt i butiker i världen över. Alltid när ATI eller NVIDIA lanserar ett nytt grafikkort brukar dem generellt hävda att det är en ny arkitektur. Sanningen är dock att det ofta är en förfinad eller utbyggd version av en redan beprövad arkitektur. I detta fallet är dock helt sant, grafikkretsen som ryms på 8800GTXs långa svarta kort är en helt ny design. Vi börjar med att ta en titt på en jämförelse av specifikationerna.

nVidia referens frekvenser, kan variera mellan tillverkare.

** nVidia referens, beror av frekvenserna.

När NVIDIA sommaren 2002 tillsatte gruppen som skulle utveckla G80 hade dem flera mål, varav de två viktigaste var markant prestandaökning och förbättrad bildkvalité med nya funktioner. Frågan var dock hur ska man kunna nå dessa mål; fortsätter man på samma linje som man gjort tidigare, eller gör man en grundlig förändring? Allting som existerar kommer till en punkt då något radikalt måste hända i grundstrukturen för att slutresultatet skall göra en väsentlig skillnad. Kanske inte den mest vettiga meningen men den ger oss en bra start på hur vi ska förklara vilket stort steg NVIDIA tagit med sin nya generation grafikprocessorer. Det finns exempel på radikala förändringar som klart varit till det sämre. Ett exempel är när Kinas diktator Mau fick den briljanta idén att kommunismens röda färg skulle betyda kör/gå och grönt stanna. Givetvis slutade detta i rekordmånga trafikolyckor och dödsfall i trafiken när totalt kaos förekom.

Vart vi vill komma är att alla visste att G80 skulle betyda en radikal förändring jämfört med tiigare grafikprocessorarkitekturer. Något som skapade stor förvirring och många rykten som spred sig som en löpeld över internet. Den största oron som uppstod var att NVIDIA skulle ha låtit kompromissa prestandan för befintliga DirectX 9 baserade applikationer för att ge plats för DirectX 10. Med facit i hand kan vi säga att så absolut inte är fallet. G80 och GeForce 8800GTX visar prov på fantastisk prestanda ihop med bildkvalité.

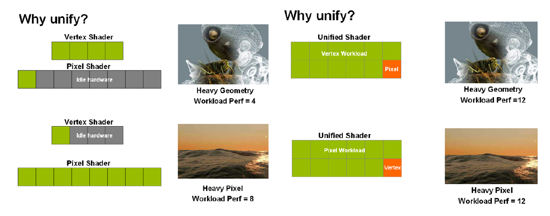

Den fundamentala förändringen vi försöker förklara mellan raderna är det nya begreppet “Unified Shader”. Tidigare generationer av grafikprocessorer har haft en given mall med en iven sekvens där pixel data skcikades till pixel shderns och vertex data skickades till vertex shaders. Låt oss föreställa oss ett grafikkort med enbart 10 shaders totalt. 6 för pixel instruktion och 4 för vertex.

För att förenkla det säger vi att all realtidsrenderad grafik är en balans mellan pixel och vertex shading. En speciell omgivning och händelse i ett spel använder olika många pixel respektive vertex instruktioner. Vid ett tillfälle kan vi ha en belastning med 90% pixel shading och nästa sekund tvärt om. Med andra ord hade vi i det läget haft en full pixel pipe medan vertexsidan eventuellt varit tom. Det betyder att de föregående generationerna grafikprocessorer hade haft en stor del av sin kapacitet oanvänd, det är inget konstigt, så har det alltid varit. Med Unified shaders försvinner detta då G80’s alla 128 shaders kan allokeras dynamiskt och utföra både pixel och vertex instruktioner (även geometriska instruktioner för DX10), vilket betyder att effektiviteten blir avsevärt mycket bättre..

Efter att vi fått en lätt förståelse kring den största skillnaden med G80 forsätter vi nästa sida med att ta en titt på arkitekturen i sin helhet med fokus på G80 nya minnesgränssnitt.

Som vi sagt implementerar GeForce 8800GTX 128 skalbara streaming processors (shaders) som vardera tickar på i 1350MHz. Det faktum att dem är helt oberoende av varandra och skalbara gör att gpuns resurser kan utnyttjas till max. Något som både ATI och NVIDIA alltid strävar efter. ATI:s kommande grafikkrets som går under arbetsnamnet R600 kommer också att fungera med oberoende shaders.

Komplett blockdiagram över G80-kretsen.

De gröna blocken illustrerar hur alla streaming processors är gruperade och placerade i G80 designen. Den största skillnaden mellan 8800:s streaming processors och 7900:s shaders är dem är klockade betydligt högre (650MHZ mot 1350MHz) och kan placeras i närmare varandra i stora grupper, alltså ett större antal på motsvarande yta. Varje streaming processor producerar ett datasegemnt som en annan streaming processor kan ta emot och fortsätta arbeta med. Cache-minnet används för att spara dessa datasegment eller dataströmmar.

En av de stora nyheterna med 8800:s streaming processors är att dem är skalbara istället för vektorbaserade. Något som är helt naturligt då många instruktioner för grafik använder sig av en vektorform, tex RGBA om det handlar om färger i en pixel. Men en skalbar instruktionsform blir allt mer vanlig i nya grafikapplikationer så det är utan tvekan ett bra drag från NVIDIAS sida att även här bygga upp det från början. Teoretiskt kan en skalbar shader ge upp till dubbel prestanda enligt NVIDIA om applikationen är skriven skalbart. Men även om vi bara räknar lite snabbt och tar ett exempel på två instruktioner. Den ena låter vi bestå av en multiplikation av en pixelgrupp med två variabler (pixlar*xy). Den andra är en addition av en annan variabel till samma pixellgrupp (pixlar+a). Vi ska sedan tillämpa dessa instruktioner på 16 pixlar. För att förstå detta behöver man veta att en av 7900s shaders arbetar med fyra pixlar per klockcykel och kan utföra två olika instruktioner på varje cykel (tex multiplikation och addition), medan 8800:s skalbara shader jobbar med 16 pixlar och kan utföra en instruktion per klockcykel. (notera att detta är en grov förenkling). 7900 behöver således 4 cykler medans 8800 bara 3 för att slutföra operationen. 8800 har en tolkningsenhet som tolkar instruktioner i vektorformat och delar upp den första instruktionen i två delar (pixelgrupp*x och pixelgrupp*y). Detta resulterar i 25% bättre prestanda med samma beräkningsresurser för 8800 jämfört med föregånge grafikkretsar.

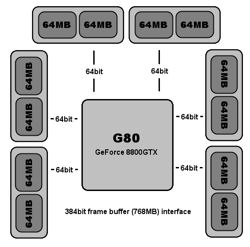

För att den råa processorkraft som 8800 erbjuder skall kunna levereras rättvist till skärmen krävs ett kraftfullt gränssnitt för att lagra färdiga pixlar och texturer. För att möta det nya kravet har NVIDIA utökat antalet ROP:s till 24 från tidigare 16 och antalet minneskanaler till sex stycken med 128MB (768MB totalt) minne i vardera. Varje kanal har ett individuellt gränssnitt på 64bit som totalt resulterar i 384bit. Det är samma princip som gäller för grafikkort som vanligt internminne till systemet. Singel channel DDR2 har en bus på 64bit och en dual channel har en bus på 2×64=128bit.

En illustation över hur minnesgränssnittet är

uppbyggt kring G80.

Vi forsätter recensionen med att ta en titt på testsystemet innan vi går vidare till benchmarks.

Med GeForce 8800 introducerar NVIDIA ett nytt koncept för deras satsning på bättre bildkvalité och bildförbättringar. Detta koncept introducerar fyra nya typer av antialiasing för singel-gpu; 8x, 8xQ, 16x, och 16xQ. Skillnaden mellan de vanliga och 8xQ samt 16xQ är att de sistnämnda erbjuder extra hög kvalité. Nytt för NVIDIA är också att 8800GTX har stöd för HDR och antialiasing samtidigt (både FP16 och FP32). Tidigare har detta bara fungerat på ATIs radeon 1k-serie. Värt att notera är att spel som Oblivion inte har ett nativt stöd för HDR+AA. Därför måste man inaktivera AA i spelets grafikinställningar och istället aktivera AA via NVDIAs kontrollpanel, samma gäller för ATI. Detta har inget att göra med NVDIAS eller ATI mjuk- eller hårdvara utan att spelet inte är designat att köra HDR när AA är aktiverat.

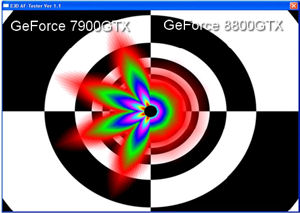

Anisotropic Filtering är en bildförbättringsfunktion som ökar djupet och klarheten i texturer. Även här har vi en nyhet för NVIDIA med GeForce 8800GTX vilket är att Anisotropic Filtering även fungerar på texturer i vinkel. ATI:s 1k-serie har sedan tidigare även stöd för detta. Hur som helst förbättrar “Angular AF” avsevärt den totala effekten av Anisotropic Filtering. I de tester vi gjort mellan GeForce 7900GTX, Radeon X1950XTX och GeForce 8800GTX i spel som Oblivion och Half Life 2 så visar det på att GeForce 8800GTX ger ett marginellt bättre resultat än Radeon X1950XTX och markant bättre än GeForce 7900GTX. För att ändå ge en illustration på hur stor skillnaden ändå är har vi två syntetiska exempel framtagna med D3D AF-tester 1.1.

Jämförelse av GeForce 7 och GeForce 8.

Jämförelse av Radeon X1950XTX och GeForce 8.

Prestandamässigt är Anisotropic Filtering mycket påfrestande för minnet. GeForce 8800GTX:s nya mycket effektiva minnesgränssnitt med en total buffert på 768MB märks mycket tydligt då man knappt märker att man använder Anisotropic Filtering istället för Isotropic Filtering förrän man kommer upp till 16x. Det står helt klart, GeForce 8800GTX erbjuder inte bara rå prestanda utan också enastående bildkvalité.

Vi fortsätter recensionen med att ta en titt på testsystemet innan vi går vidare till benchmarks.

När Conroe lanserades i höstas innebar det ett stort framsteg i systemprestanda, det största vi sett på mycket länge. Något som var ytterst välkommet av high-end gamers och benchare pga att deras high-end grafikkkort – framförallt i multi-gpu konfigurationer – inte låtits leva ut till sin fulla potential. Nu när NVIDIA lanserar sin nya generation grafikkort tar grafikkortsprestandna ytterligare gigantiskt språng, den fördubblas. Än en gång är processorn och systemet med andra ord en flaskhals. Systemet i övrigt är alltså alltid väldigt viktig för prestandaresultatet för nya high-end grafikkort.

| |

| Hårdvara | |

| Moderkort | Intel Bad Axe 2 |

| Processor | Intel Core 2 Extreme X6800 |

| Minne | Corsair PC6400C3 2x1024MB |

| Hårddisk | WD Raptor 36GB 10 000 RPM |

| Monitor | Dell UltraSharp 2405FPW |

| Grafikkort | XFX GeForce 8800GTX 768MB ATI Radeon X1950XTX 512MB |

| Nätaggregat | Cooltek 600W |

| Mjukvara | |

| Operativsystem | Windows XP (SP2) |

| Drivrutiner | Catalyst 6.10 ForceWare 96.89 |

| Testprogram |

3DMark 01SE |

Vi fortsätter recension med speltester.

| Inställning: | Värde: |

| Soft Shadows | Off |

F.E.A.R är fortfarande ett av av de mest grafikkortskrävande spelen som finns. Vi ser tydligt hur påfrestade grafikkorten blir. 8800GTX verkar ha problem med att hålla upp takten, forfarande en bra bit före motståndet dock.

Nästa spel på tur är Quake 4.

Quake 4 som bygger på Doom 3-motorn har alltid favoriserat Nvidia grafikkort. Nu snackar vi försprång. GeForce 8800GTX springer ifrån motståndet med hästlängder. I 1920×1200 ser vi dubbelt så hög fps med 8800GTX jämfört med 7900GTX.

Nästa spel på tur är Tomb Raider: Legend.

| Inställning: | Värde: |

| Next Gen | On |

De nyaste bland våra speltester är det nya tillskottet i spelserien med Lara Croft i huvudrollen, Tom Raider: Legend. Vilket är ett mycket krävande spel som innehåller flertalet purfärska renderingstekniker. Här spelar hela systemet inklusive grafikkortet stor roll. Med Next Gen och HDR aktiverat är det bland de mest krävande spelen idag. 8800GTX visar prov på sin enorma stryka även med mycket förbättringstekniker.

Vi fortsätter speltesterna med Half Life 2: Lost Coast.

| Inställning: | Värde: |

| Next Gen | On |

Half Life 2 med sin source-motor har visat sig vara mycket flexibel när det kommer till att efterarbeta och implementera nya tekniker. Faktum är att source motorn stöder HDR+AA ovasett vilket DX9 grafikkort man använder. Man kan alltså köra HDR+AA med även med Nvidia 7900GTX i Half Life 2. 8800GTX tar hem prestandatronen med en förhållandevis liten marginal.

Nästa spel på tur är Oblivion.

Oblivion är det senaste spelet i Elder Scrolls-serien och erbjuder mycket imponerande grafik i rollspelskaratär med mycket utomhusmiljö. GeForce 8800GTX med sin enorma prestanda får verkligen komma till rätta här, vi ser prov på dubbelt så hög fps jämfört med motståndet.

NVIDIA har med G80 tagit fram en helt ny grafikkortsarkitektur som det faktiskt för ett knappt år sedan var få som trodde skulle komma från just NVIDIA. Alla pratade om att ATI skulle vara först ut med en förenad shader arkitektur på grafikkortsmarknaden, speciellt efter att man utvecklat en liknande krets för Microsofts spelkonsol Xbox 360. Samtidigt sa de första rapporterna om G80 att NVIDIA inte skulle känna att marknaden var mogen för en förenad shader arkitektur. Som många andra rykten kring G80 har detta visat sig vara falskt och NVIDIA har nu levererat en helt ny och mycket spännande grafikkortsarkitektur som inte bara kommer att bli intressant i Windows Vista och med DirectX 10 utan även visat framfötterna redan idag. Många var rädda för att G80 skulle få det svårt att hävda sig med en förenad shader arkitektur innan DirectX 10 lanserads i och med Vista, men vi kan med glädje meddela att så verkligen inte är fallet.

Redan för ett par veckor sedan hade vi mycket positivt att säga om NVIDIA och deras GeForce 8800 GTX grafikkort som vi då bara hade haft nöjet att testa ett par dagar i testlabbet. I vår förhandstitt där vi fokuserade på överklockning kunde vi redan se de enorma prestandapotential som G80-arkitekturen, och GeForce 8800 GTX i synnerhet, besitter. Innan vi gav något slutgiltig omdöme kring NVIDIAs senaste flaggskepp ville vi även ge kortet en tuff match i den miljö vi tror de flesta GeForce 8800 GTX grafikkort trots allt kommer arbeta. I en högklassig speldator där man är ute efter optimal prestanda och bildkvalité.

I dagsläget finns varken Windows Vista eller DirectX 10 på marknaden, vi behöver inte ens gå in på avsaknaden av spel utvecklade för den nya DirectX-versionen. Vi har därför inte haft något annat val än att testa NVIDIAs nya flaggskepp med dagens spel som använder sig av DirectX 9 och Shader Model 3.0 effekter. För dem som tvivlat på hur en förenad shader arkitektur skulle klara av dagens spel kan vi bara be er att återigen gå igenom våra prestandaresultat. GeForce 8800 GTX fullkomligen krossar motståndet även i dagens spel och desto mer grafikeffekter man slänger på desto större blir skillnaderna. ATIs Radeon X1950 XTX som hittills varit det snabbaste singel-GPU grafikkortet på marknaden har inte skuggan av en chans och inte heller NVIDIAs GeForce 7950GX2 med dubbla G71-kärnor är ens i närheten. Det är helt enkelt en ny generations grafikkrets vi ser och prestandan vittnar om detta mer än något annat.

NVIDIA har även lärt sin läxa vad gäller bildkvalité och som våra tester visar har man klart märkbart förbättrat sin texturfiltreringsteknik men leverarar även nya kantutjämningstekniker för singel-grafikkort för dem som vill pressa ur den där sista gnuttan bildkvalité. Som vi nämnde i vår förhandstitt är GeForce 8800 GTX ett rätt maffigt kort med en stor och tung kylare. Men kylaren behövs då nästan 700 miljoner transistorer har en hel del värme att dela med sig av. NVIDIA har dock lyckats kyla sitt kort effektivt och faktiskt ganska tyst men just värmeutvecklingen och strömförbrukningen är egentligen de enda märkbara negativa bitarna med GeForce 8800 GTX. Den sista pusselbiten som också kan vara något svår att svälja är priset, runt 5500 kronor får man ge för ett GeForce 8800 GTX i dagsläget och det är en ordentlig summa pengar. Men då ska man ha i åtanke att kortet levererar bättre prestanda än två GeForce 7900 GTX-grafikkort i SLI, vilket kostar desto mer. GeForce 8800 GTX är helt enkelt det bästa grafikkortet på marknaden och den enda frågan man som konsument ska ställa sig är om man verkligen behöver den kraft som finns i detta kort. Är svaret ja så borde pengar inte heller vara ett problem med tanke på vilka komponenter i övrigt som behövs för att hänga med i svängarna. XFX GeForce 8800 GTX är utan några som helst tvivel värt vår redaktörens val utmärkelse och nu ser vi bara fram emot fler grafikkort baserade på NVIDIAs G80-arkitektur.